Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

PUMP la venta pública ha terminado, originalmente yo también tenía una gran cantidad en Bybit, solo dejé 1/2 en la cadena, al final solo logré ejecutar en la cadena, afortunadamente no hice cobertura anticipada...

Hablando de eso, últimamente en la comunidad de IA hay muchas personas discutiendo sobre VLA (Vision‑Language‑Action)

Investigué un poco si hay proyectos en la cadena que estén trabajando en VLA, y vi este proyecto CodecFlow @Codecopenflow, compré un poco.

== ¿Qué hace el proyecto CodecFlow? ==

Una breve introducción a VLA, VLA es una arquitectura de modelo que permite que la IA no solo "pueda hablar", sino que "pueda hacer".

Los LLM tradicionales (como GPT) solo pueden entender el lenguaje, proporcionar sugerencias, pero no pueden realizar acciones, no pueden hacer clic en la pantalla, ni agarrar objetos.

El modelo VLA significa que integra tres grandes capacidades:

1. Visión: entender imágenes, capturas de pantalla, entradas de cámaras o datos de sensores

2. Lenguaje: comprender instrucciones en lenguaje natural humano

3. Acción: generar instrucciones ejecutables, como clics del ratón, entradas de teclado, controlar brazos robóticos

CodecFlow está trabajando en VLA en la cadena, todos los procesos operativos también se pueden registrar en la cadena, auditar, verificar y liquidar.

En resumen, es la infraestructura básica de un "robot de IA".

== ¿Por qué presté especial atención a este proyecto? ==

Descubrí que sus desarrolladores son contribuyentes clave del proyecto de código abierto más popular en el campo de VLA, LeRobot.

LeRobot es la base de élite para construir modelos VLA en el mundo del código abierto, incluyendo SmolVLA, que puede ejecutarse en laptops.

Esto significa que este equipo realmente entiende la arquitectura VLA y los robots.

He visto que también continúan construyendo, el precio del token también está aumentando de manera estable, yo personalmente tengo mucha fe en la pista de VLA, y desde una perspectiva general, VLA y los robots definitivamente son el futuro en el mercado.

• Los gigantes de Web2 (Google, Meta, Tesla) actualmente están invirtiendo todo en el entrenamiento de VLA y robots;

• Hay muy pocos proyectos de Web3 que puedan ejecutar aplicaciones de VLA, lo cual es muy escaso

• VLA tiene la oportunidad de generar un gran valor en escenarios como DePIN, Automatización Web, y ejecución de Agentes de IA en la cadena.

CA: 69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Siempre haz tu propia investigación.

26 jun 2025

¿Qué es un operador $CODEC?

Es donde los modelos de Visión-Lenguaje-Acción finalmente hacen que la IA sea útil para el trabajo real.

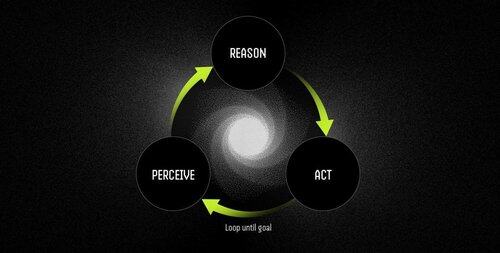

Un operador es un agente de software autónomo impulsado por modelos VLA que realiza tareas a través de un ciclo continuo de percibir-razonar-actuar.

Los LLM pueden pensar y hablar brillantemente, pero no pueden señalar, hacer clic o agarrar nada. Son motores de razonamiento puros sin conexión con el mundo físico.

Los VLA combinan percepción visual, comprensión del lenguaje y salida de acción estructurada en una sola pasada hacia adelante. Mientras un LLM describe lo que debería suceder, un modelo VLA realmente lo hace al emitir coordenadas, señales de control y comandos ejecutables.

El flujo de trabajo del operador es:

- Percepción: captura capturas de pantalla, transmisiones de cámara o datos de sensores.

- Razonamiento: procesa observaciones junto con instrucciones en lenguaje natural utilizando el modelo VLA.

- Acción: ejecuta decisiones a través de interacciones de UI o control de hardware, todo en un bucle continuo.

Ejemplos: LLM vs. Operador impulsado por el modelo VLA

Programación de una reunión

LLM: Proporciona una explicación detallada de la gestión del calendario, describiendo los pasos para programar una reunión.

Operador con modelo VLA:

- Captura el escritorio del usuario.

- Identifica la aplicación de calendario (por ejemplo, Outlook, Google Calendar).

- Navega hasta el jueves, crea una reunión a las 2 PM y añade asistentes.

- Se adapta automáticamente a los cambios en la interfaz de usuario.

Robótica: Clasificación de objetos

LLM: Genera instrucciones escritas precisas para clasificar objetos, como identificar y organizar componentes rojos.

Operador con modelo VLA:

- Observa el espacio de trabajo en tiempo real.

- Identifica componentes rojos entre objetos mezclados.

- Planifica trayectorias libres de colisiones para un brazo robótico.

- Ejecuta operaciones de recoger y colocar, ajustándose dinámicamente a nuevas posiciones y orientaciones.

Los modelos VLA finalmente cierran la brecha entre la IA que puede razonar sobre el mundo y la IA que realmente puede cambiarlo. Son lo que transforma la automatización de un seguimiento frágil de reglas a una resolución de problemas adaptativa: trabajadores inteligentes.

"Los scripts tradicionales se rompen cuando el entorno cambia, pero los operadores utilizan la comprensión visual para adaptarse en tiempo real, manejando excepciones en lugar de colapsar ante ellas."

10,78K

Parte superior

Clasificación

Favoritos