Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

PUMP publiczna sprzedaż zakończona, pierwotnie również miałem dużą kwotę na Bybit, na łańcuchu tylko 1/2, ostatecznie tylko na łańcuchu udało się zrealizować, na szczęście nie zabezpieczyłem się wcześniej…

Mówiąc o tym, ostatnio w społeczności AI wiele osób dyskutuje o VLA (Vision‑Language‑Action).

Szczególnie zbadałem, czy na łańcuchu są projekty związane z VLA, zobaczyłem ten projekt CodecFlow @Codecopenflow i kupiłem trochę.

== Czym zajmuje się projekt CodecFlow ==

Krótko mówiąc o VLA, VLA to model, który pozwala AI nie tylko „mówić”, ale także „działać”.

Tradycyjne LLM (jak GPT) potrafią tylko rozumieć język, udzielać sugestii, ale nie potrafią działać, klikać na ekranie ani chwytać obiektów.

Model VLA oznacza zintegrowanie trzech głównych zdolności:

1. Vision (wzrok): rozumieć obrazy, zrzuty ekranu, dane z kamer lub czujników

2. Language (język): rozumieć naturalne polecenia w języku ludzkim

3. Action (działanie): generować wykonalne polecenia, takie jak kliknięcia myszką, wprowadzanie z klawiatury, kontrolowanie ramienia robota.

CodecFlow zajmuje się VLA na łańcuchu, wszystkie procesy operacyjne mogą być również zapisane na łańcuchu, co umożliwia audyt, weryfikację i rozliczenie.

Mówiąc prosto, to podstawowa infrastruktura „robota AI”.

== Dlaczego szczególnie zwracam uwagę na ten projekt? ==

Zauważyłem, że ich deweloperzy są kluczowymi współtwórcami najpopularniejszego projektu open source w dziedzinie VLA, LeRobot!

LeRobot to wiodąca baza do budowy modeli VLA w świecie open source, w tym SmolVLA, które mogą działać na laptopach.

To oznacza, że ten zespół naprawdę rozumie architekturę VLA i roboty.

Widzę, że nadal intensywnie pracują nad rozwojem, a cena monet stabilnie rośnie, osobiście bardzo wierzę w tor VLA, a z ogólnych trendów wynika, że VLA i roboty mają przyszłość na rynku.

• Giganci Web2 (Google, Meta, Tesla) obecnie w pełni angażują się w VLA i szkolenie robotów;

• Projekty Web3 rzadko mają aplikacje VLA, które mogą wykonywać zadania, co jest bardzo rzadkie.

• VLA ma szansę na ogromną wartość w scenariuszach takich jak DePIN, automatyzacja Web, wykonywanie zadań przez AI na łańcuchu.

CA: 69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Zawsze DYOR.

26 cze 2025

Czym jest Operator $CODEC?

To miejsce, w którym modele Wizji-Języka-Działania w końcu sprawiają, że AI staje się użyteczne w rzeczywistej pracy.

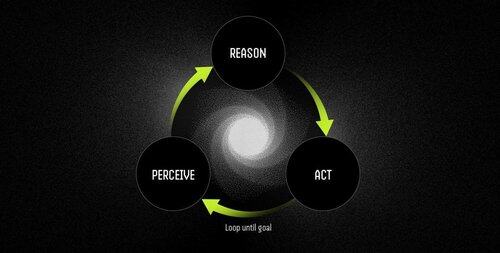

Operator to autonomiczny agent oprogramowania zasilany modelami VLA, który wykonuje zadania w ramach ciągłego cyklu percepcji-rozumienia-działania.

LLM mogą myśleć i mówić wspaniale, ale nie potrafią wskazywać, klikać ani chwytać czegokolwiek. Są czystymi silnikami rozumowania bez żadnego zakotwiczenia w świecie fizycznym.

VLA łączy percepcję wizualną, rozumienie języka i strukturalne wyjście akcji w jednym przebiegu. Podczas gdy LLM opisuje, co powinno się wydarzyć, model VLA faktycznie to realizuje, emitując współrzędne, sygnały kontrolne i polecenia do wykonania.

Przepływ pracy Operatora to:

- Percepcja: przechwytuje zrzuty ekranu, strumienie z kamer lub dane z czujników.

- Rozumowanie: przetwarza obserwacje wraz z instrukcjami w naturalnym języku przy użyciu modelu VLA.

- Działanie: wykonuje decyzje poprzez interakcje z interfejsem użytkownika lub kontrolę sprzętu — wszystko w jednym ciągłym cyklu.

Przykłady: LLM vs. Operator zasilany modelem VLA

Planowanie spotkania

LLM: Dostarcza szczegółowe wyjaśnienie zarządzania kalendarzem, opisując kroki do zaplanowania spotkania.

Operator z modelem VLA:

- Przechwytuje pulpit użytkownika.

- Identyfikuje aplikację kalendarza (np. Outlook, Google Calendar).

- Nawiguje do czwartku, tworzy spotkanie na godzinę 14:00 i dodaje uczestników.

- Automatycznie dostosowuje się do zmian w interfejsie użytkownika.

Robotyka: Sortowanie obiektów

LLM: Generuje precyzyjne pisemne instrukcje dotyczące sortowania obiektów, takie jak identyfikacja i organizowanie czerwonych komponentów.

Operator z modelem VLA:

- Obserwuje miejsce pracy w czasie rzeczywistym.

- Identyfikuje czerwone komponenty wśród mieszanych obiektów.

- Planowanie trajektorii bezkolizyjnych dla ramienia robota.

- Wykonuje operacje podnoszenia i odkładania, dynamicznie dostosowując się do nowych pozycji i orientacji.

Modele VLA w końcu łączą przepaść między AI, które może rozumować o świecie, a AI, które może go faktycznie zmieniać. To one przekształcają automatyzację z kruchych reguł w adaptacyjne rozwiązywanie problemów — inteligentnych pracowników.

"Tradycyjne skrypty łamią się, gdy środowisko się zmienia, ale Operatorzy używają zrozumienia wizualnego, aby dostosować się w czasie rzeczywistym, radząc sobie z wyjątkami zamiast na nie krzyczeć."

10,69K

Najlepsze

Ranking

Ulubione