Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

A venda pública da PUMP acabou, originalmente eu também era uma grande quantia na Bybit, apenas 1/2 na cadeia, e no final, apenas a cadeia foi bem-sucedida, felizmente não houve hedge antecipado...

Recentemente, tem havido muita discussão na comunidade de IA sobre VLA (Visão-Linguagem-Ação)

Em particular, fui pesquisar se havia alguém fazendo projetos relacionados ao VLA na rede, e vi esse CodecFlow@Codecopenflow projeto e comprei um pouco.

== O que o CodecFlow está fazendo ==

Uma breve introdução ao VLA, uma arquitetura de modelo que permite que a IA não apenas "fale", mas "faça".

Os LLMs tradicionais (como o GPT) só podem entender a linguagem e dar sugestões, mas não podem fazer hands-on, clicar em telas ou pegar objetos.

O modelo VLA significa que ele integra três recursos:

1. Visão: entenda imagens, capturas de tela, entradas de câmera ou dados do sensor

2. Linguagem: Entenda as instruções de linguagem natural humana

3. Ação: Gere comandos executáveis, como cliques do mouse, entrada de teclado e controle do braço robótico

O CodecFlow está fazendo o VLA na cadeia, e todos os processos também podem ser carregados na cadeia, que podem ser auditados, verificados e liquidados.

Em termos simples, é a infraestrutura de um "bot de IA".

== Por que estou prestando atenção especial a este item? ==

Descobri que seus desenvolvedores são os principais colaboradores do LeRobot, o projeto de código aberto mais quente no espaço VLA!

A LeRobot é a principal base para a construção de modelos de VLA no mundo de código aberto, incluindo VLAs leves que podem ser executados em laptops como o SmolVLA.

Isso significa que essa equipe realmente entende a arquitetura VlA e o Robot.

Vejo que eles também continuam a crescer, e o preço da moeda também está subindo de forma constante, estou muito otimista sobre a faixa do VLA e, pela tendência geral, o VLA e os robôs são de fato o futuro no mercado.

• Os gigantes da Web2 (Google, Meta, Tesla) agora estão totalmente comprometidos com o VLA e o treinamento de bots;

• Projetos Web3 são escassos em termos de aplicativos VLA que podem executar tarefas

• O VLA tem a oportunidade de desempenhar um papel importante em cenários como DePIN, automação da Web e execução de agentes de IA on-chain.

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Sempre DYOR。

26 de jun. de 2025

O que é um Operador $CODEC?

É onde os modelos Visão-Linguagem-Ação finalmente tornam a IA útil para o trabalho real.

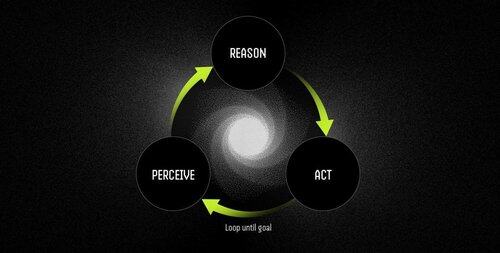

Um operador é um agente de software autônomo alimentado por modelos VLA que executa tarefas por meio de um ciclo contínuo de percepção-razão-ação.

Os LLMs podem pensar e falar de forma brilhante, mas não podem apontar, clicar ou pegar nada. Eles são motores de raciocínio puro com zero base no mundo físico.

Os VLAs combinam percepção visual, compreensão da linguagem e saída de ação estruturada em uma única passagem para frente. Enquanto um LLM descreve o que deve acontecer, um modelo VLA realmente faz isso acontecer emitindo coordenadas, sinais de controle e comandos executáveis.

O fluxo de trabalho do operador é:

- Percepção: captura capturas de tela, feeds de câmera ou dados de sensores.

- Raciocínio: processa observações junto com instruções de linguagem natural usando o modelo VLA.

- Ação: executa decisões por meio de interações de interface do usuário ou controle de hardware, tudo em um loop contínuo.

Exemplos: LLM vs. Operador Powered by VLA Model

Agendando uma reunião

LLM: Fornece uma explicação detalhada do gerenciamento de calendário, descrevendo as etapas para agendar uma reunião.

Operador com modelo VLA:

- Captura a área de trabalho do usuário.

- Identifica o aplicativo de calendário (por exemplo, Outlook, Google Calendar).

- Navega até quinta-feira, cria uma reunião às 14h e adiciona participantes.

- Adapta-se automaticamente às alterações da interface do usuário.

Robótica: Classificando Objetos

LLM: Gera instruções escritas precisas para classificar objetos, como identificar e organizar componentes vermelhos.

Operador com modelo VLA:

- Observa o espaço de trabalho em tempo real.

- Identifica componentes vermelhos entre objetos mistos.

- Planeja trajetórias sem colisões para um braço robótico.

- Executa operações de pick-and-place, ajustando-se dinamicamente a novas posições e orientações.

Os modelos VLA finalmente preenchem a lacuna entre a IA que pode raciocinar sobre o mundo e a IA que pode realmente mudá-lo. Eles são o que transformam a automação de um frágil cumprimento de regras em uma solução adaptativa de problemas – trabalhadores inteligentes.

"Os scripts tradicionais quebram quando o ambiente muda, mas os operadores usam a compreensão visual para se adaptar em tempo real, lidando com exceções em vez de travar nelas."

10,69K

Melhores

Classificação

Favoritos