Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

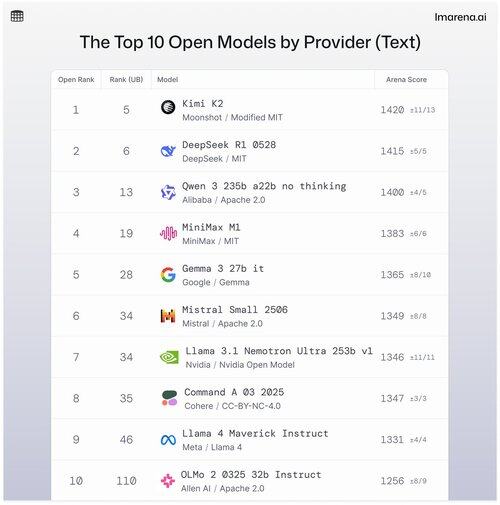

🧵Topp 10 öppna modeller efter leverantör

Även om proprietära modeller ofta toppar listorna, paras öppna modeller också ihop i stridsläge och rankas på våra offentliga topplistor.

Här är de 10 bästa när de staplas efter topp öppen modell efter leverantör.

- #1 Kimi K2 (Modifierad MIT) @Kimi_Moonshot

- #2 DeepSeek R1 0528 (MIT) @deepseek_ai

- #3 Qwen 235b a22b inget tänkande (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b det (Gemma) @googledeepmind

- #6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Lama 3.1 Nemotron Ultra 253b v1 (Nvidia öppen modell) @nvidia

- #8 Kommando A (Kohere) @cohere

- #9 Lama 4 Maverick instruera (Lama 4) @aiatmeta

- #10 OLMo 2 32b Instruera (Apache 2.0) @allen_ai

Se tråden för att lära dig lite mer om topp 5 i den här listan 👇

Kimi K2 - #1 i den öppna arenan!

Om du har uppmärksammat modeller med öppen källkod, gör den här nya modellen från det stigande AI-företaget, Moonshot AI, vågor som en av de mest imponerande LLM:erna med öppen källkod hittills. Vår community berättar för oss att de också älskar hur Kimi K2 svarar: Kimi är humoristisk utan att låta för robotisk.

Kimi K2 bygger på en Mixture-of-Experts (MoE) arkitektur, med totalt 1 biljon parametrar, varav 32 miljarder är aktiva under en given inferens. Den här designen hjälper modellen att balansera effektivitet och prestanda på begäran.

DeepSeeks bästa öppna modell, DeepSeek R1-0528, rankas #2

R1-0528 är en förfinad instruktionsinställd version av R1 och den #2 bästa öppna chattmodellen enligt communityn. Stark i dialog- och resonemangsuppgifter med flera turer.

R1 (baseline) är originalet, fortfarande solid men nu något efter nyare tuningvarianter.

V3-0324 är en MoE-modell med totalt 236B parametrar, men aktiverar endast ett fåtal experter per prompt. Detta gör den både kraftfull och effektiv. Det fungerar bra i instruktioner, resonemang och flerspråkiga uppgifter, men promptformatet är viktigare här än med R1-0528.

Qwen 235b a22b (inget tänkande) är Alibabas högsta rankning av öppna modeller på #3

235B-a22b-no-thinking är en rå modell utan instruktionsstämning (alltså "no thinking").

Den är bra på generering och rankas högt med samhället på grund av dess råa resonemangskraft.

Några andra toppöppna modeller med vår community från Alibaba inkluderar:

Varianterna 32B och 30B-a3b är mindre, snabbare alternativ med solid prestanda, även om de ligger efter toppmodellerna. Eftersom 32B är tätare bland de två, föredrar samhället dess noggrannhet framför 30B-a3b. 30B-a3b är en MoE-modell som gör den lite snabbare.

qwq-32b är speciellt utformad för att hantera komplexa resonemangsproblem och syftar till att matcha prestandan hos större modeller som DeepSeek R1, men når inte riktigt det märket när den utsätts för verkliga tester.

MiniMax M1 hamnar på listan med sin toppmodellrankning på #4

M1 utmärker sig också för sitt unika tillvägagångssätt med MoE-arkitektur i kombination med en form av uppmärksamhet som kallas "Lightning Attention", en linjäriserad mekanism som är specialbyggd för högeffektiv tokenbehandling.

Tillvägagångssättet fångade definitivt uppmärksamheten i vår community för att det är riktigt bra på dialog, resonemang och instruktionsföljande.

Google DeepMind landar på #5 med sin bästa öppna modell, Gemma 3 27b den

Gemma 3 är en öppen, multimodal språkmodell. Gemma 3 kan hantera både text- och bildinmatningar och utmärker sig i resonemang, uppgifter med långa sammanhang och tillämpningar av synspråk. Vår community älskar hur denna Gemma förbättrade minneseffektiviteten och ökade stödet för större sammanhang jämfört med de tidigare versionerna.

38,83K

Topp

Rankning

Favoriter