Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

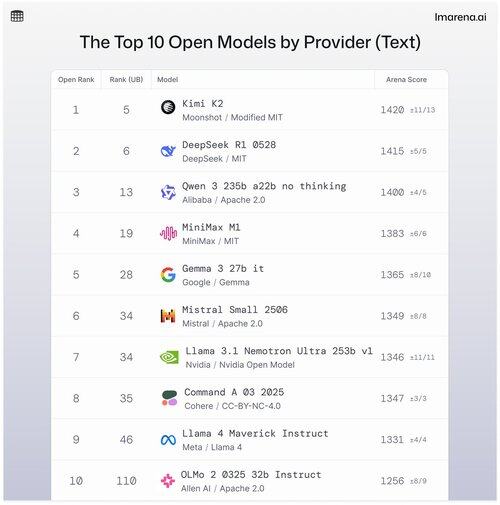

🧵Top 10 Modèles Ouverts par Fournisseur

Bien que les modèles propriétaires dominent souvent les classements, les modèles ouverts sont également en mode bataille et classés sur nos tableaux de classement publics.

Voici les 10 meilleurs modèles ouverts par fournisseur.

- #1 Kimi K2 (MIT Modifié) @Kimi_Moonshot

- #2 DeepSeek R1 0528 (MIT) @deepseek_ai

- #3 Qwen 235b a22b sans réflexion (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b it (Gemma) @googledeepmind

- #6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Llama 3.1 Nemotron Ultra 253b v1 (Modèle Ouvert Nvidia) @nvidia

- #8 Command A (Cohere) @cohere

- #9 Llama 4 Maverick Instruct (Llama 4) @aiatmeta

- #10 OLMo 2 32b Instruct (Apache 2.0) @allen_ai

Voir le fil pour en apprendre un peu plus sur les 5 premiers de cette liste 👇

Kimi K2 - #1 dans l'Arène Ouverte !

Si vous avez suivi les modèles open source, ce nouveau modèle de la société d'IA montante, Moonshot AI, fait sensation en tant que l'un des LLM open-source les plus impressionnants à ce jour. Notre communauté nous dit qu'elle aime aussi la façon dont Kimi K2 répond : Kimi est humoristique sans paraître trop robotique.

Kimi K2 est construit sur une architecture Mixture-of-Experts (MoE), avec un total de 1 trillion de paramètres, dont 32 milliards sont actifs lors de toute inférence donnée. Ce design aide le modèle à équilibrer efficacité et performance à la demande.

Le meilleur modèle open de DeepSeek, DeepSeek R1-0528, se classe au #2

R1-0528 est une version affinée et ajustée par instruction de R1, et le deuxième meilleur modèle de chat open selon la communauté. Fort dans les dialogues multi-tours et les tâches de raisonnement.

R1 (de base) est l'original, toujours solide mais maintenant légèrement en retard par rapport aux nouvelles variantes d'ajustement.

V3-0324 est un modèle MoE avec 236 milliards de paramètres au total, mais n'active que quelques experts par prompt. Cela le rend à la fois puissant et efficace. Il performe bien dans les tâches d'instruction, de raisonnement et multilingues, mais le format du prompt compte plus ici que pour R1-0528.

Qwen 235b a22b (sans réflexion) est le modèle ouvert numéro un d'Alibaba, classé au #3

235B-a22b-sans-réflexion est un modèle brut sans ajustement d'instructions (d'où "sans réflexion").

Il excelle dans la génération et est très apprécié par la communauté en raison de sa puissance de raisonnement brute.

D'autres modèles ouverts de premier plan de notre communauté d'Alibaba incluent :

Les variantes 32B et 30B-a3b sont des alternatives plus petites et plus rapides avec de bonnes performances, bien qu'elles soient derrière les modèles de premier plan. Avec 32B étant plus dense parmi les deux, la communauté préfère sa précision à celle de 30B-a3b. 30B-a3b est un modèle MoE, ce qui le rend un peu plus rapide.

qwq-32b est spécifiquement conçu pour résoudre des problèmes de raisonnement complexes et vise à égaler les performances de modèles plus grands comme DeepSeek R1, mais n'atteint pas tout à fait cet objectif lors des tests en conditions réelles.

MiniMax M1 figure sur la liste avec son modèle phare classé au #4.

M1 se distingue également par son approche unique avec une architecture MoE combinée à une forme d'attention appelée "Lightning Attention", un mécanisme linéarisé conçu spécifiquement pour un traitement des tokens à haute efficacité.

Cette approche a définitivement attiré l'attention de notre communauté pour sa capacité à exceller dans le dialogue, le raisonnement et le suivi des instructions.

Google DeepMind se classe au #5 avec leur meilleur modèle ouvert, Gemma 3 27b.

Gemma 3 est un modèle de langage multimodal à poids ouverts. Gemma 3 peut traiter à la fois des entrées textuelles et des images, excelling dans le raisonnement, les tâches à long contexte et les applications vision-langage. Notre communauté adore comment ce Gemma a amélioré l'efficacité de la mémoire et a augmenté le support pour un contexte plus large par rapport aux versions précédentes.

36,4K

Meilleurs

Classement

Favoris