Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

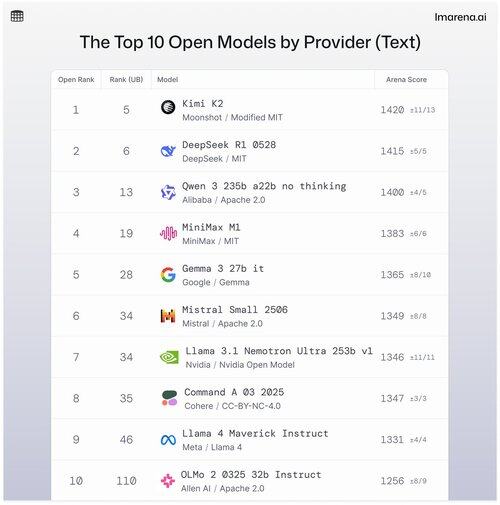

🧵Top 10 Offene Modelle nach Anbieter

Obwohl proprietäre Modelle oft an der Spitze stehen, treten auch offene Modelle im Wettkampf gegeneinander an und werden auf unseren öffentlichen Ranglisten bewertet.

Hier sind die Top 10, wenn man die besten offenen Modelle nach Anbieter anordnet.

- #1 Kimi K2 (Modifiziertes MIT) @Kimi_Moonshot

- #2 DeepSeek R1 0528 (MIT) @deepseek_ai

- #3 Qwen 235b a22b kein Denken (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b it (Gemma) @googledeepmind

- #6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Llama 3.1 Nemotron Ultra 253b v1 (Nvidia Offenes Modell) @nvidia

- #8 Command A (Cohere) @cohere

- #9 Llama 4 Maverick Instruct (Llama 4) @aiatmeta

- #10 OLMo 2 32b Instruct (Apache 2.0) @allen_ai

Siehe Thread, um ein wenig mehr über die Top 5 in dieser Liste zu erfahren 👇

Kimi K2 - #1 in der Open Arena!

Wenn Sie die Entwicklungen im Bereich der Open-Source-Modelle verfolgt haben, sorgt dieses neue Modell des aufstrebenden KI-Unternehmens Moonshot AI für Aufsehen und gilt als eines der beeindruckendsten Open-Source-LLMs bis heute. Unsere Community sagt uns, dass sie auch die Art und Weise, wie Kimi K2 antwortet, liebt: Kimi ist humorvoll, ohne zu robotisch zu klingen.

Kimi K2 basiert auf einer Mixture-of-Experts (MoE)-Architektur mit insgesamt 1 Billion Parametern, von denen 32 Milliarden während einer gegebenen Inferenz aktiv sind. Dieses Design hilft dem Modell, Effizienz und bedarfsgerechte Leistung auszubalancieren.

Das beste offene Modell von DeepSeek, DeepSeek R1-0528, belegt Platz #2

R1-0528 ist eine verfeinerte, anweisungsoptimierte Version von R1 und das zweitbeste offene Chat-Modell laut der Community. Stark in mehrteiligen Dialogen und bei Denkaufgaben.

R1 (Basisversion) ist das Original, immer noch solide, aber jetzt etwas hinter neueren Tuning-Varianten zurück.

V3-0324 ist ein MoE-Modell mit insgesamt 236B Parametern, aktiviert jedoch nur wenige Experten pro Eingabeaufforderung. Das macht es sowohl leistungsstark als auch effizient. Es schneidet gut bei Anweisungen, Denkaufgaben und mehrsprachigen Aufgaben ab, aber das Format der Eingabeaufforderung ist hier wichtiger als bei R1-0528.

Qwen 235b a22b (kein Denken) ist Alibabas bestes offenes Modell, das auf Platz #3 rangiert.

235B-a22b-kein-Denken ist ein rohes Modell ohne Anweisungstuning (daher "kein Denken").

Es ist großartig in der Generierung und hat aufgrund seiner rohen Denkfähigkeit einen hohen Rang in der Community.

Einige andere Top-Modelle von Alibaba in unserer Community sind:

Die Varianten 32B und 30B-a3b sind kleinere, schnellere Alternativen mit solider Leistung, obwohl sie hinter den Spitzenmodellen zurückbleiben. Mit 32B, das dichter ist, bevorzugt die Community seine Genauigkeit gegenüber 30B-a3b. 30B-a3b ist ein MoE-Modell, was es etwas schneller macht.

qwq-32b ist speziell dafür konzipiert, komplexe Denkprobleme zu lösen und zielt darauf ab, die Leistung größerer Modelle wie DeepSeek R1 zu erreichen, erreicht jedoch nicht ganz dieses Ziel, wenn es in realen Tests eingesetzt wird.

MiniMax M1 steht auf der Liste mit ihrem Top-Modell, das auf Platz 4 rangiert.

M1 hebt sich auch durch seinen einzigartigen Ansatz mit MoE-Architektur hervor, kombiniert mit einer Form der Aufmerksamkeit, die "Lightning Attention" genannt wird, einem linearisierten Mechanismus, der speziell für die hoch effiziente Token-Verarbeitung entwickelt wurde.

Der Ansatz hat definitiv die Aufmerksamkeit unserer Community auf sich gezogen, da er wirklich gut im Dialog, im Denken und im Befolgen von Anweisungen ist.

Google DeepMind landet auf Platz #5 mit ihrem besten offenen Modell, Gemma 3 27b.

Gemma 3 ist ein offenes, multimodales Sprachmodell. Gemma 3 kann sowohl Text- als auch Bild-Eingaben verarbeiten und glänzt in der Argumentation, bei Aufgaben mit langem Kontext und in vision-sprachlichen Anwendungen. Unsere Community liebt, wie dieses Gemma die Speichereffizienz verbessert und die Unterstützung für größere Kontexte im Vergleich zu den vorherigen Versionen erhöht hat.

36,41K

Top

Ranking

Favoriten