Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

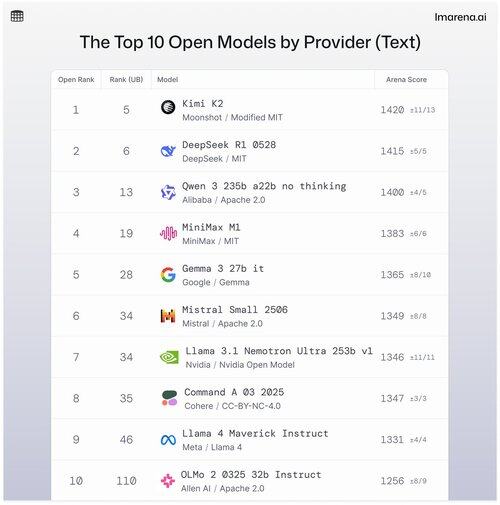

🧵Los 10 Mejores Modelos Abiertos por Proveedor

Aunque los modelos propietarios a menudo encabezan las listas, los modelos abiertos también se enfrentan en modo de batalla y se clasifican en nuestras tablas de clasificación públicas.

Aquí están los 10 mejores cuando se agrupan por el mejor modelo abierto por proveedor.

- #1 Kimi K2 (MIT Modificado) @Kimi_Moonshot

- #2 DeepSeek R1 0528 (MIT) @deepseek_ai

- #3 Qwen 235b a22b sin pensar (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b it (Gemma) @googledeepmind

- #6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Llama 3.1 Nemotron Ultra 253b v1 (Modelo Abierto de Nvidia) @nvidia

- #8 Command A (Cohere) @cohere

- #9 Llama 4 Maverick Instruct (Llama 4) @aiatmeta

- #10 OLMo 2 32b Instruct (Apache 2.0) @allen_ai

Consulta el hilo para aprender un poco más sobre los 5 mejores de esta lista 👇

¡Kimi K2 - #1 en la Arena Abierta!

Si has estado prestando atención a los modelos de código abierto, este nuevo modelo de la creciente empresa de IA, Moonshot AI, está causando sensación como uno de los LLMs de código abierto más impresionantes hasta la fecha. Nuestra comunidad nos dice que también les encanta la forma en que Kimi K2 responde: Kimi es humorístico sin sonar demasiado robótico.

Kimi K2 está construido sobre una arquitectura de Mezcla de Expertos (MoE), con un total de 1 billón de parámetros, de los cuales 32 mil millones están activos durante cualquier inferencia dada. Este diseño ayuda al modelo a equilibrar la eficiencia y el rendimiento bajo demanda.

El mejor modelo abierto de DeepSeek, DeepSeek R1-0528, ocupa el puesto #2

R1-0528 es una versión refinada ajustada por instrucciones de R1, y el segundo mejor modelo de chat abierto según la comunidad. Fuerte en diálogos de múltiples turnos y tareas de razonamiento.

R1 (base) es el original, sigue siendo sólido pero ahora está ligeramente detrás de las variantes de ajuste más nuevas.

V3-0324 es un modelo MoE con 236B de parámetros totales, pero activa solo unos pocos expertos por solicitud. Esto lo hace tanto potente como eficiente. Funciona bien en tareas de instrucciones, razonamiento y multilingües, pero el formato de la solicitud importa más aquí que con R1-0528.

Qwen 235b a22b (sin pensar) es el modelo abierto principal de Alibaba, clasificado en el #3.

235B-a22b-sin-pensar es un modelo en bruto sin ajuste de instrucciones (de ahí "sin pensar").

Es excelente en generación y tiene una alta clasificación en la comunidad debido a su poder de razonamiento en bruto.

Algunos otros modelos abiertos destacados de nuestra comunidad de Alibaba incluyen:

Las variantes 32B y 30B-a3b son alternativas más pequeñas y rápidas con un rendimiento sólido, aunque están por detrás de los modelos de primera categoría. Con 32B siendo más denso entre los dos, la comunidad prefiere su precisión sobre 30B-a3b. 30B-a3b es un modelo MoE, lo que lo hace un poco más rápido.

qwq-32b está diseñado específicamente para abordar problemas de razonamiento complejos y tiene como objetivo igualar el rendimiento de modelos más grandes como DeepSeek R1, pero no alcanza esa marca cuando se pone a prueba en el mundo real.

MiniMax M1 se incluye en la lista con su modelo principal clasificado en el #4.

M1 también se destaca por su enfoque único con la arquitectura MoE combinada con una forma de atención llamada "Lightning Attention", un mecanismo linealizado diseñado específicamente para el procesamiento eficiente de tokens.

El enfoque definitivamente llamó la atención de nuestra comunidad por ser realmente bueno en diálogo, razonamiento y seguimiento de instrucciones.

Google DeepMind se sitúa en el #5 con su mejor modelo abierto, Gemma 3 27b.

Gemma 3 es un modelo de lenguaje multimodal de peso abierto. Gemma 3 puede manejar tanto entradas de texto como de imagen, destacándose en razonamiento, tareas de largo contexto y aplicaciones de visión-lenguaje. A nuestra comunidad le encanta cómo este Gemma mejoró la eficiencia de la memoria y aumentó el soporte para un contexto más amplio en comparación con las versiones anteriores.

36,39K

Parte superior

Clasificación

Favoritos