Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

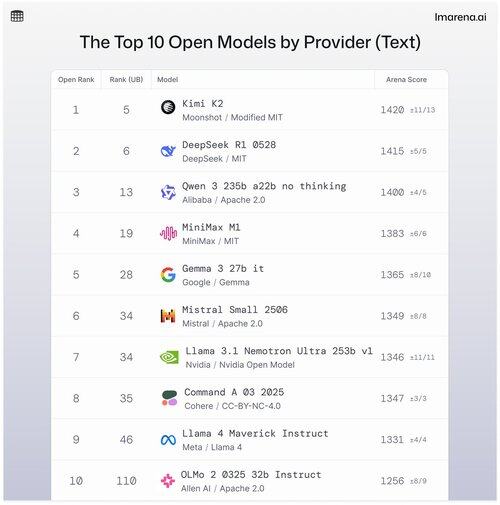

🧵Top 10 modeli otwartych według dostawcy

Chociaż modele własnościowe często zajmują czołowe miejsca, modele otwarte również są zestawiane w trybie rywalizacji i klasyfikowane na naszych publicznych tablicach wyników.

Oto 10 najlepszych modeli otwartych według dostawcy.

- #1 Kimi K2 (Zmodyfikowana MIT) @Kimi_Moonshot

- #2 DeepSeek R1 0528 (MIT) @deepseek_ai

- #3 Qwen 235b a22b bez myślenia (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b it (Gemma) @googledeepmind

- #6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Llama 3.1 Nemotron Ultra 253b v1 (Nvidia Open Model) @nvidia

- #8 Command A (Cohere) @cohere

- #9 Llama 4 Maverick Instruct (Llama 4) @aiatmeta

- #10 OLMo 2 32b Instruct (Apache 2.0) @allen_ai

Zobacz wątek, aby dowiedzieć się nieco więcej o 5 najlepszych modelach z tej listy 👇

Kimi K2 - #1 w Open Arena!

Jeśli śledzisz modele open source, ten nowy model od rosnącej firmy AI, Moonshot AI, robi furorę jako jeden z najbardziej imponujących open-source LLM-ów do tej pory. Nasza społeczność mówi, że również uwielbia sposób, w jaki Kimi K2 odpowiada: Kimi jest dowcipny, nie brzmiąc zbyt robotycznie.

Kimi K2 jest zbudowany na architekturze Mixture-of-Experts (MoE), z łączną liczbą 1 biliona parametrów, z czego 32 miliardy są aktywne podczas dowolnego wnioskowania. Ten projekt pomaga modelowi zrównoważyć wydajność i wydajność na żądanie.

Najlepszy otwarty model DeepSeek, DeepSeek R1-0528, zajmuje 2. miejsce

R1-0528 to udoskonalona wersja R1 dostosowana do instrukcji i według społeczności jest to drugi najlepszy otwarty model czatu. Silny w dialogach wieloetapowych i zadaniach rozumowania.

R1 (wersja bazowa) to oryginał, nadal solidny, ale teraz nieco w tyle za nowszymi wariantami dostrojenia.

V3-0324 to model MoE z 236 miliardami parametrów, ale aktywuje tylko kilku ekspertów na każde zapytanie. Dzięki temu jest zarówno potężny, jak i wydajny. Dobrze radzi sobie w zadaniach związanych z instrukcjami, rozumowaniem i wielojęzycznością, ale format zapytania ma tutaj większe znaczenie niż w przypadku R1-0528.

Qwen 235b a22b (bez myślenia) to najlepszy otwarty model Alibaba, zajmujący 3. miejsce.

235B-a22b-bez-myślenia to surowy model bez dostosowywania instrukcji (stąd "bez myślenia").

Jest świetny w generowaniu i cieszy się dużym uznaniem w społeczności dzięki swojej surowej mocy rozumowania.

Inne czołowe otwarte modele z naszej społeczności od Alibaba to:

Warianty 32B i 30B-a3b to mniejsze, szybsze alternatywy o solidnej wydajności, chociaż ustępują najlepszym modelom. Społeczność preferuje 32B ze względu na jego dokładność w porównaniu do 30B-a3b, który jest modelem MoE, co czyni go nieco szybszym.

qwq-32b jest specjalnie zaprojektowany do rozwiązywania złożonych problemów rozumowania i ma na celu dorównanie wydajności większych modeli, takich jak DeepSeek R1, ale nie osiąga tego celu w testach w rzeczywistych warunkach.

MiniMax M1 znajduje się na liście z ich najlepszym modelem zajmującym 4. miejsce.

M1 wyróżnia się również unikalnym podejściem z architekturą MoE połączoną z formą uwagi nazwaną "Lightning Attention", liniowym mechanizmem stworzonym specjalnie do przetwarzania tokenów o wysokiej wydajności.

To podejście z pewnością przyciągnęło uwagę naszej społeczności, ponieważ jest naprawdę dobre w prowadzeniu dialogu, rozumowaniu i przestrzeganiu instrukcji.

Google DeepMind zajmuje 5. miejsce z ich najlepszym otwartym modelem, Gemma 3 27b.

Gemma 3 to model językowy o otwartych wagach i multimodalny. Gemma 3 potrafi obsługiwać zarówno tekst, jak i obrazy, doskonale radząc sobie z rozumowaniem, zadaniami o długim kontekście oraz aplikacjami związanymi z językiem i obrazem. Nasza społeczność uwielbia, jak ten Gemma poprawił efektywność pamięci i zwiększył wsparcie dla większego kontekstu w porównaniu do poprzednich wersji.

36,4K

Najlepsze

Ranking

Ulubione