Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

RT pentru a-l ajuta pe Simon să crească gradul de conștientizare a atacurilor de injecție promptă în LLM-uri.

Se simte un pic ca în vestul sălbatic al calculatoarelor timpurii, cu viruși de computer (acum = prompturi rău intenționate ascunse în date/instrumente web) și apărare nu bine dezvoltată (antivirus sau o paradigmă de securitate mult mai dezvoltată a nucleului/spațiului utilizatorului în care, de exemplu, unui agent i se dau tipuri de acțiuni foarte specifice în loc de capacitatea de a rula scripturi bash arbitrare).

Conflictual pentru că vreau să fiu unul dintre primii care adoptă agenții LLM în calculatoarele mele personale, dar vestul sălbatic al posibilităților mă reține.

16 iun. 2025

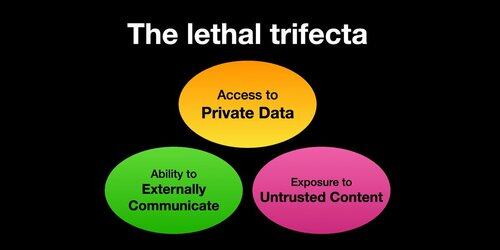

Dacă utilizați "agenți AI" (LLM-uri care apelează instrumente), trebuie să fiți conștienți de Trifecta letală

De fiecare dată când combinați accesul la date private cu expunerea la conținut nesigur și capacitatea de a comunica extern, un atacator poate păcăli sistemul să vă fure datele!

Ar trebui să clarific că riscul este cel mai mare dacă rulați agenți LLM locali (de exemplu, Cursor, Claude Code etc.).

Dacă vorbiți doar cu un LLM pe un site web (de exemplu, ChatGPT), riscul este mult mai mic *cu excepția cazului în care* începeți să activați conectorii. De exemplu, tocmai am văzut că ChatGPT adaugă suport MCP. Acest lucru se va combina deosebit de prost cu toate funcțiile de memorie adăugate recent - de exemplu, imaginați-vă că ChatGPT spune tot ce știe despre tine unui atacator de pe internet doar pentru că ați bifat caseta greșită în setările Conectorilor.

386K

Limită superioară

Clasament

Favorite