Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

RT để giúp Simon nâng cao nhận thức về các cuộc tấn công tiêm lệnh trong LLMs.

Cảm giác như miền Tây hoang dã của những ngày đầu máy tính, với virus máy tính (bây giờ = các lệnh độc hại ẩn trong dữ liệu/công cụ web), và các biện pháp phòng thủ chưa phát triển tốt (phần mềm diệt virus, hoặc một mô hình bảo mật không gian nhân/kernel phát triển hơn nhiều, nơi ví dụ một tác nhân được giao các loại hành động rất cụ thể thay vì khả năng chạy các tập lệnh bash tùy ý).

Mâu thuẫn vì tôi muốn trở thành người tiên phong trong việc sử dụng các tác nhân LLM trong máy tính cá nhân của mình nhưng miền Tây hoang dã của khả năng đang kìm hãm tôi.

16 thg 6, 2025

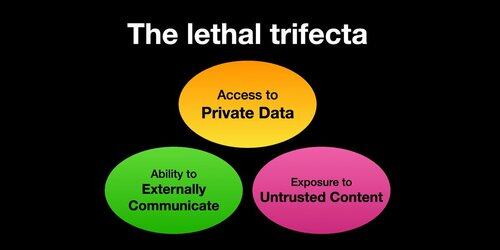

If you use "AI agents" (LLMs that call tools) you need to be aware of the Lethal Trifecta

Any time you combine access to private data with exposure to untrusted content and the ability to externally communicate an attacker can trick the system into stealing your data!

Tôi nên làm rõ rằng rủi ro cao nhất nếu bạn đang chạy các tác nhân LLM cục bộ (ví dụ: Cursor, Claude Code, v.v.).

Nếu bạn chỉ đang trò chuyện với một LLM trên một trang web (ví dụ: ChatGPT), rủi ro sẽ thấp hơn nhiều *trừ khi* bạn bắt đầu bật Connectors. Ví dụ, tôi vừa thấy ChatGPT đang thêm hỗ trợ MCP. Điều này sẽ kết hợp đặc biệt kém với tất cả các tính năng bộ nhớ mới được thêm vào gần đây - ví dụ, hãy tưởng tượng ChatGPT nói tất cả những gì nó biết về bạn cho một kẻ tấn công nào đó trên internet chỉ vì bạn đã đánh dấu sai trong cài đặt Connectors.

385,96K

Hàng đầu

Thứ hạng

Yêu thích