Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

RT, щоб допомогти Simon підвищити обізнаність про атаки швидкого впорскування в LLM.

Це трохи схоже на Дикий Захід ранніх комп'ютерів, з комп'ютерними вірусами (зараз = шкідливі підказки, що ховаються у веб-даних/інструментах) і не дуже розвиненим захистом (антивірус, або набагато більш розвинена парадигма безпеки ядра/простору користувача, де, наприклад, агенту надаються дуже специфічні типи дій замість можливості запускати довільні сценарії bash).

Конфліктний, тому що я хочу бути першим, хто впровадив агенти LLM у свої особисті комп'ютери, але дикий захід можливостей стримує мене.

16 черв. 2025 р.

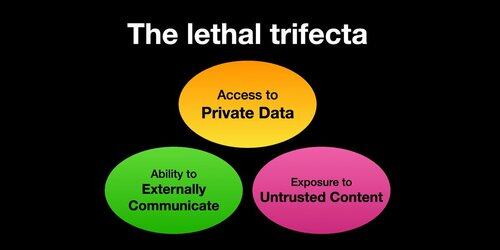

If you use "AI agents" (LLMs that call tools) you need to be aware of the Lethal Trifecta

Any time you combine access to private data with exposure to untrusted content and the ability to externally communicate an attacker can trick the system into stealing your data!

Я повинен уточнити, що ризик найвищий, якщо ви використовуєте місцевих агентів LLM (наприклад, Cursor, Claude Code тощо).

Якщо ви просто спілкуєтеся з LLM на веб-сайті (наприклад, ChatGPT), ризик набагато нижчий *якщо* ви не почнете включати конектори. Наприклад, я щойно побачив, що ChatGPT додає підтримку MCP. Особливо погано це буде поєднуватися з усіма нещодавно доданими функціями пам'яті - наприклад, уявіть, що ChatGPT розповідає все, що знає про вас, якомусь зловмиснику в інтернеті тільки тому, що ви поставили неправильну галочку в налаштуваннях Connectors.

385,97K

Найкращі

Рейтинг

Вибране