Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

RT para ajudar Simon a aumentar a conscientização sobre ataques de injeção imediata em LLMs.

Parece um pouco com o oeste selvagem da computação inicial, com vírus de computador (agora = prompts maliciosos escondidos em dados / ferramentas da web) e defesas não bem desenvolvidas (antivírus ou um paradigma de segurança de kernel / espaço do usuário muito mais desenvolvido, onde, por exemplo, um agente recebe tipos de ação muito específicos em vez da capacidade de executar scripts bash arbitrários).

Em conflito porque quero ser um dos primeiros a adotar agentes LLM em minha computação pessoal, mas o oeste selvagem da possibilidade está me impedindo.

16 de jun. de 2025

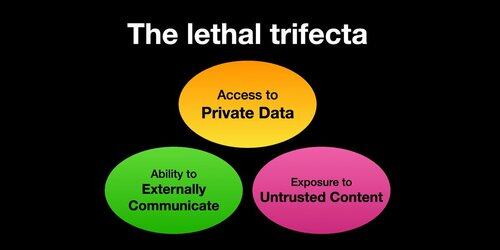

Se você usa "agentes de IA" (LLMs que chamam ferramentas), precisa estar ciente da Tríade Letal

Sempre que você combina o acesso a dados privados com a exposição a conteúdo não confiável e a capacidade de se comunicar externamente, um invasor pode enganar o sistema para roubar seus dados!

Devo esclarecer que o risco é maior se você estiver executando agentes LLM locais (por exemplo, Cursor, Claude Code, etc.).

Se você está apenas conversando com um LLM em um site (por exemplo, ChatGPT), o risco é muito menor *a menos* que você comece a ativar os conectores. Por exemplo, acabei de ver que o ChatGPT está adicionando suporte ao MCP. Isso combinará especialmente mal com todos os recursos de memória adicionados recentemente - por exemplo, imagine o ChatGPT contando tudo o que sabe sobre você para algum invasor na Internet só porque você marcou a caixa errada nas configurações de Conectores.

385,97K

Melhores

Classificação

Favoritos