Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

RT om Simon te helpen bewustzijn te creëren over promptinjectie-aanvallen in LLM's.

Het voelt een beetje als het wilde westen van de vroege computertechnologie, met computervirussen (nu = kwaadaardige prompts die zich verbergen in webdata/tools), en niet goed ontwikkelde verdedigingen (antivirus, of een veel meer ontwikkelde kernel/user space beveiligingsparadigma waar bijvoorbeeld een agent zeer specifieke actietypes krijgt in plaats van de mogelijkheid om willekeurige bash-scripts uit te voeren).

In conflict omdat ik een vroege adopter van LLM-agenten in mijn persoonlijke computergebruik wil zijn, maar het wilde westen van mogelijkheden houdt me tegen.

16 jun 2025

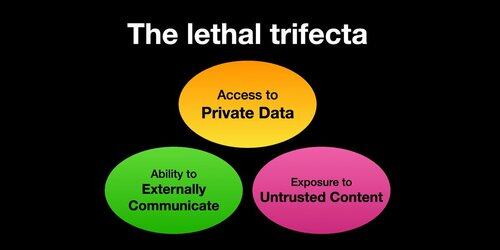

If you use "AI agents" (LLMs that call tools) you need to be aware of the Lethal Trifecta

Any time you combine access to private data with exposure to untrusted content and the ability to externally communicate an attacker can trick the system into stealing your data!

Ik moet verduidelijken dat het risico het hoogst is als je lokale LLM-agenten draait (bijv. Cursor, Claude Code, enz.).

Als je gewoon met een LLM op een website praat (bijv. ChatGPT), is het risico veel lager *tenzij* je begint Connectors in te schakelen. Bijvoorbeeld, ik zag net dat ChatGPT MCP-ondersteuning toevoegt. Dit zal vooral slecht combineren met alle recent toegevoegde geheugenfuncties - stel je voor dat ChatGPT alles wat het over jou weet aan een aanvaller op internet vertelt, gewoon omdat je het verkeerde vakje in de Connectors-instellingen hebt aangevinkt.

385,96K

Boven

Positie

Favorieten