Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

RT, um Simon zu helfen, das Bewusstsein für Prompt-Injection-Angriffe in LLMs zu schärfen.

Es fühlt sich ein bisschen an wie der Wilde Westen der frühen Computertechnik, mit Computerviren (jetzt = bösartige Prompts, die in Webdaten/Tools versteckt sind) und nicht gut entwickelten Abwehrmechanismen (Antivirus oder ein viel weiter entwickeltes Sicherheitsparadigma für Kernel/Nutzerraum, bei dem z.B. einem Agenten sehr spezifische Aktionstypen zugewiesen werden, anstatt die Fähigkeit zu haben, beliebige Bash-Skripte auszuführen).

Ich bin hin- und hergerissen, weil ich ein früher Anwender von LLM-Agenten in meinem persönlichen Computing sein möchte, aber der Wilde Westen der Möglichkeiten hält mich zurück.

16. Juni 2025

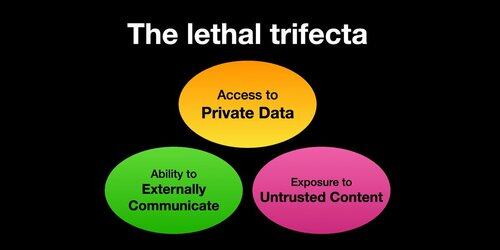

If you use "AI agents" (LLMs that call tools) you need to be aware of the Lethal Trifecta

Any time you combine access to private data with exposure to untrusted content and the ability to externally communicate an attacker can trick the system into stealing your data!

Ich sollte klarstellen, dass das Risiko am höchsten ist, wenn Sie lokale LLM-Agenten (z. B. Cursor, Claude Code usw.) verwenden.

Wenn Sie nur mit einem LLM auf einer Website (z. B. ChatGPT) sprechen, ist das Risiko viel geringer, *es sei denn*, Sie aktivieren die Connectoren. Zum Beispiel habe ich gerade gesehen, dass ChatGPT die MCP-Unterstützung hinzufügt. Dies wird besonders schlecht mit all den kürzlich hinzugefügten Speicherfunktionen kombiniert - z. B. stellen Sie sich vor, ChatGPT erzählt alles, was es über Sie weiß, einem Angreifer im Internet, nur weil Sie das falsche Kästchen in den Connector-Einstellungen angekreuzt haben.

385,97K

Top

Ranking

Favoriten