Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

RT per aiutare Simon a sensibilizzare riguardo agli attacchi di prompt injection nei LLM.

Sembra un po' come il selvaggio west dei primi computer, con virus informatici (ora = prompt malevoli nascosti nei dati/strumenti web) e difese non ben sviluppate (antivirus, o un paradigma di sicurezza kernel/user space molto più sviluppato dove, ad esempio, a un agente vengono dati tipi di azione molto specifici invece della possibilità di eseguire script bash arbitrari).

In conflitto perché voglio essere un early adopter degli agenti LLM nel mio computing personale, ma il selvaggio west delle possibilità mi frena.

16 giu 2025

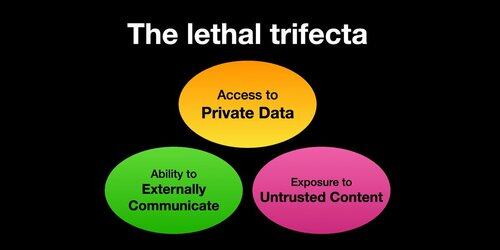

If you use "AI agents" (LLMs that call tools) you need to be aware of the Lethal Trifecta

Any time you combine access to private data with exposure to untrusted content and the ability to externally communicate an attacker can trick the system into stealing your data!

Dovrei chiarire che il rischio è più alto se stai eseguendo agenti LLM locali (ad es. Cursor, Claude Code, ecc.).

Se stai semplicemente parlando con un LLM su un sito web (ad es. ChatGPT), il rischio è molto più basso *a meno che* non inizi ad attivare i Connettori. Ad esempio, ho appena visto che ChatGPT sta aggiungendo il supporto MCP. Questo si combinerà particolarmente male con tutte le recenti funzionalità di memoria aggiunte - ad es. immagina ChatGPT che racconta tutto ciò che sa su di te a qualche attaccante su internet solo perché hai selezionato la casella sbagliata nelle impostazioni dei Connettori.

385,96K

Principali

Ranking

Preferiti