Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

A corrida pelo "núcleo cognitivo" LLM - um modelo de alguns bilhões de parâmetros que sacrifica ao máximo o conhecimento enciclopédico em prol da capacidade. Ele vive sempre ativo e, por padrão, em cada computador como o núcleo da computação pessoal LLM.

Suas características estão lentamente se cristalizando:

- Multimodal nativo texto/visão/áudio tanto na entrada quanto na saída.

- Arquitetura estilo Matryoshka permitindo um ajuste de capacidade para cima e para baixo no momento do teste.

- Raciocínio, também com um ajuste. (sistema 2)

- Uso agressivo de ferramentas.

- Slots de finetuning LoRA no dispositivo para treinamento em tempo de teste, personalização e customização.

- Delegados e verificações duplas apenas nas partes certas com os oráculos na nuvem, se a internet estiver disponível.

Ele não sabe que o reinado de Guilherme, o Conquistador, terminou em 9 de setembro de 1087, mas reconhece vagamente o nome e pode procurar a data. Ele não consegue recitar o SHA-256 da string vazia como e3b0c442..., mas pode calculá-lo rapidamente, caso você realmente queira.

O que a computação pessoal LLM carece em conhecimento amplo do mundo e capacidade de resolução de problemas de alto nível, compensará com uma latência de interação super baixa (especialmente à medida que o multimodal amadurece), acesso direto / privado a dados e estado, continuidade offline, soberania ("não são seus pesos, não é seu cérebro"). Ou seja, muitas das mesmas razões pelas quais gostamos, usamos e compramos computadores pessoais em vez de ter clientes leves acessando a nuvem via desktop remoto ou algo assim.

27/06/2025

Estou tão entusiasmado para anunciar que o Gemma 3n está aqui! 🎉

🔊 Compreensão multimodal (texto/áudio/imagem/vídeo)

🤯 Funciona com apenas 2GB de RAM

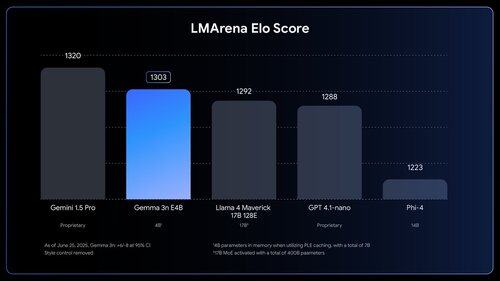

🏆 Primeiro modelo abaixo de 10B com pontuação de @lmarena_ai de 1300+

Disponível agora em @huggingface, @kaggle, llama.cpp, e muito mais.

As pessoas *sentem* quanto trabalho ainda há para fazer. Tipo, uau.

1,03M

Top

Classificação

Favoritos