Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Andrej Karpathy

Construção @EurekaLabsAI. Anteriormente Diretor de IA @ Tesla, equipe fundadora @ OpenAI, CS231n/PhD @ Stanford. Eu gosto de treinar grandes redes 🧠🤖💥 neurais profundas

Modelos de vídeo de difusão, mas agora - **em tempo real**!

Filtros de vídeo simples são em tempo real, mas só conseguem fazer re-coloração e estilos básicos. Modelos de difusão de vídeo (Veo e amigos) são mágicos, mas levam muitos segundos/minutos para gerar. O MirageLSD é magia em tempo real. Ao contrário dos filtros de vídeo simples, os modelos de difusão realmente *entendem* o que estão a ver, podendo estilizar todas as partes do feed de forma inteligente (por exemplo, colocando chapéus nas cabeças ou sabres de luz nas mãos, etc.). E são arbitrariamente direcionáveis, por exemplo, através de prompts de texto.

Filtros de vídeo personalizáveis e inteligentes desbloqueiam muitas ideias legais ao longo do tempo:

- transformar feeds de câmera em realidades alternativas

- dirigir e filmar os seus próprios filmes, encenando cenas com adereços. Tempo real => feedback/revisão instantânea.

- criar jogos de vibe em torno de esferas/blocos simples, e depois usar um modelo de difusão em tempo real para texturizar o seu jogo e torná-lo bonito.

- estilizar e personalizar qualquer feed de vídeo: jogos, vídeos, ... por exemplo, Skyrim mas "MAIS ÉPICO"? DOOM II mas com qualidade moderna de Unreal Engine com apenas um prompt? Filme de terror mas "fofo, rosa e só coelhinhos"? Não sei!

- fundos para chamadas de zoom+++

- experimentar roupas virtualmente em tempo real

- óculos: por exemplo, transformar a sua visão em cartoon em tempo real?

- agora podemos construir o Espelho de Erised de Harry Potter, mostrando o "feed bruto" de você no espelho, mas aumentado com os seus desejos mais profundos (conforme inferido pela IA).

- Não sei, provavelmente estou a perder o maior, tantas coisas!

Decart18/07, 04:44

Apresentando o MirageLSD: O Primeiro Modelo de Difusão em Tempo Real (LSD) de IA

Insira qualquer fluxo de vídeo, desde uma câmara ou chat de vídeo até uma tela de computador ou jogo, e transforme-o no mundo que desejar, em tempo real (<40ms de latência).

Aqui está como funciona (com uma demonstração que você pode usar!) :

347,62K

Costumo desabafar sobre como 99% da atenção vai ser atenção de LLM em vez de atenção humana. Como é que um artigo de pesquisa se parece para um LLM em vez de um humano? Definitivamente não é um pdf. Há um enorme espaço para um "aplicativo de pesquisa" extremamente valioso que descubra isso.

Michael Levin10/07, 22:47

Estou constantemente irritado por não ter tempo para ler a torrente de artigos interessantes que chegam cada vez mais rápido de pessoas incríveis em áreas relevantes. Outros cientistas têm o mesmo problema e também não têm tempo para ler a maioria dos meus longos artigos conceituais. Então, para quem estamos a escrever esses artigos?

Acho que, pelo menos até que eles enfrentem o mesmo problema devido ao seu próprio trabalho, as IAs serão as únicas que realmente terão a capacidade de ler tudo isso. Não estou a falar especificamente dos modelos de linguagem de hoje - vamos assumir que nos referimos a qualquer IA inevitável que apareça, capaz de ler a literatura e ter impacto na pesquisa (seja conversando com humanos ou executando plataformas de automação de laboratório/cientistas robôs).

Então, como devemos escrever, sabendo que uma grande parte do nosso público será IA (mais ciborgues, híbridos, humanos aumentados, etc.)? Talvez seja cedo demais para saber o que fazer, mas é melhor começarmos a pensar nisso, porque assumir que nosso público sempre será os humanos de hoje parece insustentável. Levando a sério a ideia de que um dia o público impactante será muito diferente, e que as coisas que escrevemos agora são, de certa forma, um conjunto de treinamento para seres futuros verdadeiramente diversos, como a nossa escrita muda? Ou muda?

498,06K

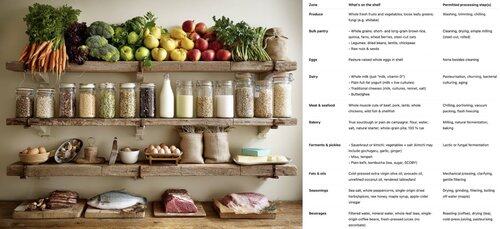

Como construir uma comunidade de código aberto próspera escrevendo código como as bactérias fazem 🦠. O código bacteriano (genomas) é:

- pequeno (cada linha de código consome energia)

- modular (organizado em grupos de operões intercambiáveis)

- autossuficiente (facilmente "copiável e colável" via transferência horizontal de genes)

Se os pedaços de código forem pequenos, modulares, autossuficientes e triviais de copiar e colar, a comunidade pode prosperar através da transferência horizontal de genes. Para qualquer função (gene) ou classe (operão) que você escrever: consegue imaginar alguém dizendo "yoink" sem conhecer o resto do seu código ou ter que importar algo novo, para obter um benefício? Seu código poderia ser um gist em alta no GitHub?

Este guia de estilo de codificação permitiu que as bactérias colonizassem cada canto ecológico, desde o frio até o quente, ácido ou alcalino, nas profundezas da Terra e no vácuo do espaço, juntamente com uma diversidade insana de anabolismo de carbono, metabolismo energético, etc. Ele se destaca na prototipagem rápida, mas... não consegue construir vida complexa. Em comparação, o genoma eucariótico é um monorepo significativamente maior, mais complexo, organizado e acoplado. Significativamente menos inventivo, mas necessário para a vida complexa - para construir órgãos inteiros e coordenar sua atividade. Com nossa vantagem de design inteligente, deve ser possível tirar proveito de ambos. Construa uma espinha dorsal de monorepo eucariótico se necessário, mas maximize o DNA bacteriano.

538,71K

A corrida pelo "núcleo cognitivo" LLM - um modelo de alguns bilhões de parâmetros que sacrifica ao máximo o conhecimento enciclopédico em prol da capacidade. Ele vive sempre ativo e, por padrão, em cada computador como o núcleo da computação pessoal LLM.

Suas características estão lentamente se cristalizando:

- Multimodal nativo texto/visão/áudio tanto na entrada quanto na saída.

- Arquitetura estilo Matryoshka permitindo um ajuste de capacidade para cima e para baixo no momento do teste.

- Raciocínio, também com um ajuste. (sistema 2)

- Uso agressivo de ferramentas.

- Slots de finetuning LoRA no dispositivo para treinamento em tempo de teste, personalização e customização.

- Delegados e verificações duplas apenas nas partes certas com os oráculos na nuvem, se a internet estiver disponível.

Ele não sabe que o reinado de Guilherme, o Conquistador, terminou em 9 de setembro de 1087, mas reconhece vagamente o nome e pode procurar a data. Ele não consegue recitar o SHA-256 da string vazia como e3b0c442..., mas pode calculá-lo rapidamente, caso você realmente queira.

O que a computação pessoal LLM carece em conhecimento amplo do mundo e capacidade de resolução de problemas de alto nível, compensará com uma latência de interação super baixa (especialmente à medida que o multimodal amadurece), acesso direto / privado a dados e estado, continuidade offline, soberania ("não são seus pesos, não é seu cérebro"). Ou seja, muitas das mesmas razões pelas quais gostamos, usamos e compramos computadores pessoais em vez de ter clientes leves acessando a nuvem via desktop remoto ou algo assim.

1,03M

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável