Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

La course pour le "noyau cognitif" des LLM - un modèle de quelques milliards de paramètres qui sacrifie au maximum la connaissance encyclopédique pour la capacité. Il vit toujours activé et par défaut sur chaque ordinateur en tant que noyau de l'informatique personnelle LLM.

Ses caractéristiques se cristallisent lentement :

- Multimodal natif texte/vision/audio à la fois en entrée et en sortie.

- Architecture de style Matryoshka permettant de régler la capacité à la hausse ou à la baisse au moment du test.

- Raisonnement, également avec un réglage. (système 2)

- Utilisation agressive d'outils.

- Slots de finetuning LoRA sur l'appareil pour l'entraînement en temps de test, la personnalisation et la personnalisation.

- Délègue et vérifie juste les bonnes parties avec les oracles dans le cloud si Internet est disponible.

Il ne sait pas que le règne de Guillaume le Conquérant s'est terminé le 9 septembre 1087, mais il reconnaît vaguement le nom et peut rechercher la date. Il ne peut pas réciter le SHA-256 de la chaîne vide comme e3b0c442..., mais il peut le calculer rapidement si vous le souhaitez vraiment.

Ce qui manque à l'informatique personnelle LLM en termes de large connaissance du monde et de capacité de résolution de problèmes de haut niveau, il le compensera par une latence d'interaction super basse (surtout à mesure que le multimodal mûrit), un accès direct / privé aux données et à l'état, une continuité hors ligne, une souveraineté ("pas vos poids, pas votre cerveau"). c'est-à-dire beaucoup des mêmes raisons pour lesquelles nous aimons, utilisons et achetons des ordinateurs personnels au lieu d'avoir des clients légers accédant à un cloud via un bureau à distance ou autre.

27 juin 2025

Je suis tellement excité d'annoncer que Gemma 3n est là ! 🎉

🔊Compréhension multimodale (texte/audio/image/vidéo)

🤯Fonctionne avec aussi peu que 2 Go de RAM

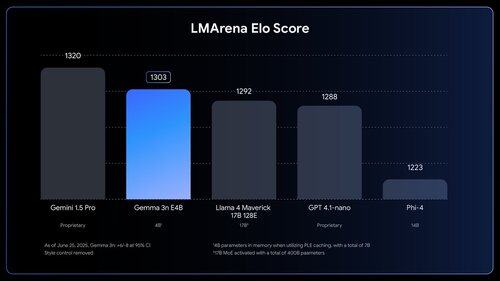

🏆Premier modèle de moins de 10 milliards avec un score de @lmarena_ai de 1300+

Disponible maintenant sur @huggingface, @kaggle, llama.cpp, et plus encore.

Les gens *ressentent-ils* combien de travail il reste à faire. Comme wow.

1,03M

Meilleurs

Classement

Favoris