Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

La corsa per il "nucleo cognitivo" LLM - un modello con qualche miliardo di parametri che sacrifica massimamente la conoscenza enciclopedica a favore della capacità. Vive sempre attivo e per impostazione predefinita su ogni computer come il kernel del personal computing LLM.

Le sue caratteristiche si stanno lentamente cristallizzando:

- Multimodale nativo testo/visione/audio sia in input che in output.

- Architettura in stile Matrioska che consente di regolare la capacità su e giù durante il test.

- Ragionamento, anche con un dial. (sistema 2)

- Uso aggressivo degli strumenti.

- Slot LoRA per il fine-tuning on-device per l'addestramento in tempo di test, personalizzazione e customizzazione.

- Delega e verifica solo le parti giuste con gli oracoli nel cloud se è disponibile internet.

Non sa che il regno di Guglielmo il Conquistatore è terminato il 9 settembre 1087, ma riconosce vagamente il nome e può cercare la data. Non può recitare lo SHA-256 della stringa vuota come e3b0c442..., ma può calcolarlo rapidamente se lo desideri davvero.

Ciò che il personal computing LLM manca in conoscenza del mondo e capacità di problem-solving di alto livello, lo compensarà con una latenza di interazione super bassa (soprattutto man mano che il multimodale matura), accesso diretto / privato ai dati e allo stato, continuità offline, sovranità ("non i tuoi pesi, non il tuo cervello"). ossia molte delle stesse ragioni per cui ci piacciono, usiamo e compriamo computer personali invece di avere client leggeri che accedono a un cloud tramite desktop remoto o simili.

27 giu 2025

Sono così entusiasta di annunciare che Gemma 3n è qui! 🎉

🔊 Comprensione multimodale (testo/audio/immagine/video)

🤯 Funziona con solo 2GB di RAM

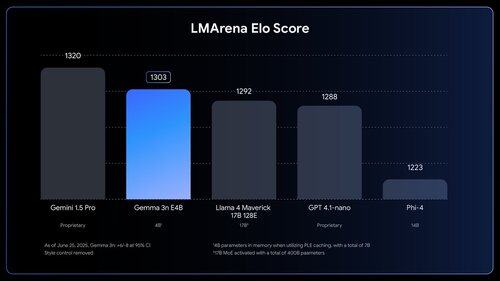

🏆 Primo modello sotto i 10B con un punteggio di @lmarena_ai di oltre 1300

Disponibile ora su @huggingface, @kaggle, llama.cpp e altro ancora.

Le persone *sentono* quanto lavoro c'è ancora da fare. Tipo wow.

1,03M

Principali

Ranking

Preferiti