Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Гонка за "когнитивным ядром" LLM - модель с несколькими миллиардами параметров, которая максимально жертвует энциклопедическими знаниями ради возможностей. Она всегда включена и по умолчанию находится на каждом компьютере в качестве ядра персональных вычислений LLM.

Её функции медленно кристаллизуются:

- Нативная мультимодальность текста/изображения/аудио как на входе, так и на выходе.

- Архитектура в стиле матрешки, позволяющая регулировать возможности вверх и вниз во время тестирования.

- Рассуждение, также с регулировкой. (система 2)

- Агрессивное использование инструментов.

- Настройка LoRA на устройстве для обучения во время тестирования, персонализации и кастомизации.

- Делегирует и дважды проверяет только нужные части с оракулами в облаке, если интернет доступен.

Она не знает, что правление Вильгельма Завоевателя закончилось 9 сентября 1087 года, но смутно распознает имя и может найти дату. Она не может воспроизвести SHA-256 пустой строки как e3b0c442..., но может быстро его вычислить, если вы действительно этого хотите.

Чего не хватает персональным вычислениям LLM в широких мировых знаниях и высококлассных способностях решения проблем, то они компенсируют супернизкой задержкой взаимодействия (особенно по мере взросления мультимодальности), прямым/приватным доступом к данным и состоянию, оффлайн-продолжением, суверенитетом ("не ваши веса - не ваш мозг"). т.е. многие из тех же причин, по которым мы любим, используем и покупаем персональные компьютеры вместо того, чтобы иметь тонкие клиенты, получающие доступ к облаку через удаленный рабочий стол или что-то подобное.

27 июн. 2025 г.

Я так рад объявить, что Gemma 3n здесь! 🎉

🔊Мультимодальное (текст/аудио/изображение/видео) понимание

🤯Работает с всего лишь 2 ГБ ОЗУ

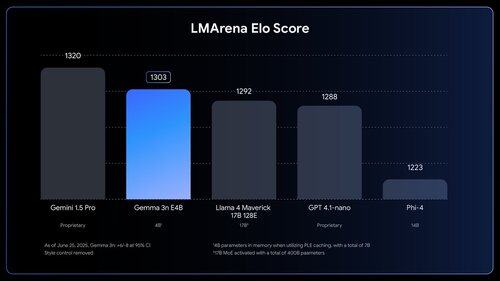

🏆Первая модель с менее чем 10B и оценкой @lmarena_ai более 1300+

Доступно сейчас на @huggingface, @kaggle, llama.cpp и других платформах.

Люди *чувствуют*, сколько работы еще предстоит сделать. Прямо вау.

1,03M

Топ

Рейтинг

Избранное