Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

A corrida pelo "núcleo cognitivo" do LLM - um modelo de alguns bilhões de parâmetros que sacrifica ao máximo o conhecimento enciclopédico pela capacidade. Ele vive sempre ativo e, por padrão, em todos os computadores como o kernel da computação pessoal LLM.

Suas características estão se cristalizando lentamente:

- Texto/visão/áudio nativamente multimodal na entrada e na saída.

- Arquitetura no estilo Matryoshka que permite um dial de capacidade para cima e para baixo no momento do teste.

- Raciocínio, também com um mostrador. (sistema 2)

- Uso agressivo de ferramentas.

- Slots LoRA de ajuste fino no dispositivo para treinamento, personalização e customização em tempo de teste.

- Delega e verifica as partes certas com os oráculos na nuvem, se a Internet estiver disponível.

Ele não sabe que o reinado de Guilherme, o Conquistador, terminou em 9 de setembro de 1087, mas reconhece vagamente o nome e pode procurar a data. Ele não pode recitar o SHA-256 de string vazia como e3b0c442..., mas pode calculá-lo rapidamente, caso você realmente queira.

O que falta à computação pessoal LLM em amplo conhecimento mundial e capacidade de resolução de problemas de primeira linha, ela compensará em latência de interação super baixa (especialmente à medida que o multimodal amadurece), acesso direto / privado a dados e estado, continuidade offline, soberania ("não são seus pesos, não são seu cérebro"). ou seja, muitas das mesmas razões pelas quais gostamos, usamos e compramos computadores pessoais em vez de ter thin clients acessando uma nuvem via área de trabalho remota ou algo assim.

27 de jun. de 2025

Estou muito animado para anunciar que Gemma 3n está aqui! 🎉

🔊Compreensão multimodal (texto/áudio/imagem/vídeo)

🤯Funciona com apenas 2 GB de RAM

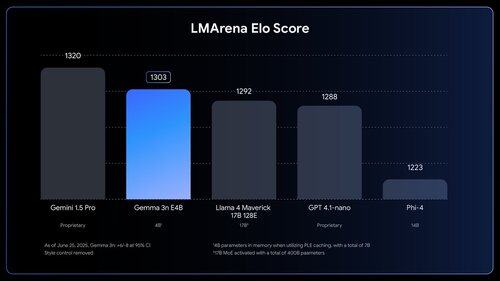

🏆Primeiro modelo abaixo de 10B com @lmarena_ai pontuação de 1300+

Disponível agora no @huggingface, @kaggle, llama.cpp e muito mais

As pessoas *sentem* quanto trabalho ainda há a fazer.

1,03M

Melhores

Classificação

Favoritos