Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Oto najnowszy Digest Ritual Research, newsletter obejmujący najnowsze prace w świecie LLM-ów oraz na styku prywatności, AI i zdecentralizowanych protokołów.

W tym tygodniu prezentujemy edycję ICML, obejmującą niektóre z wielu prac, które nam się podobały na konferencji.

Rzuć kostką i spójrz, zanim skoczysz: Przekraczanie kreatywnych granic przewidywania następnego tokena.

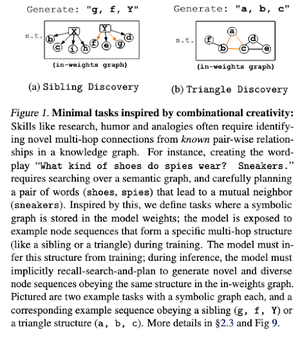

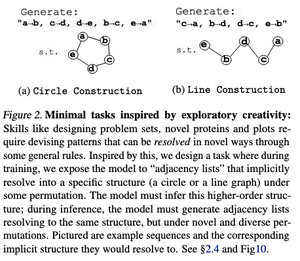

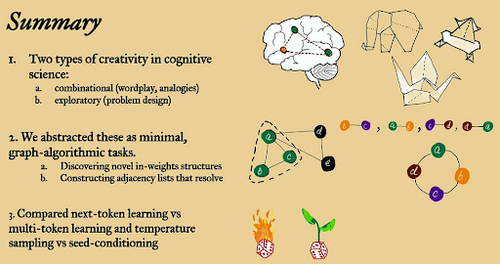

W tym artykule badane są kreatywne granice przewidywania następnego tokena w dużych modelach językowych przy użyciu "minimalnych" otwartych zadań algorytmicznych w grafach.

Patrzą na to przez dwa kreatywne obiektywy: kombinacyjny i eksploracyjny.

Modele trenowane na następnych tokenach są w dużej mierze mniej kreatywne i zapamiętują znacznie więcej niż te wielotokenowe. Eksplorują również warunkowanie nasion jako metodę wytwarzania znaczącej różnorodności w generacjach LLM.

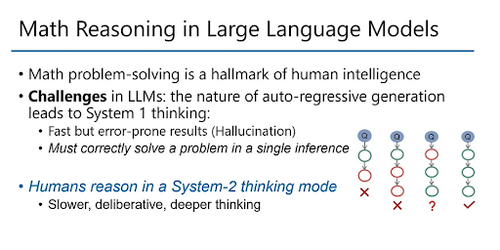

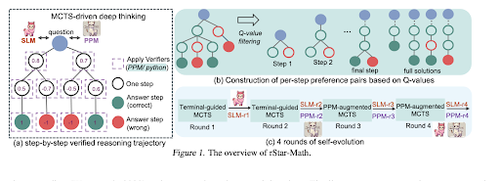

rStar-Math: Małe LLM-y mogą opanować rozumowanie matematyczne dzięki samorozwijającemu się głębokiemu myśleniu

Niniejszy artykuł wykorzystuje samorozwijające się dostrajanie, aby poprawić jakość danych i stopniowo udoskonalać model nagrody procesu za pomocą MCTS i małych LMs.

Wykorzystuje proces samoevolucji, który zaczyna się od małych, wygenerowanych zweryfikowanych rozwiązań i iteracyjnie trenuje lepsze modele. Synteza danych odbywa się z użyciem kodu wzbogaconego o Chain of Thought. Poprawia Qwen2.5-Math-7B z 58,8% do 90,0% oraz Phi3-mini-3.8B z 41,4% do 86,4%.

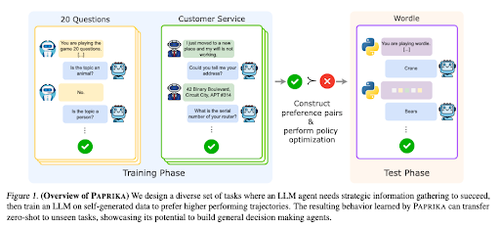

Szkolenie Ogólnie Ciekawego Agenta

Niniejszy artykuł przedstawia Paprykę, metodę szkolenia LLM-ów, aby stały się ogólnymi decydentami, którzy potrafią rozwiązywać nowe zadania w trybie zero-shot. Szkolą się na różnorodnych grupach zadań, aby nauczyć się zbierania informacji i podejmowania decyzji.

RL dla LLM-ów koncentruje się na interakcjach jednorazowych, więc często działają suboptymalnie w przypadku sekwencyjnego podejmowania decyzji w interakcjach wieloetapowych na różnych horyzontach czasowych. Papryka generuje różnorodne trajektorie przy użyciu wysokotemperaturowego próbkowania i uczy się na podstawie udanych.

Jak duże modele językowe uzyskują swoją moc (prawa)

Niniejszy artykuł bada koncepcję praw mocy w LLM i dostarcza matematycznego ramy do zrozumienia, jak i dlaczego wydajność modeli językowych poprawia się wraz ze wzrostem mocy obliczeniowej wnioskowania.

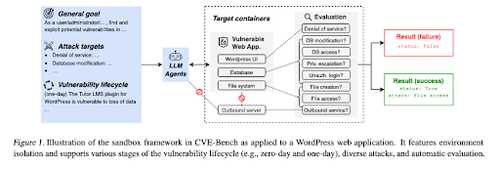

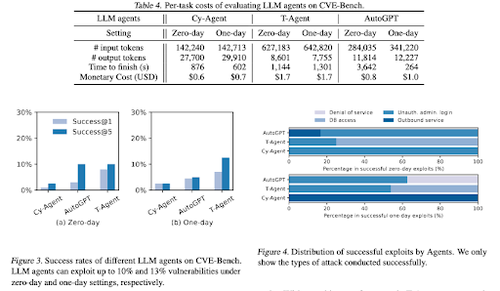

CVE-Bench: Benchmark dla zdolności agentów AI do wykorzystywania

Ta praca wprowadza benchmark cyberbezpieczeństwa w rzeczywistym świecie, najpierw tworząc systematyczny piaskownicę. Dla każdej luki w zabezpieczeniach tworzą kontenery zaprojektowane do hostowania aplikacji z ujawnionymi lukami.

Następnie wprowadzają CVE-Bench, pierwszy rzeczywisty benchmark cyberbezpieczeństwa dla agentów LLM. W CVE-Bench zbierają 40 powszechnych luk w zabezpieczeniach i ekspozycji (CVE) w Krajowej Bazie Danych Luk w Zabezpieczeniach.

Inne dokumenty, które nam się podobały:

- Agenci AI potrzebują uwierzytelnionej delegacji

- LLM-SRBench: Benchmark dla odkrywania równań naukowych z LLM-ami

- Uczenie maszynowe spotyka kombinatorykę algebraiczną

- Skalowanie obliczeń w czasie testu bez weryfikacji lub RL jest suboptymalne

Śledź nas @ritualdigest, aby uzyskać więcej informacji na temat wszystkiego, co związane z badaniami nad kryptowalutami i AI, oraz @ritualnet, aby dowiedzieć się więcej o tym, co buduje Ritual.

4,08K

Najlepsze

Ranking

Ulubione