Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Đây là bản tin Ritual Research Digest của tuần này, một bản tin đề cập đến những công trình mới nhất trong thế giới LLM và sự giao thoa giữa quyền riêng tư, AI và các giao thức phi tập trung.

Tuần này, chúng tôi giới thiệu một ấn bản ICML, bao gồm một số bài báo mà chúng tôi thích tại hội nghị.

Lăn xúc xắc & nhìn trước khi nhảy: Vượt qua giới hạn sáng tạo của dự đoán token tiếp theo.

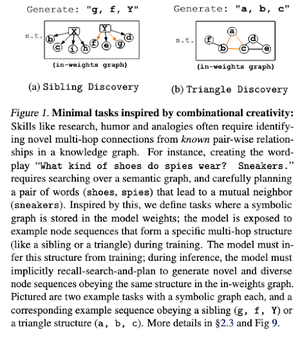

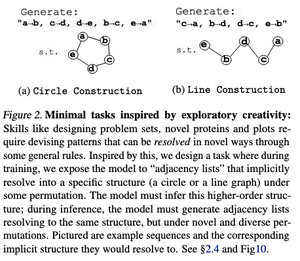

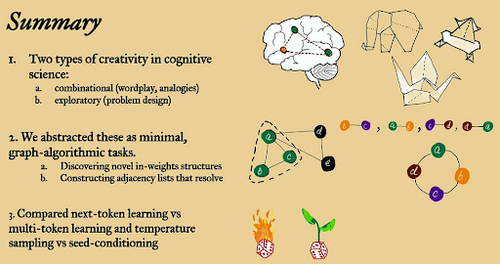

Trong bài báo này, họ khám phá giới hạn sáng tạo của dự đoán token tiếp theo trong các mô hình ngôn ngữ lớn bằng cách sử dụng các nhiệm vụ thuật toán đồ thị "tối thiểu" mở.

Họ nhìn nhận nó qua hai lăng kính sáng tạo: kết hợp và khám phá.

Các mô hình được huấn luyện theo từng token tiếp theo thường ít sáng tạo hơn và ghi nhớ nhiều hơn so với các mô hình đa token. Họ cũng khám phá điều kiện hạt giống như một phương pháp để tạo ra sự đa dạng có ý nghĩa trong các thế hệ LLM.

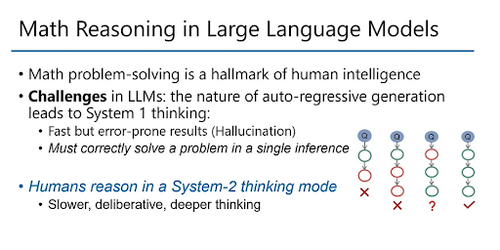

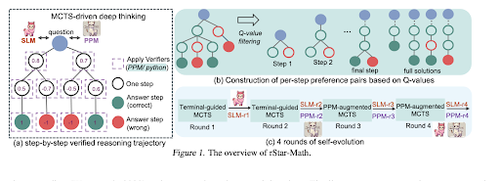

rStar-Math: Các LLM nhỏ có thể làm chủ lý luận toán học với tư duy sâu tự phát triển

Bài báo này sử dụng tinh chỉnh tự phát triển để nâng cao chất lượng dữ liệu và dần dần tinh chỉnh mô hình phần thưởng quy trình bằng cách sử dụng MCTS và các LLM nhỏ.

Nó sử dụng một quy trình tự tiến hóa bắt đầu từ những giải pháp đã được xác minh và huấn luyện các mô hình tốt hơn theo từng bước. Việc tổng hợp dữ liệu được thực hiện với mã tăng cường Chuỗi Tư duy. Nó cải thiện Qwen2.5-Math-7B từ 58.8% lên 90.0% và Phi3-mini-3.8B từ 41.4% lên 86.4%.

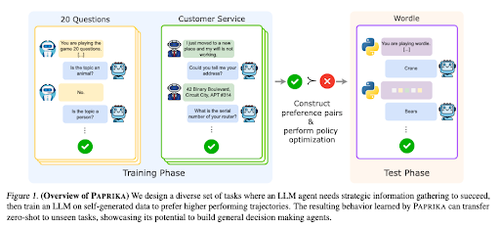

Đào tạo một Đại lý Tò mò Chung

Bài báo này giới thiệu Paprika, một phương pháp đào tạo các LLM để trở thành những người ra quyết định chung có thể giải quyết các nhiệm vụ mới mà không cần huấn luyện trước. Họ đào tạo trên các nhóm nhiệm vụ đa dạng để dạy cách thu thập thông tin và ra quyết định.

RL cho LLM tập trung vào các tương tác một lần, vì vậy chúng thường hoạt động không tối ưu trong việc ra quyết định liên tiếp với các tương tác nhiều lần qua các khoảng thời gian khác nhau. Paprika tạo ra các quỹ đạo đa dạng với việc lấy mẫu nhiệt độ cao và học hỏi từ những quỹ đạo thành công.

Cách mà các mô hình ngôn ngữ lớn (LLM) có được sức mạnh (Luật)

Bài báo này xem xét khái niệm về luật sức mạnh trong các LLM và cung cấp một khung toán học để hiểu cách thức và lý do tại sao hiệu suất của mô hình ngôn ngữ được cải thiện khi tăng cường tính toán suy diễn.

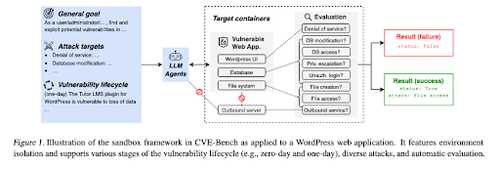

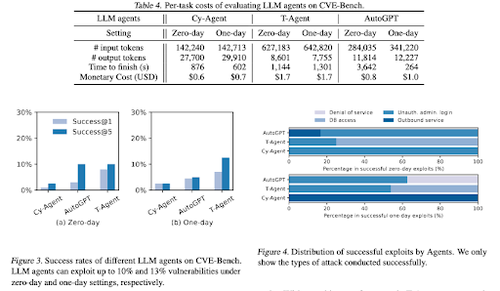

CVE-Bench: Một tiêu chuẩn đánh giá khả năng khai thác của các tác nhân AI

Công trình này giới thiệu một tiêu chuẩn đánh giá an ninh mạng trong thế giới thực bằng cách đầu tiên tạo ra một môi trường thử nghiệm có hệ thống. Đối với mỗi lỗ hổng, họ tạo ra các container được thiết kế để chứa một ứng dụng với các lỗ hổng đã được phơi bày.

Sau đó, họ giới thiệu CVE-Bench, tiêu chuẩn an ninh mạng thực tế đầu tiên cho các tác nhân LLM. Trong CVE-Bench, họ thu thập 40 Lỗ hổng và Phơi bày Thông thường (CVE) trong Cơ sở Dữ liệu Lỗ hổng Quốc gia.

Một số tài liệu khác mà chúng tôi thích:

- Các tác nhân AI cần ủy quyền xác thực

- LLM-SRBench: Thang đo cho việc khám phá phương trình khoa học với LLMs

- Học máy gặp Tổ hợp đại số

- Mở rộng tính toán thời gian kiểm tra mà không cần xác minh hoặc RL là không tối ưu

Theo dõi chúng tôi @ritualdigest để biết thêm về tất cả những điều liên quan đến nghiên cứu crypto x AI, và @ritualnet để tìm hiểu thêm về những gì Ritual đang xây dựng.

4,09K

Hàng đầu

Thứ hạng

Yêu thích