Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Цього тижня ви випустили Ritual Research Digest, інформаційний бюлетень, який висвітлює останні роботи у світі LLM та перетин конфіденційності, штучного інтелекту та децентралізованих протоколів.

Цього тижня ми представляємо видання ICML, що охоплює деякі з багатьох доповідей, які нам сподобалися на конференції.

Кидайте кубики та дивіться перед тим, як стрибнути: вихід за межі творчих меж прогнозування наступних токенів.

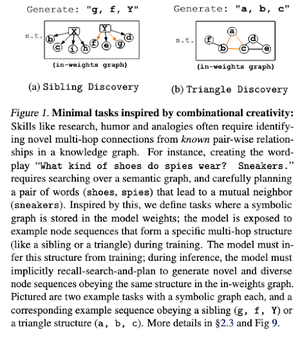

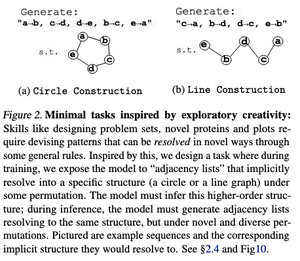

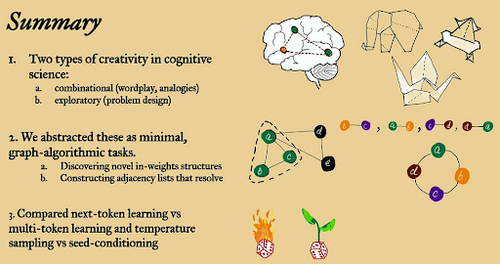

У цій статті вони досліджують творчі межі прогнозування наступних токенів у великих мовних моделях з використанням «мінімальних» алгоритмічних задач з відкритим графом.

Вони дивляться на це через дві творчі лінзи: комбінаційну та дослідницьку.

Моделі, навчені наступним токенам, в основному менш креативні і запам'ятовують набагато більше, ніж моделі з декількома токенами. Вони також досліджують кондиціонування насіння як метод створення значущої різноманітності в поколіннях LLM.

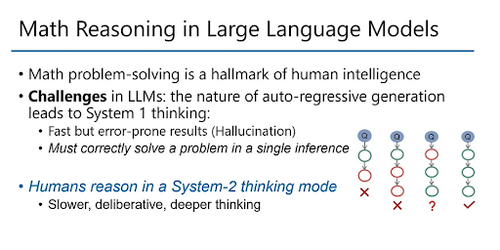

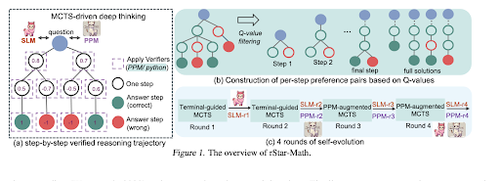

rStar-Math: Маленькі LLM можуть освоїти математичні міркування за допомогою глибокого мислення, що розвивається самостійно

У цьому документі використовується тонке налаштування, що саморозвивається, для покращення якості даних і поступового вдосконалення моделі винагороди за процес за допомогою MCTS і малих LM.

Він використовує процес самоеволюції, який починається з малого зі згенерованих перевірених рішень і ітеративно тренує кращі моделі. Синтез даних здійснюється за допомогою доповненого кодом ланцюга думок. Він покращує Qwen2.5-Math-7B з 58.8% до 90.0% та Phi3-mini-3.8B з 41.4% до 86.4%.

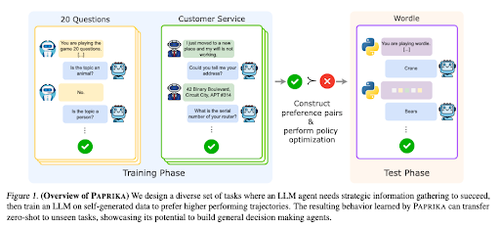

Дресирування взагалі допитливого агента

У цій статті представлена паприка, метод навчання LLM для прийняття загальних рішень, які можуть вирішувати нові завдання без пострілу. Вони тренуються в різних робочих групах, щоб навчити збору інформації та прийняття рішень.

RL для LLM фокусується на одноходовій взаємодії, тому вони часто працюють неоптимально при послідовному прийнятті рішень з багатоходовими взаємодіями на різних часових горизонтах. Паприка генерує різноманітні траєкторії за допомогою відбору проб при високій температурі та вчиться на успішних.

Як мавпи з великою мовою отримують свою силу (закони)

У цій статті розглядається концепція степеневих законів у LLM і надається математична основа для розуміння того, як і чому продуктивність мовної моделі покращується зі збільшенням обчислень висновків.

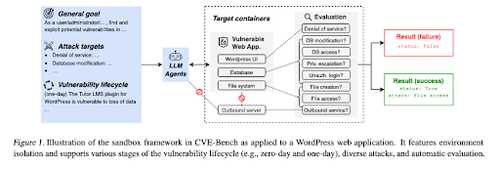

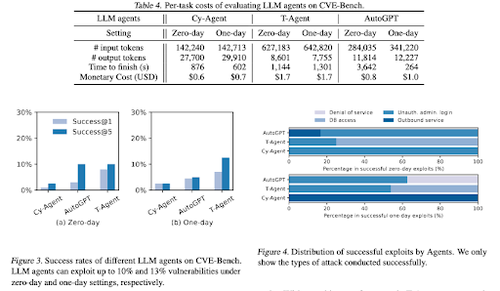

CVE-Bench: еталон здатності агентів штучного інтелекту до експлуатації

Ця робота знайомить з реальним еталоном кібербезпеки, спочатку створюючи систематичну пісочницю. Для кожної вразливості вони створюють контейнери, призначені для розміщення програми з відкритими вразливостями.

Потім вони представляють CVE-Bench, перший реальний еталон кібербезпеки для агентів LLM. У CVE-Bench вони збирають 40 поширених вразливостей та вразливостей (CVE) у Національній базі даних вразливостей.

Деякі інші статті, які нам сподобалися:

- Агентам штучного інтелекту потрібне автентифіковане делегування

- LLM-SRBench: еталон для наукового виявлення рівнянь за допомогою LLM

- Машинне навчання поєднується з алгебраїчною комбінаторикою

- Масштабування обчислень часу тестування без верифікації або RL є неоптимальним

Слідкуйте за нами @ritualdigest, щоб дізнатися більше про дослідження crypto x AI, а також @ritualnet дізнатися більше про те, що створює Ritual.

4,08K

Найкращі

Рейтинг

Вибране