Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hier is de Ritual Research Digest van deze week, een nieuwsbrief die het laatste werk in de wereld van LLM's en de kruising van privacy, AI en gedecentraliseerde protocollen behandelt.

Deze week presenteren we een ICML-editie, waarin we enkele van de vele papers bespreken die we leuk vonden op de conferentie.

Gooi de dobbelstenen & kijk voordat je springt: Verder gaan dan de creatieve grenzen van next-token voorspelling.

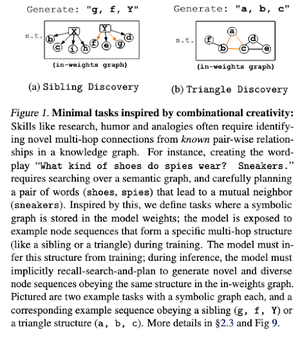

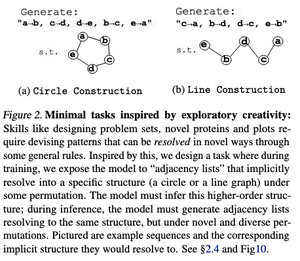

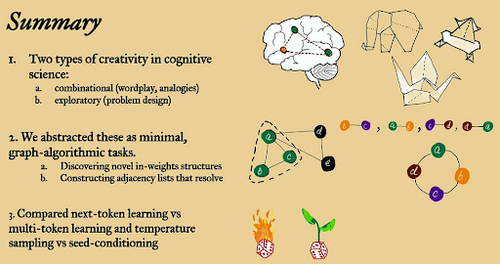

In dit artikel verkennen ze de creatieve grenzen van next-token voorspelling in grote taalmodellen met behulp van "minimale" open-eind graf algoritmische taken.

Ze kijken erdoorheen met twee creatieve lenzen: combinatorisch en explorerend.

Next-token-getrainde modellen zijn over het algemeen minder creatief en onthouden veel meer dan multi-token modellen. Ze verkennen ook zaadconditionering als een methode om betekenisvolle diversiteit in LLM-generaties te produceren.

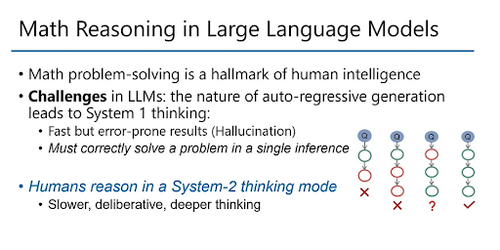

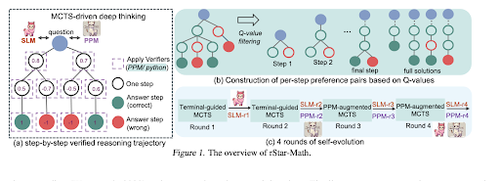

rStar-Math: Kleine LLM's kunnen wiskundig redeneren beheersen met zelfontwikkeld diep denken

Dit paper maakt gebruik van zelf-evoluerende fine-tuning om de datakwaliteit te verbeteren en geleidelijk het proces beloningsmodel te verfijnen met behulp van MCTS en kleine LMs.

Het gebruikt een zelf-evolutieproces dat klein begint met gegenereerde geverifieerde oplossingen en iteratief betere modellen traint. De datasynthese wordt gedaan met code-augmented Chain of Thought. Het verbetert Qwen2.5-Math-7B van 58,8% naar 90,0% en Phi3-mini-3.8B van 41,4% naar 86,4%.

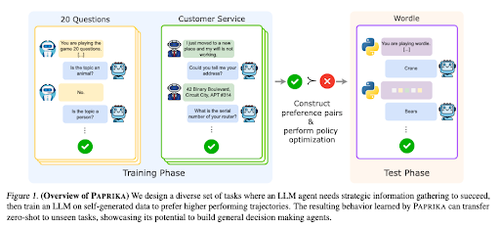

Training van een Algemeen Nieuwsgierige Agent

Dit paper introduceert Paprika, een methode voor het trainen van LLM's om algemene besluitvormers te worden die nieuwe taken zero-shot kunnen oplossen. Ze trainen op diverse taakgroepen om informatieverzameling en besluitvorming te onderwijzen.

RL voor LLM's richt zich op enkele interacties, waardoor ze vaak suboptimaal presteren bij sequentiële besluitvorming met meerdere interacties over verschillende tijdshorizonten. Paprika genereert diverse trajecten met hoge temperatuur sampling en leert van succesvolle.

Hoe Krijgen Grote Taalmonkeys Hun Kracht (Wetten)

Dit artikel onderzoekt het concept van machtswetten in LLM's en biedt een wiskundig kader om te begrijpen hoe en waarom de prestaties van taalmodellen verbeteren met toenemende inferentiecomputing.

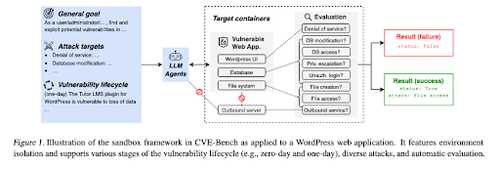

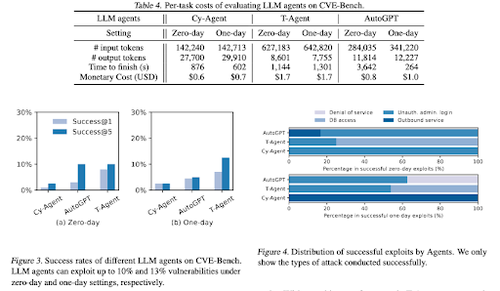

CVE-Bench: Een benchmark voor de mogelijkheid van AI-agenten om te exploiteren

Dit werk introduceert een benchmark voor cybersecurity in de echte wereld door eerst een systematische sandbox te creëren. Voor elke kwetsbaarheid creëren ze containers die zijn ontworpen om een app met blootgestelde kwetsbaarheden te hosten.

Vervolgens introduceren ze CVE-Bench, de eerste echte cybersecurity benchmark voor LLM-agenten. In CVE-Bench verzamelen ze 40 Common Vulnerabilities and Exposures (CVEs) in de National Vulnerability Database.

Enkele andere artikelen die we leuk vonden:

- AI-agenten hebben geverifieerde delegatie nodig

- LLM-SRBench: Benchmark voor wetenschappelijke vergelijking ontdekking met LLM's

- Machine Learning ontmoet algebraïsche combinatoriek

- Schalen van testtijdcomputing zonder verificatie of RL is suboptimaal

Volg ons @ritualdigest voor meer over alles wat met crypto x AI-onderzoek te maken heeft, en @ritualnet om meer te leren over wat Ritual aan het bouwen is.

4,09K

Boven

Positie

Favorieten