Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Вот дайджест Ritual Research за эту неделю, информационный бюллетень, охватывающий последние работы в мире LLM и пересечении конфиденциальности, ИИ и децентрализованных протоколов.

На этой неделе мы представляем выпуск ICML, в котором рассматриваются некоторые из множества статей, которые нам понравились на конференции.

Бросьте кости и смотрите, прежде чем прыгнуть: выход за пределы творческих возможностей предсказания следующего токена.

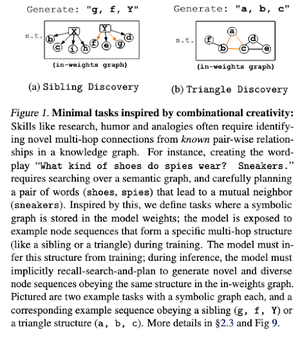

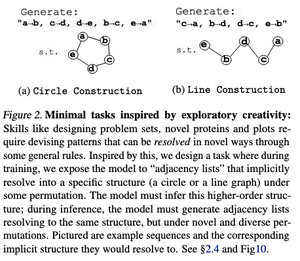

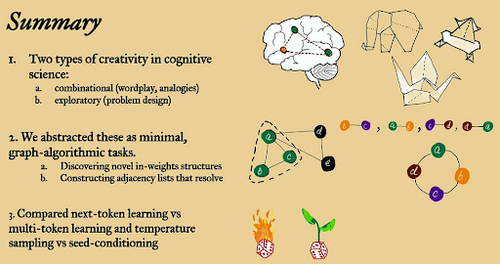

В этой статье они исследуют творческие пределы предсказания следующего токена в больших языковых моделях, используя "минимальные" открытые графовые алгоритмические задачи.

Они смотрят на это через две творческие призмы: комбинированную и исследовательскую.

Модели, обученные на следующем токене, в значительной степени менее креативны и запоминают гораздо больше, чем многотокенные. Они также исследуют условие семени как метод для создания значимого разнообразия в генерациях LLM.

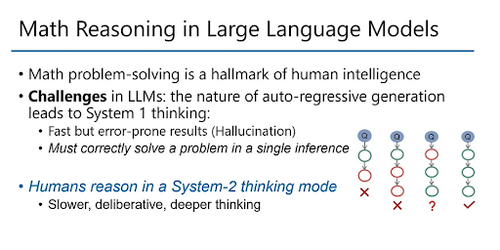

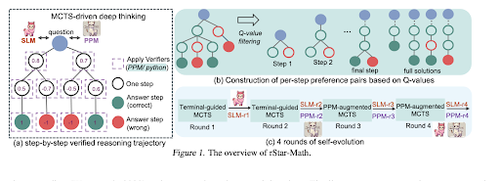

rStar-Math: Малые LLM могут овладеть математическим мышлением с помощью саморазвивающегося глубокого мышления

В этой статье используется саморазвивающаяся донастройка для повышения качества данных и постепенной доработки модели вознаграждения процесса с использованием MCTS и малых LMs.

Он использует процесс самоэволюции, который начинается с небольших сгенерированных проверенных решений и итеративно обучает лучшие модели. Синтез данных выполняется с помощью кода, дополненного цепочкой размышлений. Это улучшает Qwen2.5-Math-7B с 58.8% до 90.0% и Phi3-mini-3.8B с 41.4% до 86.4%.

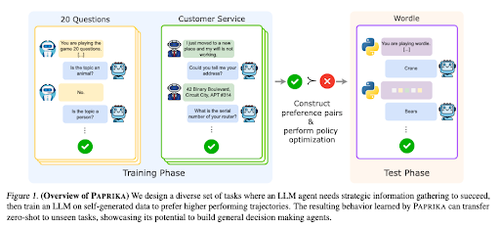

Обучение Общему Любопытному Агенту

В этой статье представлена Паприка, метод обучения LLM для того, чтобы они стали общими принимающими решения, способными решать новые задачи без предварительного обучения. Они обучаются на разнообразных группах задач, чтобы научить сбору информации и принятию решений.

RL для LLMs сосредоточен на одноразовых взаимодействиях, поэтому они часто работают не оптимально при последовательном принятии решений с многократными взаимодействиями на разных временных горизонтах. Paprika генерирует разнообразные траектории с высоким температурным сэмплированием и учится на успешных.

Как большие языковые модели получают свою мощность (законы)

В этой статье рассматривается концепция законов мощности в больших языковых моделях и предоставляется математическая основа для понимания того, как и почему производительность языковых моделей улучшается с увеличением вычислительных ресурсов для вывода.

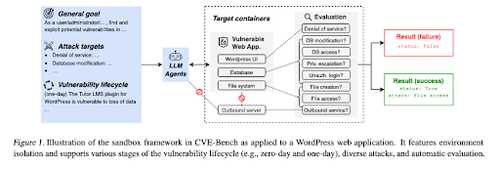

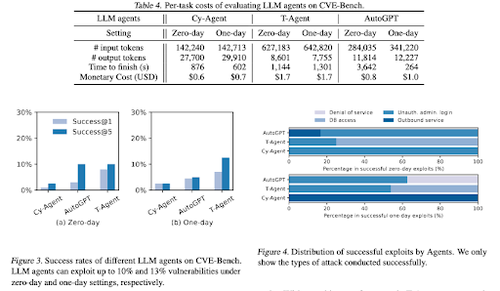

CVE-Bench: Бенчмарк для способности ИИ-агентов использовать уязвимости

В данной работе представлен бенчмарк в области кибербезопасности, который начинается с создания систематического песочницы. Для каждой уязвимости создаются контейнеры, предназначенные для размещения приложения с открытыми уязвимостями.

Затем они представляют CVE-Bench, первый реальный кибербезопасностный бенчмарк для агентов LLM. В CVE-Bench они собирают 40 Общих Уязвимостей и Экспозиций (CVE) из Национальной базы данных уязвимостей.

Некоторые другие статьи, которые нам понравились:

- Агентам ИИ нужна аутентифицированная делегация

- LLM-SRBench: Бенчмарк для научного открытия уравнений с помощью LLM

- Машинное обучение встречается с алгебраической комбинаторикой

- Масштабирование вычислений во время тестирования без верификации или RL является субоптимальным

Подписывайтесь на нас @ritualdigest, чтобы узнать больше о всем, что связано с криптовалютами и исследованиями ИИ, а также @ritualnet, чтобы узнать больше о том, что строит Ritual.

4,09K

Топ

Рейтинг

Избранное