Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aqui está o Ritual Research Digest desta semana, um boletim informativo que cobre os trabalhos mais recentes no mundo dos LLMs e a interseção de privacidade, IA e protocolos descentralizados.

Esta semana, apresentamos uma edição do ICML, cobrindo alguns dos muitos artigos que gostamos na conferência.

Jogue os dados e olhe antes de pular: Indo além dos limites criativos da previsão do próximo token.

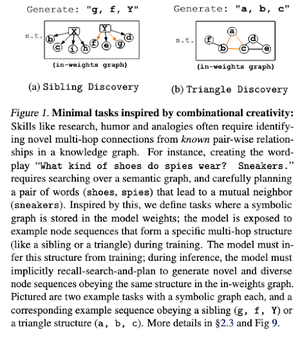

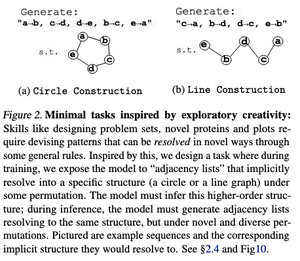

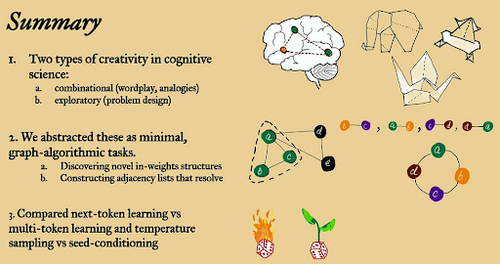

Neste artigo, eles exploram os limites criativos da previsão do próximo token em grandes modelos de linguagem usando tarefas algorítmicas de grafo aberto "mínimas".

Eles olham para isso através de duas lentes criativas: combinatória e exploratória.

Os modelos treinados em tokens próximos são muito menos criativos e memorizam muito mais do que os multi-tokens. Eles também exploram o condicionamento de sementes como um método para produzir diversidade significativa nas gerações de LLM.

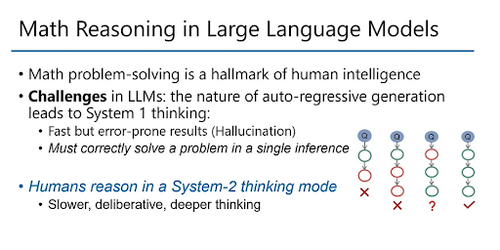

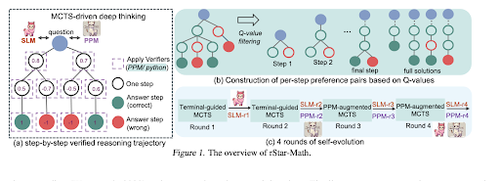

rStar-Math: Pequenos LLMs podem dominar o raciocínio matemático com pensamento profundo auto-evoluído

Este artigo emprega ajuste fino autoevolutivo para melhorar a qualidade dos dados e refinar gradualmente o modelo de recompensa do processo usando MCTS e pequenos LMs.

Ele usa um processo de autoevolução que começa pequeno com soluções verificadas geradas e treina iterativamente modelos melhores. A síntese dos dados é feita com código aumentado Cadeia de Pensamento. Melhora o Qwen2.5-Math-7B de 58,8% para 90,0% e o Phi3-mini-3,8B de 41,4% para 86,4%.

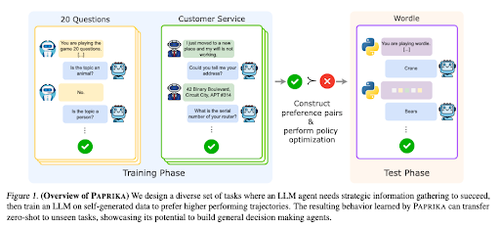

Treinando um agente geralmente curioso

Este artigo apresenta o Paprika, um método para treinar LLMs para se tornarem tomadores de decisão gerais que podem resolver novas tarefas sem disparo. Eles treinam em diversos grupos de tarefas para ensinar a coleta de informações e a tomada de decisões.

O RL para LLMs se concentra em interações de turno único, portanto, eles geralmente têm um desempenho abaixo do ideal na tomada de decisão sequencial com interações de vários turnos em diferentes horizontes de tempo. A páprica gera diversas trajetórias com amostragem de alta temperatura e aprende com as bem-sucedidas.

Como os grandes macacos linguísticos obtêm seu poder (leis)

Este artigo examina o conceito de leis de potência em LLMs e fornece uma estrutura matemática para entender como e por que o desempenho do modelo de linguagem melhora com o aumento da computação de inferência.

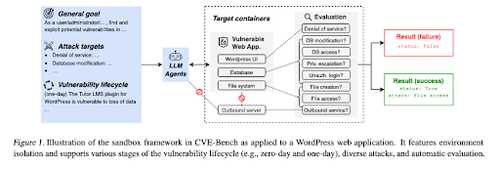

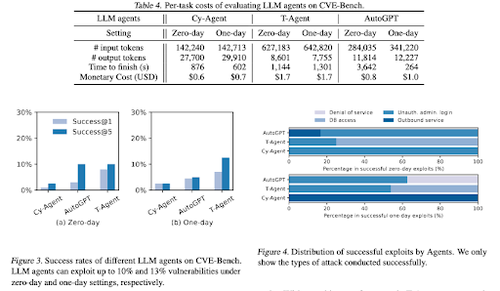

CVE-Bench: uma referência para a capacidade de exploração dos agentes de IA

Este trabalho apresenta um benchmark de segurança cibernética do mundo real, criando primeiro uma sandbox sistemática. Para cada vulnerabilidade, eles criam contêineres projetados para hospedar um aplicativo com vulnerabilidades expostas.

Em seguida, eles apresentam o CVE-Bench, o primeiro benchmark de segurança cibernética do mundo real para agentes LLM. No CVE-Bench, eles coletam 40 vulnerabilidades e exposições comuns (CVEs) no banco de dados nacional de vulnerabilidades.

Alguns outros papéis que gostamos:

- Os agentes de IA precisam de delegação autenticada

- LLM-SRBench: Referência para descoberta de equações científicas com LLMs

- Machine Learning encontra Combinatória Algébrica

- O dimensionamento da computação em tempo de teste sem verificação ou RL é abaixo do ideal

Siga-nos @ritualdigest para saber mais sobre todas as pesquisas de criptomoedas x IA e @ritualnet para saber mais sobre o que a Ritual está construindo.

4,1K

Melhores

Classificação

Favoritos