Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Partner Zarządzający @coinfund_io. Były inwestor w akcje w Jennison Associates; IBD w Credit Suisse

Osobiste opinie. Nie doradztwo inwestycyjne

Przyspieszająca konwergencja

@HyperliquidX DAT ogłoszone dzisiaj rano, prowadzone przez Atlas Merchant Capital (Bob Diamond były CEO Barclays) z udziałem D1 Capital (Dan Sundheim były CIO Viking). Oczekuje się, że były prezydent Boston Fed Eric Rosengren dołączy do zarządu.

Seth Ginns13 lip, 19:19

Tak, firmy skarbowe powinny handlować z premią do NAV

Co?

🧵

10,39K

Użytkownik Seth Ginns udostępnił ponownie

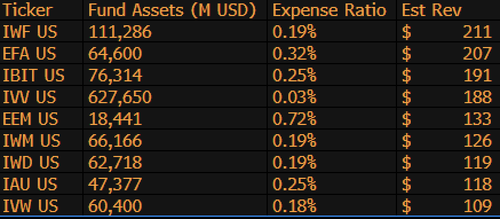

$IBIT jest teraz 3. najwyżej przychodowym ETF-em BlackRock spośród 1 197 funduszy i brakuje mu tylko 9 miliardów dolarów, aby stać się numerem 1. To kolejna szalona statystyka dla 1,5-letniego (dosłownie niemowlęcego) ETF-u. Oto lista Top 10 dla BLK (a tak przy okazji, co z zapomnianym $IWF na pierwszym miejscu, kto by pomyślał?)

107,98K

Użytkownik Seth Ginns udostępnił ponownie

Stablecoiny drastycznie zmienią sposób, w jaki instytucje finansowe podchodzą do kryptowalut, a szef inwestycji płynnych w CoinFund @sethginns niedawno dołączył do @thebenkeadyshow, aby porozmawiać o swoim przekonaniu co do rosnącej liczby ich zastosowań ⬇️

845

Głosowanie nad ustawą o stablecoinach w Senacie dzisiaj o 16:30 ET

Senate Cloakroom17 cze 2025

At 4:30pm, the Senate is expected to proceed to two roll call votes on the following:

1. (If cloture is invoked) Confirmation of Executive Calendar #98 Olivia Trusty to be a Member of the Federal Communications Commission for the remainder of the term expiring June 30, 2025.

2. Passage of Cal. #66, S.1582, GENIUS Act, as amended.

744

Użytkownik Seth Ginns udostępnił ponownie

Zyski on-chain pozostają poza zasięgiem większości ludzi. Mimo że są bezzezwolowe, ich złożoność zniechęca wielu do uczestnictwa.

Dzięki naszej bliskiej współpracy z @Veda_labs, te złożoności na Plasma zostaną uproszczone, aby przynieść zrównoważony zysk masom.

33,71K

Użytkownik Seth Ginns udostępnił ponownie

Szybkie prognozy.

2025: Model z parametrami 100B+ wytrenowany na d-sieciach.

2026: Pierwszy model 50B+ *multi-modalny* wytrenowany na dobrowolnych GPU.

2027-8: Przy wszystkich innych równych, model konkurencyjny GPT-3 175B gęsty odtworzony.

2030+: Prawdziwy "frontier" zdecentralizowany bieg, 1T parametry+.

3,66K

Użytkownik Seth Ginns udostępnił ponownie

Myśli/prognozy dotyczące zdecentralizowanego szkolenia AI, 2025.

1. Jedną rzeczą, którą można powiedzieć, jest to, że zdecydowanie znajdujemy się w innym świecie ze zdecentralizowanym szkoleniem AI niż 18 miesięcy temu. Wtedy zdecentralizowane szkolenie było niemożliwe, a teraz jest na rynku i stanowi dziedzinę.

2. Nie ma wątpliwości, że ostatecznym celem d-szkolenia jest trenowanie konkurencyjnych, nowatorskich modeli na d-sieciach. W związku z tym jesteśmy dopiero na początku naszej konkurencyjnej podróży, ale poruszamy się szybko.

3. Teraz panuje konsensus, że możemy wstępnie trenować i po-trenować modele o wielkości wielu miliardów parametrów (głównie LLM, głównie architektury transformatorowe) na d-sieciach. Obecny stan sztuki sięga ~100B, z górnym końcem, który jest w zasięgu, ale nie został jeszcze pokazany.

4. Teraz panuje konsensus, że możemy trenować modele <10B parametrów na d-sieciach dość wykonalnie. Były również konkretne studia przypadków (głównie od @gensynai @PrimeIntellect @NousResearch), w których trenowano lub są trenowane modele o 10B, 32B, 40B parametrach. Post-treningowy rój @gensynai działa na modelach o wielkości do 72B parametrów.

5. Innowacja @PluralisHQ unieważniła teraz "niemożliwość" skalowalnego wstępnego szkolenia na d-sieciach, eliminując wąskie gardło związane z nieefektywnością komunikacyjną. Jednak surowe FLOPy, niezawodność i weryfikowalność pozostają wąskimi gardłami dla tych typów sieci - problemy, które są bardzo rozwiązywalne, ale zajmie trochę czasu, aby je technicznie rozwiązać. Z Protocol Learning od Pluralis, jak to wygląda, myślę, że osiągniemy modele ~100B w ciągu 6-12 miesięcy.

6. Jak przejść od modeli 100B do 300B parametrów? Myślę, że musimy znaleźć sposoby na efektywne i płynne dzielenie parametrów oraz utrzymanie pamięci poszczególnych urządzeń na stosunkowo niskim poziomie (np. <32GB pamięci na urządzenie). Myślę, że musimy osiągnąć 20 EFlops w sieci; to oznacza coś w rodzaju 10-20K urządzeń konsumenckich działających przez 4-6 tygodni na treningu.

Ogólnie rzecz biorąc, d-szkolenie ma potencjał, aby stać się bardzo ekscytującą przestrzenią. Niektóre z jego innowacji są już rozważane do szerokich zastosowań AI.

4,14K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi