Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Socio Director @coinfund_io. ex inversionista de acciones en Jennison Associates; IBD en Credit Suisse

Opiniones personales. No es un consejo de inversión

Convergencia acelerada

@HyperliquidX DAT anunció esto am liderado por Atlas Merchant Capital (Bob Diamond Fmr CEO Barclays) con participación de D1 Capital (Dan Sundheim Fmr CIO Viking). Se espera que el presidente de la Fed de Boston, Eric Rosengren, se una a la junta

Seth Ginns13 jul, 19:19

Sí, las empresas de tesorería deberían cotizar con una prima sobre el valor liquidativo

¿Qué?

🧵

10.38K

Seth Ginns reposteó

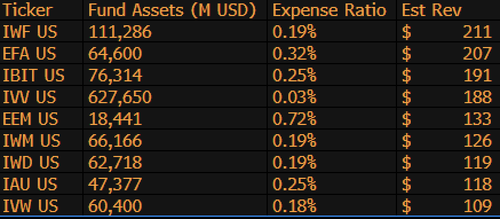

$IBIT es ahora el tercer ETF que más ingresos genera para BlackRock de 1.197 fondos, y está a sólo 9.000 millones de dólares de ser el #1. Solo otra estadística loca para un ETF de 1,5 años (literalmente un bebé). Aquí está la lista de los 10 mejores para BLK (aparte, ¿qué tal el olvidable $IWF en el primer lugar, quién lo diría?)

107.98K

Seth Ginns reposteó

Las stablecoins cambiarán drásticamente la forma en que las instituciones financieras abordan las criptomonedas, y el jefe de Inversiones Líquidas de CoinFund, @sethginns se unió recientemente a @thebenkeadyshow para hablar sobre su convicción en su creciente número de casos ⬇️ de uso

845

Vota el proyecto de ley de stablecoins del Senado hoy a las 4:30pm ET

Senate Cloakroom17 jun 2025

A las 4:30 p.m., se espera que el Senado proceda a dos votaciones nominales sobre lo siguiente:

1. (Si se invoca la clausura) Confirmación del Calendario Ejecutivo # 98 Olivia Trusty para ser miembro de la Comisión Federal de Comunicaciones por el resto del período que expira el 30 de junio de 2025.

2. Aprobación de Cal. #66, S.1582, Ley GENIUS, según enmendada.

737

Seth Ginns reposteó

Los rendimientos en cadena siguen estando fuera del alcance de la mayoría de las personas. A pesar de no tener permisos, su complejidad desanima a muchos a participar.

A través de nuestra estrecha asociación con @Veda_labs, estas complejidades en el plasma se eliminarán para brindar un rendimiento sostenible a las masas.

33.71K

Seth Ginns reposteó

Predicciones rápidas.

2025: Modelo de parámetros 100B+ entrenado en d-networks.

2026: Primer modelo 50B+ *multimodal* entrenado en GPU voluntarias.

2027-8: En igualdad de condiciones, se reproduce el modelo competitivo denso GPT-3 175B.

2030+: Una verdadera carrera descentralizada de "frontera", 1T params+.

3.66K

Seth Ginns reposteó

Pensamientos/predicciones en el entrenamiento descentralizado de IA, 2025.

1. Una cosa que decir es que definitivamente estamos en un mundo diferente con el entrenamiento de IA descentralizado que hace 18 meses. En aquel entonces, la capacitación descentralizada era imposible y ahora está en el mercado y es un campo.

2. No se equivoque, el objetivo final de d-training es entrenar modelos competitivos y de frontera en d-networks. Como tal, estamos solo al comienzo de nuestro viaje competitivo, pero nos estamos moviendo rápido.

3. Ahora hay consenso en que podemos preentrenar y posentrenar modelos de parámetros de miles de millones de dólares (en su mayoría LLM, en su mayoría arquitecturas de transformadores) en redes d. El estado actual de la técnica es de hasta ~100B, cuyo extremo superior está a la vista pero no se ha mostrado.

4. Ahora es consenso que podemos entrenar modelos de parámetros <10B en redes d de manera bastante factible. También ha habido estudios de casos específicos (principalmente de @gensynai @PrimeIntellect @NousResearch) en los que se han entrenado o se están entrenando los parámetros 10B, 32B, 40B. El enjambre post-entrenamiento de @gensynai funciona con modelos de hasta 72 mil millones de parámetros.

5. La innovación @PluralisHQ ha invalidado ahora la "imposibilidad" de la formación previa escalable en las redes d al eliminar el cuello de botella de la ineficiencia de la comunicación. Sin embargo, los FLOPs brutos, la fiabilidad y la verificabilidad siguen siendo cuellos de botella para este tipo de redes, problemas que son muy solucionables pero que tardarán algún tiempo en resolverse técnicamente. Con el aprendizaje de protocolo de Pluralis tal como está, creo que llegamos a ~ 100 mil millones de modelos en un marco de tiempo de 6 a 12 meses.

6. ¿Cómo pasamos de los modelos de parámetros 100B a 300B? Creo que tenemos que encontrar formas de fragmentar los parámetros de forma eficaz y fluida y de mantener la memoria de los dispositivos individuales relativamente baja (por ejemplo, <32 GB de memoria por dispositivo). Creo que tenemos que llegar a 20 EFlops en una red; eso significa algo así como 10-20K dispositivos de consumo funcionando durante 4-6 semanas en un entrenamiento.

En general, el d-training está preparado para ser un espacio muy emocionante. Algunas de sus innovaciones ya se están considerando para amplias aplicaciones de IA.

4.14K

Populares

Ranking

Favoritas

Onchain en tendencia

Tendencia en X

Principales fondos recientes

Más destacadas