المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

@coinfund_io الشريك الإداري. مستثمر سابق في الأسهم في Jennison Associates. IBD في كريدي سويس

الآراء الشخصية. ليست نصيحة استثمارية

تسارع التقارب

أعلنت @HyperliquidX DAT عن ذلك بقيادة Atlas Merchant Capital (بوب دايموند ، الرئيس التنفيذي لشركة Barclays) بمشاركة D1 Capital (Dan Sundheim Fmr CIO Viking). من المتوقع أن ينضم رئيس بنك الاحتياطي الفيدرالي في بوسطن إريك روزنغرين إلى مجلس الإدارة

Seth Ginns13 يوليو، 19:19

نعم ، يجب أن تتداول شركات الخزينة بعلاوة على صافي قيمة الأصول

ماذا؟

🧵

10.39K

Seth Ginns أعاد النشر

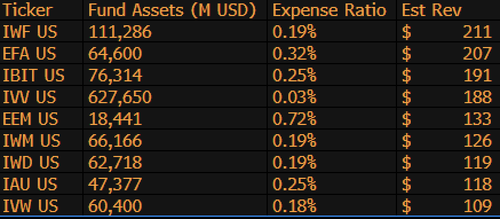

$IBIT هو الآن ثالث أعلى ETF مدردا للدخل ل BlackRock من بين 1,197 صندوقا ، وهو على بعد 9 مليارات دولار فقط من كونه # 1. مجرد إحصائية مجنونة أخرى لصندوق ETF البالغ من العمر 1.5 عاما (حرفيا رضيع). فيما يلي قائمة أفضل 10 ل BLK (بغض النظر عن ذلك ، ماذا عن $IWF المنسى في المرتبة الأولى ، من يعرف؟)

107.98K

التصويت على مشروع قانون العملات المستقرة في مجلس الشيوخ اليوم الساعة 4:30 مساء بالتوقيت الشرقي

Senate Cloakroom17 يونيو 2025

في الساعة 4:30 مساء ، من المتوقع أن يشرع مجلس الشيوخ في إجراء تصويتين بنداء الأسماء على ما يلي:

1. (في حالة استدعاء الجلطة) تأكيد التقويم التنفيذي # 98 أوليفيا تراستي لتكون عضوا في لجنة الاتصالات الفيدرالية للفترة المتبقية من المدة التي تنتهي في 30 يونيو 2025.

2. تمرير Cal. # 66 ، S.1582 ، قانون العبقرية ، بصيغته المعدلة.

745

Seth Ginns أعاد النشر

تنبؤات سريعة.

2025: نموذج معلمة 100B + تم تدريبه على d-Networks.

2026: تم تدريب أول نموذج 50B + * متعدد الوسائط * على وحدات معالجة الرسومات المتطوعة.

2027-8: كل شيء آخر متساو ، تم إعادة إنتاج نموذج تنافسي كثيف GPT-3 175B.

2030+: تشغيل لامركزي "حدودي" حقيقي ، 1T params +.

3.66K

Seth Ginns أعاد النشر

أفكار / تنبؤات في التدريب اللامركزي على الذكاء الاصطناعي ، 2025.

1. شيء واحد يجب قوله هو أننا بالتأكيد في عالم مختلف مع تدريب الذكاء الاصطناعي اللامركزي عما كنا عليه قبل 18 شهرا. في ذلك الوقت ، كان التدريب اللامركزي مستحيلا وهو الآن في السوق وهو مجال.

2. لا تخطئ ، الهدف النهائي من d-training هو تدريب النماذج التنافسية والحدودية على d-Networks. على هذا النحو ، نحن في بداية رحلتنا التنافسية ، لكننا نتحرك بسرعة.

3. لقد تم الإجماع الآن على أنه يمكننا التدريب المسبق والتدريب اللاحق لنماذج المعلمات التي تبلغ ملياراتها (معظمها من LLMs ، ومعظمها من بنى المحولات) على d-Networks. تصل الحالة الحالية للفن إلى ~ 100B ، وينتهي الجزء العلوي منها في الأفق ولكن لم يتم عرضه.

4. لقد تم إجماع الآن على أنه يمكننا تدريب نماذج معلمات <10B على شبكات d بشكل عملي جدا. كانت هناك أيضا دراسات حالة محددة (بشكل أساسي من @gensynai @PrimeIntellect @NousResearch) حيث تم تدريب أو يتم تدريب المعلمات 10B و 32B و 40B. يعمل سرب ما بعد التدريب في @gensynai على نماذج معلمات تصل إلى 72B.

5. لقد أبطل الابتكار @PluralisHQ الآن "استحالة" التدريب المسبق القابل للتطوير على الشبكات d عن طريق إزالة عنق الزجاجة لعدم كفاءة الاتصالات. ومع ذلك ، تظل FLOPs الأولية والموثوقية وإمكانية التحقق من الاختناقات لهذه الأنواع من الشبكات - وهي مشاكل قابلة للحل للغاية ولكنها ستستغرق بعض الوقت لحلها تقنيا. مع تعلم البروتوكول من Pluralis كما هو ، أعتقد أننا نصل إلى نماذج ~ 100B في إطار زمني من 6 إلى 12 شهرا.

6. كيف ننتقل من نماذج المعلمات 100B إلى 300B؟ أعتقد أننا بحاجة إلى إيجاد طرق لتقسيم المعلمات بشكل فعال وسلس والحفاظ على ذاكرة الجهاز الفردية منخفضة نسبيا (على سبيل المثال ، ذاكرة <32 جيجابايت لكل جهاز). أعتقد أننا بحاجة إلى الوصول إلى 20 EFlops في الشبكة. هذا يعني شيئا مثل 10-20 ألف جهاز استهلاكي يعمل لمدة 4-6 أسابيع في التدريب.

بشكل عام ، من المتوقع أن يكون d-training مساحة مثيرة للغاية. يتم بالفعل النظر في بعض ابتكاراتها لتطبيقات الذكاء الاصطناعي الواسعة.

4.14K

الأفضل

المُتصدِّرة

التطبيقات المفضلة

رائج على السلسة

رائج على منصة X

أهم عمليات التمويل الأخيرة

الأبرز