Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Geschäftsführender Gesellschafter @coinfund_io. Ehemaliger Aktieninvestor bei Jennison Associates; IBD bei der Credit Suisse

Persönliche Meinungen. Keine Anlageberatung

Konvergenz beschleunigt

@HyperliquidX DAT gab heute Morgen bekannt, dass Atlas Merchant Capital (Bob Diamond, ehemaliger CEO von Barclays) die Führung übernommen hat, mit Beteiligung von D1 Capital (Dan Sundheim, ehemaliger CIO von Viking). Der ehemalige Präsident der Boston Fed, Eric Rosengren, wird voraussichtlich dem Vorstand beitreten.

Seth Ginns13. Juli, 19:19

Ja, Treasury-Unternehmen sollten mit einem Aufschlag auf den NAV handeln.

Was?

🧵

10,38K

Seth Ginns erneut gepostet

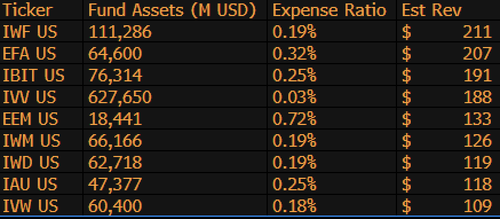

$IBIT ist jetzt der dritthöchste umsatzgenerierende ETF von BlackRock aus 1.197 Fonds und nur 9 Milliarden Dollar davon entfernt, die Nummer 1 zu sein. Nur eine weitere verrückte Statistik für einen 1,5 Jahre alten (buchstäblich ein Säugling) ETF. Hier ist die Top-10-Liste für BLK (übrigens, was ist mit dem vergessenswerten $IWF an der Spitze, wer hätte das gedacht?)

107,98K

Seth Ginns erneut gepostet

Stablecoins werden die Art und Weise, wie Finanzinstitute Kryptowährungen angehen, drastisch verändern, und der Head of Liquid Investments von CoinFund, @sethginns, hat kürzlich bei @thebenkeadyshow darüber gesprochen, wie überzeugt er von der wachsenden Anzahl ihrer Anwendungsfälle ist ⬇️

845

Abstimmung über den Stablecoin-Gesetzentwurf im Senat heute um 16:30 Uhr ET

Senate Cloakroom17. Juni 2025

Um 16:30 Uhr wird erwartet, dass der Senat zu zwei namentlichen Abstimmungen über Folgendes übergeht:

1. (Falls die Schließung beschlossen wird) Bestätigung des Exekutivkalenders #98 Olivia Trusty als Mitglied der Federal Communications Commission für den Rest der Amtszeit, die am 30. Juni 2025 endet.

2. Verabschiedung von Cal. #66, S.1582, GENIUS Act, in der geänderten Fassung.

738

Seth Ginns erneut gepostet

Onchain-Erträge bleiben für die meisten Menschen unerreichbar. Trotz der Erlaubnisfreiheit schreckt ihre Komplexität viele von der Teilnahme ab.

Durch unsere enge Partnerschaft mit @Veda_labs werden diese Komplexitäten auf Plasma abstrahiert, um nachhaltige Erträge für die Massen zu bringen.

33,71K

Seth Ginns erneut gepostet

Schnelle Vorhersagen.

2025: 100B+ Parameter-Modell, das auf d-Netzwerken trainiert wird.

2026: Erstes 50B+ *multi-modales* Modell, das auf freiwilligen GPUs trainiert wird.

2027-8: Bei gleichbleibenden Bedingungen wird ein konkurrenzfähiges Modell mit 175B dichten Parametern von GPT-3 reproduziert.

2030+: Ein echtes "Frontier"-dezentralisiertes Lauf, 1T+ Parameter.

3,66K

Seth Ginns erneut gepostet

Gedanken/Vorhersagen zum dezentralen KI-Training, 2025.

1. Eines ist sicher: Wir befinden uns definitiv in einer anderen Welt mit dezentralem KI-Training als vor 18 Monaten. Damals war dezentrales Training unmöglich und jetzt ist es auf dem Markt und ein eigenes Feld.

2. Machen Sie keinen Fehler, das Endziel des d-Trainings ist es, wettbewerbsfähige, fortschrittliche Modelle auf d-Netzwerken zu trainieren. Daher stehen wir erst am Anfang unserer Wettbewerbsreise, aber wir bewegen uns schnell.

3. Es besteht jetzt Konsens, dass wir Multi-Milliarden-Parameter-Modelle (hauptsächlich LLMs, hauptsächlich Transformer-Architekturen) auf d-Netzwerken vortrainieren und nachtrainieren können. Der aktuelle Stand der Technik liegt bei bis zu ~100B, das obere Ende ist in Sicht, wurde aber noch nicht gezeigt.

4. Es besteht jetzt Konsens, dass wir <10B-Parameter-Modelle auf d-Netzwerken ziemlich machbar trainieren können. Es gab auch spezifische Fallstudien (hauptsächlich von @gensynai @PrimeIntellect @NousResearch), bei denen 10B, 32B, 40B Parameter trainiert wurden oder werden. Der Post-Training-Schwarm von @gensynai arbeitet mit Modellen von bis zu 72B Parametern.

5. Die Innovation von @PluralisHQ hat nun die "Unmöglichkeit" des skalierbaren Vortrainings auf d-Netzwerken ungültig gemacht, indem sie den Engpass der Kommunikationsineffizienz beseitigt hat. Roh-FLOPs, Zuverlässigkeit und Überprüfbarkeit bleiben jedoch Engpässe für diese Arten von Netzwerken – Probleme, die sehr lösbar sind, aber einige Zeit in Anspruch nehmen werden, um technisch gelöst zu werden. Mit dem Protokoll-Lernen von Pluralis, wie es derzeit steht, denke ich, dass wir in einem Zeitraum von 6-12 Monaten zu ~100B-Modellen gelangen.

6. Wie kommen wir von 100B zu 300B-Parameter-Modellen? Ich denke, wir müssen Wege finden, Parameter effektiv und flüssig zu sharden und den individuellen Gerätespeicher relativ niedrig zu halten (z. B. <32GB Speicher pro Gerät). Ich denke, wir müssen in einem Netzwerk auf 20 EFlops kommen; das bedeutet etwas wie 10-20K Endgeräte, die 4-6 Wochen lang für ein Training laufen.

Insgesamt steht d-Training kurz davor, ein sehr spannendes Feld zu werden. Einige seiner Innovationen werden bereits für breite KI-Anwendungen in Betracht gezogen.

4,14K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten