Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Associé directeur @coinfund_io. Ancien investisseur en actions chez Jennison Associates ; IBD au Credit Suisse

Opinions personnelles. Pas de conseil en investissement

Convergence accélérée

@HyperliquidX DAT a annoncé ce matin, dirigé par Atlas Merchant Capital (Bob Diamond, ancien PDG de Barclays) avec la participation de D1 Capital (Dan Sundheim, ancien CIO de Viking). L'ancien président de la Fed de Boston, Eric Rosengren, devrait rejoindre le conseil d'administration.

Seth Ginns13 juil., 19:19

Oui, les sociétés de trésorerie devraient se négocier à un prix supérieur à la valeur nette d'inventaire

Quoi ?

🧵

10,38K

Seth Ginns a reposté

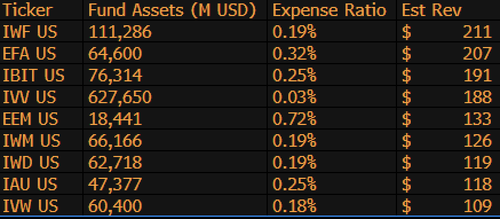

$IBIT est maintenant le 3ème ETF générant le plus de revenus pour BlackRock parmi 1 197 fonds, et il ne lui manque que 9 milliards de dollars pour être numéro 1. Encore une statistique incroyable pour un ETF âgé de 1,5 an (littéralement un nourrisson). Voici le Top 10 pour BLK (au fait, que dire de l'oubliable $IWF à la première place, qui l'aurait cru ?)

107,98K

Seth Ginns a reposté

Les stablecoins vont radicalement changer la façon dont les institutions financières abordent la crypto, et le responsable des investissements liquides de CoinFund, @sethginns, a récemment rejoint @thebenkeadyshow pour parler de sa conviction dans leur nombre croissant de cas d'utilisation ⬇️

845

Vote sur le projet de loi sur les stablecoins au Sénat aujourd'hui à 16h30 ET

Senate Cloakroom17 juin 2025

À 16h30, le Sénat devrait procéder à deux votes par appel nominal sur les points suivants :

1. (Si la clôture est invoquée) Confirmation du calendrier exécutif n° 98, Olivia Trusty, en tant que membre de la Commission fédérale des communications pour le reste du mandat expirant le 30 juin 2025.

2. Adoption de Cal. n° 66, S.1582, loi GENIUS, telle que modifiée.

739

Seth Ginns a reposté

Les rendements on-chain restent hors de portée pour la plupart des gens. Bien qu'ils soient sans autorisation, leur complexité décourage beaucoup de participer.

Grâce à notre partenariat étroit avec @Veda_labs, ces complexités sur Plasma seront simplifiées pour apporter un rendement durable aux masses.

33,71K

Seth Ginns a reposté

Prédictions rapides.

2025 : Modèle de plus de 100 milliards de paramètres entraîné sur des réseaux décentralisés.

2026 : Premier modèle *multi-modal* de plus de 50 milliards entraîné sur des GPU de bénévoles.

2027-2028 : Tout le reste étant égal, modèle compétitif dense GPT-3 de 175 milliards reproduit.

2030+ : Un véritable fonctionnement décentralisé "frontière", plus de 1 trillion de paramètres.

3,66K

Seth Ginns a reposté

Réflexions/prédictions sur l'entraînement d'IA décentralisé, 2025.

1. Une chose à dire est que nous sommes définitivement dans un monde différent avec l'entraînement d'IA décentralisé par rapport à il y a 18 mois. À l'époque, l'entraînement décentralisé était impossible et maintenant, il est sur le marché et constitue un domaine.

2. Ne vous y trompez pas, l'objectif final de l'entraînement décentralisé est de former des modèles compétitifs et de pointe sur des réseaux décentralisés. En tant que tel, nous ne sommes qu'au début de notre parcours compétitif, mais nous avançons rapidement.

3. Il est désormais consensuel que nous pouvons pré-entraîner et post-entraîner des modèles de plusieurs milliards de paramètres (principalement des LLM, principalement des architectures de transformateurs) sur des réseaux décentralisés. L'état actuel de l'art atteint jusqu'à ~100B, le haut de gamme étant en vue mais n'ayant pas encore été montré.

4. Il est désormais consensuel que nous pouvons entraîner des modèles de <10B paramètres sur des réseaux décentralisés de manière assez réalisable. Il y a également eu des études de cas spécifiques (principalement de @gensynai @PrimeIntellect @NousResearch) où des modèles de 10B, 32B, 40B paramètres ont été ou sont en cours d'entraînement. Le groupe de post-entraînement de @gensynai fonctionne sur des modèles allant jusqu'à 72B paramètres.

5. L'innovation de @PluralisHQ a maintenant invalidé l'"impossibilité" de pré-entraînement évolutif sur des réseaux décentralisés en éliminant le goulot d'étranglement de l'inefficacité de communication. Cependant, les FLOPs bruts, la fiabilité et la vérifiabilité restent des goulots d'étranglement pour ces types de réseaux -- des problèmes qui sont très solvables mais qui prendront un certain temps à résoudre techniquement. Avec l'apprentissage par protocole de Pluralis tel qu'il est, je pense que nous atteindrons des modèles d'environ 100B dans un délai de 6 à 12 mois.

6. Comment passer de modèles de 100B à 300B paramètres ? Je pense que nous devons trouver des moyens de fragmenter les paramètres de manière efficace et fluide et de garder la mémoire individuelle des appareils relativement basse (par exemple, <32 Go de mémoire par appareil). Je pense que nous devons atteindre 20 EFlops dans un réseau ; cela signifie quelque chose comme 10-20K appareils consommateurs fonctionnant pendant 4-6 semaines sur un entraînement.

Dans l'ensemble, l'entraînement décentralisé est sur le point d'être un domaine très excitant. Certaines de ses innovations sont déjà considérées pour des applications d'IA larges.

4,14K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables