Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Sócio-gerente @coinfund_io. Ex-investidor de ações na Jennison Associates; IBD no Credit Suisse

Opiniões pessoais. Não é um conselho de investimento

Aceleração da convergência

@HyperliquidX DAT anunciou que isso é liderado pela Atlas Merchant Capital (Bob Diamond, Fmr, CEO do Barclays) com participação da D1 Capital (Dan Sundheim, Fmr, CIO Viking). O presidente do Fmr Boston Fed, Eric Rosengren, deve se juntar ao conselho

Seth Ginns13 de jul., 19:19

Sim, as empresas de tesouraria devem negociar com um prêmio em relação ao NAV

Que?

🧵

10,43K

Seth Ginns repostou

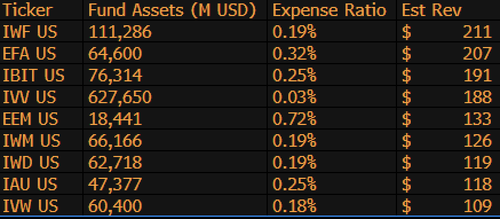

$IBIT é agora o 3º ETF de maior geração de receita para a BlackRock entre 1.197 fundos e está a apenas US$ 9 bilhões de ser #1. Apenas mais uma estatística insana para um ETF de 1,5 ano (literalmente um bebê). Aqui está a lista dos 10 melhores para BLK (à parte, que tal o $IWF esquecível no primeiro lugar, quem diria?)

107,99K

Seth Ginns repostou

As stablecoins mudarão drasticamente a maneira como as instituições financeiras abordam as criptomoedas, e o chefe de investimentos líquidos da CoinFund @sethginns recentemente se juntou a @thebenkeadyshow para falar sobre sua convicção em seu crescente número de casos ⬇️ de uso

852

Vote no projeto de lei de stablecoin do Senado hoje às 16h30 ET

Senate Cloakroom17 de jun. de 2025

Às 16h30, espera-se que o Senado proceda a duas votações nominais sobre o seguinte:

1. (Se a clotura for invocada) Confirmação do Calendário Executivo #98 Olivia Trusty para ser membro da Comissão Federal de Comunicações pelo restante do mandato que expira em 30 de junho de 2025.

2. Passagem de Cal. # 66, S.1582, Lei GENIUS, conforme alterada.

780

Seth Ginns repostou

Os rendimentos onchain permanecem fora do alcance da maioria das pessoas. Apesar de não ter permissão, sua complexidade desencoraja muitos a participar.

Por meio de nossa estreita parceria com a @Veda_labs, essas complexidades do Plasma serão abstraídas para trazer rendimento sustentável para as massas.

33,72K

Seth Ginns repostou

Previsões rápidas.

2025: Modelo de parâmetro 100B+ treinado em d-redes.

2026: Primeiro modelo 50B+ *multimodal* treinado em GPUs voluntárias.

2027-8: Tudo o mais igual, GPT-3 175B modelo competitivo denso reproduzido.

2030+: Uma verdadeira corrida descentralizada de "fronteira", 1T params+.

3,67K

Seth Ginns repostou

Pensamentos/previsões no treinamento descentralizado de IA, 2025.

1. Uma coisa a dizer é que estamos definitivamente em um mundo diferente com o treinamento de IA descentralizado do que estávamos há 18 meses. Naquela época, o treinamento descentralizado era impossível e agora está no mercado e é um campo.

2. Não se engane, o objetivo final do d-training é treinar modelos competitivos e de fronteira em d-networks. Como tal, estamos apenas no início de nossa jornada competitiva, mas estamos nos movendo rapidamente.

3. Agora é consenso que podemos pré-treinar e pós-treinar modelos de vários bilhões de parâmetros (principalmente LLMs, principalmente arquiteturas de transformadores) em d-redes. O estado da arte atual é de até ~ 100B, cuja extremidade superior está à vista, mas não foi mostrada.

4. Agora é consenso que podemos treinar modelos de parâmetros <10B em redes d de forma bastante viável. Também houve estudos de caso específicos (principalmente de @gensynai @PrimeIntellect @NousResearch) em que os parâmetros 10B, 32B, 40B foram ou estão sendo treinados. O enxame pós-treinamento da @gensynai opera em modelos de parâmetros de até 72B.

5. A inovação @PluralisHQ agora invalidou a "impossibilidade" de pré-treinamento escalável em redes d, removendo o gargalo da ineficiência da comunicação. No entanto, FLOPs brutos, confiabilidade e verificabilidade continuam sendo gargalos para esses tipos de redes - problemas que são muito solucionáveis, mas levarão algum tempo para serem resolvidos tecnicamente. Com o Protocolo de Aprendizagem do Pluralis como está, acho que chegamos a ~ 100B modelos em um período de 6 a 12 meses.

6. Como obtemos de modelos de parâmetros 100B a 300B? Acho que precisamos encontrar maneiras de fragmentar parâmetros de forma eficaz e fluida e manter a memória do dispositivo individual relativamente baixa (por exemplo, <32 GB de memória por dispositivo). Acho que precisamos chegar a 20 EFlops em uma rede; isso significa algo como 10-20 mil dispositivos de consumo rodando por 4-6 semanas em um treinamento.

No geral, o d-training está prestes a ser um espaço muito empolgante. Algumas de suas inovações já estão sendo consideradas para amplas aplicações de IA.

4,15K

Melhores

Classificação

Favoritos

Em alta on-chain

Em alta no X

Principais fundos da atualidade

Mais notável