Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

samsja

Condurre la ricerca presso @PrimeIntellect

Mi sono reso conto durante il nostro evento a Berlino che ci sono molti giovani talentuosi e ambiziosi in Europa. Solo (quasi) nessuna azienda ispiratrice per costruire il futuro né VC che abbiano il coraggio di dare loro una possibilità.

Non c'è da meravigliarsi se tutti vogliono venire a sf|

43,84K

Open ai sarà ricordata come una delle aziende più ispiratrici di tutti i tempi

Noam Brown19 lug, 15:52

Oggi, noi di @OpenAI abbiamo raggiunto un traguardo che molti consideravano lontano anni: prestazioni da medaglia d'oro al 2025 IMO con un LLM di ragionamento generale—sotto gli stessi limiti di tempo degli esseri umani, senza strumenti. Per quanto straordinario possa sembrare, è ancora più significativo di quanto riportato nel titolo 🧵

8,27K

Non vedo il senso di definire la dimensione del batch a livello di singola GPU nel codice. Questo significa che è necessario cambiare manualmente il parametro della dimensione del batch quando si scala l'esperimento verso l'alto o verso il basso.

Immagino che storicamente sia stato fatto in codici che non hanno l'accumulo dei gradienti?

1,53K

samsja ha ripubblicato

Se sei all'ICML e sei interessato all'inferenza verificabile, assicurati di passare dal nostro poster!

Presenteremo TOPLOC, un metodo di hashing delle attivazioni efficiente che funziona in una varietà di contesti, ad esempio cambiando le configurazioni di inferenza o anche i modelli.

16 luglio, 16:30, E-1106

1,34K

samsja ha ripubblicato

Nuovo post sul blog e nuova libreria sono disponibili ora!

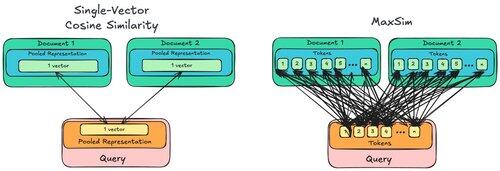

Il BP riguarda MaxSim, perché è *ordini di grandezza* molto più esigente rispetto alla normale similarità coseno, e perché le GPU non se ne preoccupano, ma le CPU sì!

La libreria è maxsim-cpu, che consente alle CPU di essere veloci e di mantenere la calma, anche.

16,86K

Curioso di provare questo con diloco, farei comunque bs=1 sull'ottimizzatore interno e otterrei comunque i benefici del parallelismo dei dati.

Micah Goldblum10 lug, 22:12

🚨 Did you know that small-batch vanilla SGD without momentum (i.e. the first optimizer you learn about in intro ML) is virtually as fast as AdamW for LLM pretraining on a per-FLOP basis? 📜 1/n

1,86K

anche la seniority nell'ingegneria significa essere in grado di lavorare con il debito tecnico degli altri

samsja5 lug, 21:13

Unpopular opinion but technical debt is good, it's needed to accelerate and shrink timeline

2,25K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari