Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

samsja

Führende Forschung an der @PrimeIntellect

Mir ist bei unserer Veranstaltung in Berlin aufgefallen, dass es in Europa viele talentierte und ehrgeizige junge Menschen gibt. Nur (fast) keine inspirierenden Unternehmen, um die Zukunft zu gestalten, und keine VCs, die den Mut haben, ihnen eine Chance zu geben.

Kein Wunder, dass jeder nach SF kommen will|

43,84K

Open AI wird als eines der inspirierendsten Unternehmen aller Zeiten in Erinnerung bleiben.

Noam Brown19. Juli, 15:52

Heute haben wir bei @OpenAI einen Meilenstein erreicht, den viele für Jahre entfernt hielten: eine Leistung auf Goldmedaillen-Niveau bei der IMO 2025 mit einem allgemeinen reasoning LLM – unter denselben Zeitlimits wie Menschen, ohne Werkzeuge. So bemerkenswert das auch klingt, es ist noch bedeutender als die Schlagzeile 🧵

8,28K

Ich sehe keinen Sinn darin, die Batch-Größe auf GPU-Ebene im Code zu definieren. Das bedeutet, dass man den Batch-Größenparameter manuell ändern muss, wenn man das Experiment hoch- oder herunterskaliert.

Ich nehme an, das wurde historisch in Codebasen gemacht, die kein Gradient Accumulation haben?

1,53K

samsja erneut gepostet

Wenn Sie auf der ICML sind und an verifizierbarer Inferenz interessiert sind, sollten Sie unbedingt an unserem Poster vorbeischauen!

Wir werden TOPLOC vorstellen, eine effiziente Aktivierungs-Hashing-Methode, die in verschiedenen Einstellungen funktioniert, z. B. beim Wechsel von Inferenz-Setups oder sogar Modellen.

16. Juli, 16:30 Uhr, E-1106

1,34K

samsja erneut gepostet

Neuer Blogbeitrag & neue Bibliothek sind jetzt verfügbar!

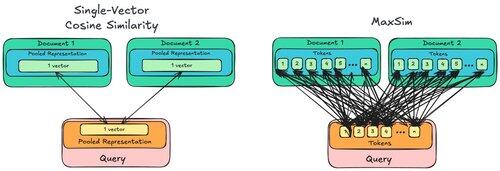

Der BP handelt von MaxSim, warum es *um Größenordnungen* viel anspruchsvoller ist als die normale Kosinusähnlichkeit und warum GPUs das nicht interessiert, CPUs jedoch schon!

Die Bibliothek ist maxsim-cpu, die es ermöglicht, dass CPUs schnell und entspannt arbeiten können.

16,86K

Neugierig, das mit diloco auszuprobieren, würde immer noch bs=1 im inneren Optimierer verwenden und dennoch die Vorteile der Datenparallelität erhalten.

Micah Goldblum10. Juli, 22:12

🚨 Wusstest du, dass Vanilla SGD in kleinen Chargen ohne Momentum (d.h. der erste Optimierer, den du in der Einführung in ML lernst) praktisch so schnell ist wie AdamW für das Pretraining von LLMs auf Basis von FLOP? 📜 1/n

1,86K

Auch die Seniorität in der Technik bedeutet, mit den technischen Schulden anderer arbeiten zu können.

samsja5. Juli, 21:13

Unpopuläre Meinung, aber technische Schulden sind gut, sie sind notwendig, um den Zeitrahmen zu beschleunigen und zu verkleinern.

2,26K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten