Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

samsja

Investigación líder en @PrimeIntellect

Me di cuenta en nuestro evento de Berlín que hay muchos jóvenes talentosos y ambiciosos en Europa. Simplemente (casi) no hay empresas inspiradoras para construir el futuro ni capitalistas de riesgo que tengan los pantalones para darles una oportunidad.

No es de extrañar que todos quieran venir a sf|

44,78K

Open AI será recordada como una de las empresas más inspiradoras de todos los tiempos.

Noam Brown19 jul, 15:52

Hoy, en @OpenAI logramos un hito que muchos consideraban a años de distancia: un rendimiento de nivel medalla de oro en la IMO 2025 con un LLM de razonamiento general—bajo los mismos límites de tiempo que los humanos, sin herramientas. Por impresionante que suene, es aún más significativo que el titular 🧵

8,36K

No veo el sentido de que la base de código defina el tamaño del lote a nivel de cada GPU. Esto significa que hay que cambiar manualmente el parámetro del tamaño del lote al escalar hacia arriba/abajo el experimento.

Supongo que históricamente se ha hecho en bases de código que no tienen acumulación de gradientes?

1,59K

samsja republicó

¡Si estás en ICML y te interesa la inferencia verificable, asegúrate de pasar por nuestro póster!

Presentaremos TOPLOC, un método eficiente de hashing de activación que funciona en una variedad de configuraciones, por ejemplo, cambiando configuraciones de inferencia o incluso modelos.

16 de julio, 4:30 p.m., E-1106

1,39K

samsja republicó

¡Nueva entrada en el blog y nueva biblioteca ya disponibles!

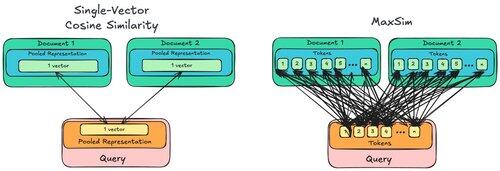

La entrada del blog trata sobre MaxSim, por qué es *órdenes de magnitud* mucho más exigente que la similitud coseno normal, y por qué a las GPU no les importa, ¡pero a las CPU sí!

La biblioteca es maxsim-cpu, que permite que las CPU sean rápidas y se mantengan tranquilas también.

16,91K

Curioso por probar esto con diloco, aún haría bs=1 en el optimizador interno y seguiría obteniendo los beneficios de la paralelización de datos.

Micah Goldblum10 jul, 22:12

🚨 ¿Sabías que el SGD de vainilla en lotes pequeños sin momentum (es decir, el primer optimizador que aprendes en introducción al ML) es prácticamente tan rápido como AdamW para el preentrenamiento de LLM en base a cada FLOP? 📜 1/n

1,92K

también la antigüedad en la ingeniería implica poder trabajar con la deuda técnica de otros

samsja5 jul, 21:13

Opinión impopular, pero la deuda técnica es buena, es necesaria para acelerar y reducir el tiempo.

2,32K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado