Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

clem 🤗

Co-fondatore e CEO @HuggingFace 🤗 , la piattaforma aperta e collaborativa per i costruttori di intelligenza artificiale

clem 🤗 ha ripubblicato

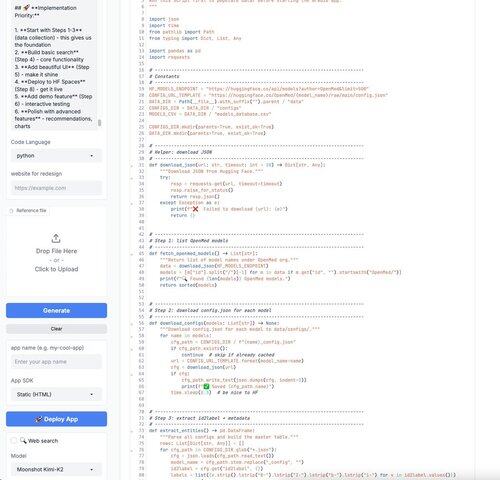

Domenica perfetta: ho appena usato Kimi-K2 di @Kimi_Moonshot per vibrare codice in un'app @Gradio! 🔥

Puoi usare lo "Anycoder" Space di @_akhaliq ospitato su @huggingface gratuitamente. È stato super veloce! 🤗

PS: Sono consapevole di usare Gradio per vibrare codice in un altro Gradio! Gioco di parole molto voluto qui! 😂

15K

clem 🤗 ha ripubblicato

Ecco perché abbiamo deciso di (1) rendere Cline open source e (2) non includere la rivendita delle inferenze nel nostro modello di business:

Quando controlli l'inferenza (le chiamate al modello AI) e noi costruiamo il sistema (il sistema che dirige quelle chiamate), nessuna delle due parti può oscurare ciò che sta accadendo.

Vedi esattamente quali modelli vengono chiamati, quanto contesto viene utilizzato, quali decisioni vengono prese. Non possiamo degradare silenziosamente le prestazioni per migliorare i margini perché stai pagando direttamente il fornitore di inferenze.

Questa separazione significa che abbiamo successo solo quando Cline diventa più capace. Non quando troviamo modi ingegnosi per ridurre il tuo utilizzo di token. Non quando indirizziamo a modelli più economici senza dirti nulla. Non quando limitiamo artificialmente le finestre di contesto.

Il risultato: Cline utilizza il modello giusto per ogni compito (come definito da te), integra qualsiasi strumento tu abbia bisogno tramite MCP e opera senza vincoli arbitrari. Ottieni accesso puro e non filtrato alle capacità dell'AI.

Abbiamo costruito in questo modo perché quando gli incentivi sono allineati correttamente, non hai bisogno di fidarti di noi. L'architettura stessa garantisce che stiamo lavorando verso lo stesso obiettivo: l'esperienza di codifica AI più potente possibile.

La conclusione è che Cline ti offre le migliori prestazioni possibili dai migliori modelli, punto.

153,1K

clem 🤗 ha ripubblicato

Nel nostro benchmark interno di editing "Hard" per i casi in cui un modello di frontiera ha precedentemente fallito un'editing diff (prima dei nostri aggiornamenti all'algoritmo diff), Kimi ha superato Claude 3.5.

Sarà interessante vedere i risultati dei nostri benchmark "Nightmare Difficulty" nelle prossime settimane.

14,76K

clem 🤗 ha ripubblicato

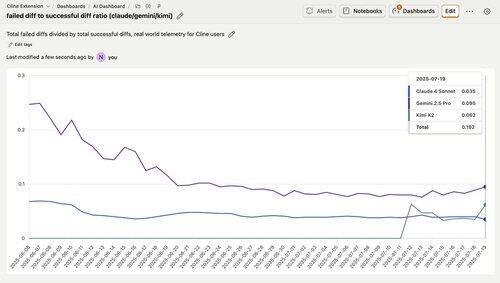

Vorrei sottolineare che per i compiti del mondo reale (non benchmark), Kimi K2 supera Gemini.

Questa è la telemetria di tutti gli utenti @cline, che mostra il tasso di errore nelle modifiche. Nota come Kimi abbia circa un tasso di errore del 6%, che è significativamente migliore rispetto al tasso di errore di circa il 10% di Gemini.

Incredibilmente, Kimi ha persino superato Claude 4 per la maggior parte di questa settimana, raggiungendo un tasso di errore inferiore al 4%!

159,03K

clem 🤗 ha ripubblicato

Dentro Hugging Face 🤗

Scott @GoingBallistic5 e io abbiamo avuto la possibilità di visitare e incontrare una delle menti appassionate dietro l'AI open-source.

Un enorme grazie a @AractingiMichel, @AdilZtn, e al team di @huggingface, @LeRobotHF per il caloroso benvenuto!

Il tour completo

11,51K

clem 🤗 ha ripubblicato

Smart Turn v2: rilevamento audio nativo open source in 14 lingue.

Nuovo checkpoint del modello VAD semantico open source, open data, open training code su @huggingface, @FAL e @pipecat_ai.

- Inferenza 3 volte più veloce (12ms su un L40)

- 14 lingue (13 in più rispetto alla v1, che era solo in inglese)

- Nuovo set di dati sintetici `chirp_3_all` con ~163k campioni audio

- 99% di accuratezza sui dati di test `human_5_all` tenuti da parte

Un buon rilevamento dei turni è fondamentale per gli agenti vocali. Questo modello "comprende" sia i modelli semantici che quelli audio, e mitiga il compromesso dell'AI vocale tra la latenza indesiderata del turno e l'agente che interrompe le persone prima che abbiano finito di parlare.

Gli script di addestramento per @modal_labs e l'addestramento locale sono nel repository. Vogliamo rendere il più semplice possibile contribuire o personalizzare questo modello!

Ecco una demo che esegue il modello smart-turn con impostazioni predefinite, mirata a raggiungere generalmente 400ms di tempo totale di rilevamento del turno. Puoi anche regolare le impostazioni per essere più veloce.

Puoi aiutare contribuendo con dati, facendo esperimenti sull'architettura o pulendo i dati open source! Continua a leggere ...

36,9K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari