Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

clem 🤗

Cofundador y CEO @HuggingFace🤗, la plataforma abierta y colaborativa para los constructores de IA

clem 🤗 reposteó

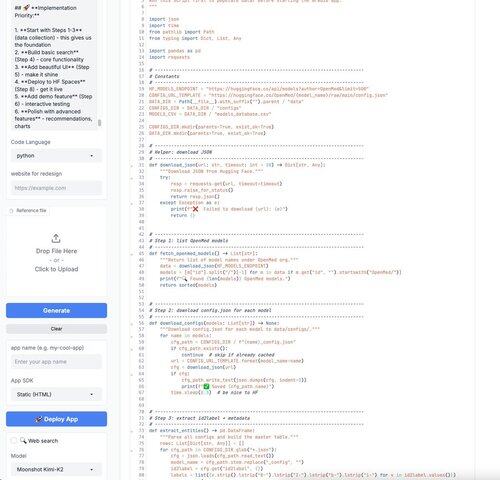

Domingo perfecto: ¡Acabo de usar Kimi-K2 de @Kimi_Moonshot para codificar una aplicación de @Gradio vibración! 🔥

Puede usar el espacio "Anycoder" de @_akhaliq alojado en @huggingface de forma gratuita. ¡Fue súper rápido! 🤗

PD: ¡Soy consciente de usar Gradio para codificar a otro Gradio! ¡Juego de palabras muy intencionado aquí! 😂

17.37K

clem 🤗 reposteó

He aquí por qué decidimos (1) hacer que Cline sea de código abierto y (2) no hacer que la reventa de inferencias sea parte de nuestro modelo de negocio:

Cuando controlas la inferencia (las llamadas del modelo de IA) y construimos el arnés (el sistema que dirige esas llamadas), ninguna de las partes puede ocultar lo que está sucediendo.

Ves exactamente qué modelos se llaman, cuánto contexto se usa, qué decisiones se toman. No podemos degradar silenciosamente el rendimiento para mejorar los márgenes porque está pagando directamente al proveedor de inferencia.

Esta separación significa que solo tenemos éxito cuando Cline se vuelve más capaz. No cuando encontramos formas inteligentes de reducir el uso de tokens. No cuando nos dirigimos a modelos más baratos sin decírtelo. No cuando limitamos artificialmente las ventanas de contexto.

El resultado: Cline utiliza el modelo adecuado para cada tarea (según lo definido por usted), integra cualquier herramienta que necesite a través de MCP y opera sin restricciones arbitrarias. Obtiene acceso puro y sin filtros a la capacidad de IA.

Construimos de esta manera porque cuando los incentivos se alinean correctamente, no necesita confiar en nosotros. La arquitectura en sí garantiza que estamos trabajando hacia el mismo objetivo: la experiencia de codificación de IA más poderosa posible.

La conclusión es que Cline le brinda el mejor rendimiento posible de los mejores modelos, punto final.

153.1K

clem 🤗 reposteó

En nuestro punto de referencia interno de edición de diferencias "Duro" para los casos en los que un modelo de frontera falló previamente en una edición de diferencias (antes de las actualizaciones de nuestro algoritmo de diferencias), Kimi superó a Claude 3.5.

Será interesante ver los resultados de nuestros puntos de referencia de "Dificultad de pesadilla" en las próximas semanas.

14.76K

clem 🤗 reposteó

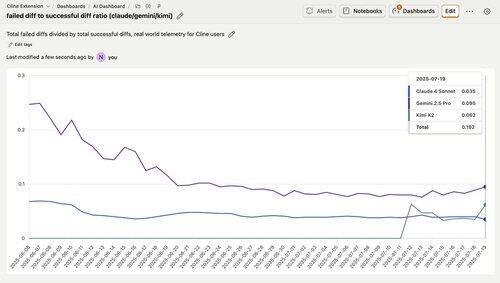

Me gustaría señalar que para las tareas del mundo real (no los puntos de referencia), Kimi K2 supera a Gemini.

Se trata de telemetría en todos los usuarios @cline, que muestra la tasa de errores de edición de diferencias. Observe cómo Kimi tiene una tasa de falla de aproximadamente el 6%, que es significativamente mejor que la tasa de error de ~ 10% de Gemini.

Sorprendentemente, Kimi incluso superó a Claude 4 durante la mayor parte de esta semana, ¡logrando una tasa de fracaso inferior al 4%!

159.03K

clem 🤗 reposteó

Dentro de la cara 🤗 abrazadora

Scott @GoingBallistic5 y yo tuvimos la oportunidad de visitar y conocer a una de las mentes apasionadas detrás de la IA de código abierto.

¡Muchas gracias a @AractingiMichel, @AdilZtn y @huggingface, @LeRobotHF equipo por la cálida bienvenida!

El recorrido completo

11.51K

clem 🤗 reposteó

🎶 Conozca Audio-Flamingo 3, un LALM completamente abierto entrenado en conjuntos de datos de sonido, voz y música. 🎶

Maneja conversaciones de audio, texto de formato largo y voz de 10 minutos. Perfecto para control de calidad de audio, diálogo y razonamiento.

En @huggingface ➡️

De #NVIDIAResearch.

26.21K

clem 🤗 reposteó

Smart Turn v2: detección de giros de audio nativo de código abierto en 14 idiomas.

Nuevo punto de control del código abierto, datos abiertos, código de entrenamiento abierto, modelo VAD semántico en @huggingface, @FAL y @pipecat_ai.

- Inferencia 3 veces más rápida (12 ms en un L40)

- 14 idiomas (13 más que la v1, que era solo en inglés)

- Nuevo conjunto de datos sintéticos 'chirp_3_all' con ~163k muestras de audio

- Precisión del 99 % en los datos de prueba "human_5_all"

Una buena detección de giros es fundamental para los agentes de voz. Este modelo "entiende" los patrones semánticos y de audio, y mitiga el equilibrio de la IA de voz entre la latencia de turno no deseada y el agente que interrumpe a las personas antes de que terminen de hablar.

Los scripts de entrenamiento para el entrenamiento @modal_labs y local se encuentran en el repositorio. ¡Queremos que sea lo más fácil posible contribuir o personalizar este modelo!

Aquí hay una demostración que ejecuta el modelo de giro inteligente con la configuración predeterminada, destinada a alcanzar generalmente un tiempo total de detección de giro de 400 ms. También puedes ajustar las cosas para que sean más rápidas.

¡Puedes ayudar contribuyendo con datos, haciendo experimentos de arquitectura o limpiando datos de código abierto! Sigue leyendo...

36.9K

Populares

Ranking

Favoritas

Onchain en tendencia

Tendencia en X

Principales fondos recientes

Más destacadas