Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Misha Laskin

Mitbegründer, CEO bei @reflection_ai.

Zurück: Wissenschaftlicher Mitarbeiter @DeepMind.

Gemini RL Team.

Misha Laskin erneut gepostet

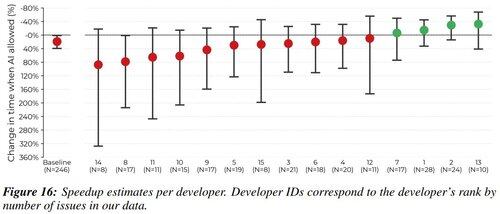

Ich war einer der 16 Entwickler in dieser Studie. Ich wollte meine Meinungen zu den Ursachen und Strategien zur Minderung der Verlangsamung von Entwicklern äußern.

Ich werde als "Warum sollte man dir zuhören?" Aufhänger sagen, dass ich einen -38% AI-Geschwindigkeitsrückgang bei meinen zugewiesenen Aufgaben erlebt habe. Ich denke, Transparenz hilft der Gemeinschaft.

1,96M

Die größte Frage in der RL-Forschung war immer - in welcher Umgebung trainierst du?

Früher waren es Video- (Atari) und Brettspiele (Go / Schach).

Aber jetzt, wo RL mit LLMs funktioniert, gibt es nur eine Umgebung, die zählt. Und das ist dein Produkt.

Kevin Lu10. Juli, 00:01

Warum Sie aufhören sollten, an RL-Forschung zu arbeiten, und stattdessen an Produkten arbeiten sollten //

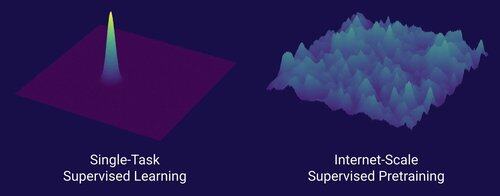

Die Technologie, die den großen Skalierungswechsel in der KI ermöglicht hat, ist das Internet, nicht die Transformer.

Ich denke, es ist allgemein bekannt, dass Daten das Wichtigste in der KI sind und dass Forscher sich trotzdem entscheiden, nicht daran zu arbeiten. ... Was bedeutet es, an Daten (in skalierbarer Weise) zu arbeiten?

Das Internet bot eine reiche Quelle an reichhaltigen Daten, die vielfältig waren, einen natürlichen Lehrplan boten, die Kompetenzen repräsentierten, die den Menschen tatsächlich wichtig sind, und eine wirtschaftlich tragfähige Technologie darstellten, die in großem Maßstab eingesetzt werden konnte – es wurde die perfekte Ergänzung zur Vorhersage des nächsten Tokens und war die Ursuppe, damit die KI abheben konnte.

Ohne Transformer hätten viele Ansätze erfolgreich sein können, wir könnten wahrscheinlich CNNs oder Zustandsraummodelle auf dem Niveau von GPT-4.5 haben. Aber es gab seit GPT-4 keine dramatische Verbesserung der Basismodelle. Denkmodelle sind in engen Bereichen großartig, aber nicht so ein großer Sprung wie GPT-4 im März 2023 (vor über 2 Jahren...)

Wir haben etwas Großartiges mit Reinforcement Learning, aber meine große Angst ist, dass wir die Fehler der Vergangenheit (Ära RL 2015-2020) wiederholen und RL-Forschung betreiben, die nicht relevant ist.

So wie das Internet das Dual von überwachtem Pretraining war, was wird das Dual von RL sein, das zu einem massiven Fortschritt wie von GPT-1 zu GPT-4 führen wird? Ich denke, es sieht nach einer Co-Design-Forschung für Produkte aus.

10,74K

Misha Laskin erneut gepostet

Es ist einfach, kleine Modelle mit RL so anzupassen, dass sie bei vertikalen Aufgaben besser abschneiden als Grundmodelle.

Wir veröffentlichen Osmosis-Apply-1.7B als Open Source: ein kleines Modell, das Code (ähnlich wie Cursors Instant Apply) besser zusammenführt als Grundmodelle.

Links zum Herunterladen und Ausprobieren des Modells finden Sie unten!

111,39K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten