Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Misha Laskin

Đồng sáng lập, Giám đốc điều hành tại @reflection_ai.

Prev: Nhà khoa học nghiên cứu nhân viên @DeepMind.

Đội Gemini RL.

Misha Laskin đã đăng lại

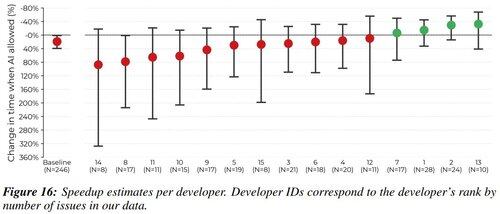

Tôi là một trong 16 lập trình viên trong nghiên cứu này. Tôi muốn chia sẻ ý kiến của mình về nguyên nhân và các chiến lược giảm thiểu tình trạng chậm tiến độ của lập trình viên.

Tôi sẽ nói như một cách để thu hút sự chú ý "tại sao phải lắng nghe bạn?" rằng tôi đã trải qua sự giảm tốc độ AI -38% trên các vấn đề được giao cho mình. Tôi nghĩ rằng sự minh bạch sẽ giúp ích cho cộng đồng.

1,96M

Câu hỏi lớn nhất trong nghiên cứu RL luôn là - bạn đang đào tạo trong môi trường nào?

Trước đây, đó là các trò chơi video (Atari) và trò chơi bàn (Go / Cờ vua).

Nhưng bây giờ khi RL hoạt động với LLMs, chỉ có một môi trường quan trọng. Và đó chính là sản phẩm của bạn.

Kevin Lu00:01 10 thg 7

Tại sao bạn nên ngừng làm nghiên cứu RL và thay vào đó làm việc với sản phẩm //

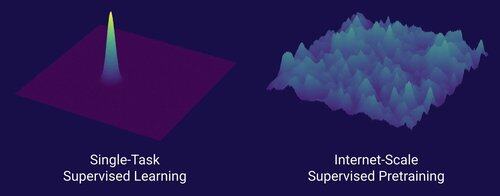

Công nghệ đã mở ra sự chuyển mình lớn trong AI chính là internet, không phải transformers

Tôi nghĩ rằng điều này đã được biết đến rộng rãi rằng dữ liệu là điều quan trọng nhất trong AI, và cũng rằng các nhà nghiên cứu chọn không làm việc với nó. ... Điều đó có nghĩa là gì khi làm việc với dữ liệu (một cách có thể mở rộng)?

Internet đã cung cấp một nguồn dữ liệu phong phú, dồi dào, đa dạng, cung cấp một chương trình học tự nhiên, đại diện cho các năng lực mà mọi người thực sự quan tâm, và là một công nghệ khả thi về mặt kinh tế để triển khai ở quy mô lớn -- nó đã trở thành sự bổ sung hoàn hảo cho dự đoán token tiếp theo và là bể nguyên thủy cho AI phát triển.

Nếu không có transformers, bất kỳ số lượng phương pháp nào cũng có thể đã phát triển, chúng ta có thể có CNNs hoặc các mô hình không gian trạng thái ở cấp độ của GPT-4.5. Nhưng không có sự cải thiện đáng kể nào trong các mô hình cơ bản kể từ GPT-4. Các mô hình lý luận rất tuyệt vời trong các lĩnh vực hẹp, nhưng không phải là một bước nhảy vọt lớn như GPT-4 đã làm vào tháng 3 năm 2023 (hơn 2 năm trước...)

Chúng ta có điều gì đó tuyệt vời với học tăng cường, nhưng nỗi sợ sâu sắc của tôi là chúng ta sẽ lặp lại những sai lầm của quá khứ (thời kỳ RL 2015-2020) và thực hiện nghiên cứu RL không có ý nghĩa.

Theo cách mà internet là đối ngẫu của việc huấn luyện trước có giám sát, điều gì sẽ là đối ngẫu của RL dẫn đến một sự tiến bộ lớn như GPT-1 -> GPT-4? Tôi nghĩ rằng nó giống như thiết kế đồng nghiên cứu-sản phẩm.

10,68K

Misha Laskin đã đăng lại

Thật dễ dàng để tinh chỉnh các mô hình nhỏ bằng RL để vượt trội hơn các mô hình nền tảng trong các nhiệm vụ theo chiều dọc.

Chúng tôi đang mở mã nguồn Osmosis-Apply-1.7B: một mô hình nhỏ kết hợp mã (tương tự như áp dụng ngay lập tức của Cursor) tốt hơn các mô hình nền tảng.

Liên kết để tải xuống và thử nghiệm mô hình bên dưới!

111,37K

Hàng đầu

Thứ hạng

Yêu thích

Onchain thịnh hành

Thịnh hành trên X

Ví funding hàng đầu gần đây

Được chú ý nhất