Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Misha Laskin

Co-fondatore, CEO di @reflection_ai.

Prec: Ricercatore del personale @DeepMind.

Squadra Gemini RL.

Misha Laskin ha ripubblicato

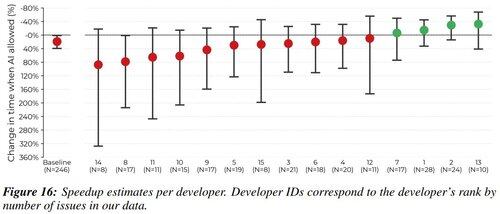

Ero uno dei 16 sviluppatori in questo studio. Volevo esprimere le mie opinioni sulle cause e le strategie di mitigazione per il rallentamento degli sviluppatori.

Dirò come un gancio "perché dovremmo ascoltarti?" che ho sperimentato un -38% di accelerazione AI sui miei problemi assegnati. Penso che la trasparenza aiuti la comunità.

1,96M

La domanda più grande nella ricerca RL è sempre stata: su quale ambiente stai addestrando?

Un tempo erano i giochi video (Atari) e i giochi da tavolo (Go / Scacchi).

Ma ora che RL funziona con LLM, c'è solo un ambiente che conta. Ed è il tuo prodotto.

Kevin Lu10 lug, 00:01

Perché dovresti smettere di lavorare sulla ricerca in RL e invece lavorare sul prodotto //

La tecnologia che ha sbloccato il grande cambiamento di scala nell'IA è internet, non i trasformatori.

Penso sia ben noto che i dati sono la cosa più importante nell'IA, e anche che i ricercatori scelgono comunque di non lavorarci. ... Cosa significa lavorare sui dati (in modo scalabile)?

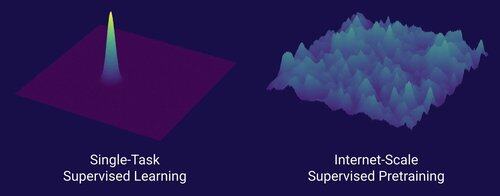

Internet ha fornito una ricca fonte di dati abbondanti, che erano diversificati, fornivano un curriculum naturale, rappresentavano le competenze di cui le persone si preoccupano realmente, ed era una tecnologia economicamente sostenibile da implementare su larga scala -- è diventato il complemento perfetto per la previsione del prossimo token ed è stata la zuppa primordiale per il decollo dell'IA.

Senza i trasformatori, qualsiasi numero di approcci avrebbe potuto decollare, probabilmente avremmo potuto avere CNN o modelli di spazio degli stati al livello di GPT-4.5. Ma non c'è stata un miglioramento drammatico nei modelli di base da GPT-4. I modelli di ragionamento sono ottimi in domini ristretti, ma non sono stati un salto così grande come GPT-4 lo è stato a marzo 2023 (più di 2 anni fa...)

Abbiamo qualcosa di grande con l'apprendimento per rinforzo, ma la mia profonda paura è che ripeteremo gli errori del passato (era RL 2015-2020) e faremo ricerca in RL che non conta.

Nel modo in cui internet era il duale del pre-addestramento supervisionato, quale sarà il duale dell'RL che porterà a un avanzamento massiccio come GPT-1 -> GPT-4? Penso che assomigli a una co-progettazione ricerca-prodotto.

10,66K

Misha Laskin ha ripubblicato

È facile ottimizzare piccoli modelli con RL per superare i modelli di base in compiti verticali.

Stiamo rendendo open source Osmosis-Apply-1.7B: un piccolo modello che unisce il codice (simile all'applicazione istantanea di Cursor) meglio dei modelli di base.

Link per scaricare e provare il modello qui sotto!

111,36K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari