Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Misha Laskin

Сооснователь, генеральный директор компании @reflection_ai.

Предыдущая: Штатный научный сотрудник @DeepMind.

Команда Gemini RL.

Misha Laskin сделал репост

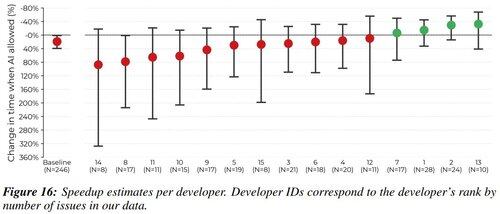

Я был одним из 16 разработчиков в этом исследовании. Я хотел высказать свое мнение о причинах и стратегиях смягчения замедления разработки.

Скажу в качестве крючка "почему вам стоит меня слушать?", что я испытал -38% ускорения ИИ по своим назначенным задачам. Я думаю, что прозрачность помогает сообществу.

1,96M

Самый главный вопрос в исследовании RL всегда был - в какой среде вы проводите обучение?

Ранее это были видеоигры (Atari) и настольные игры (Го / Шахматы).

Но теперь, когда RL работает с LLM, есть только одна среда, которая имеет значение. И это ваш продукт.

Kevin Lu10 июл., 00:01

Почему вам следует прекратить заниматься исследованиями в области RL и вместо этого работать над продуктом //

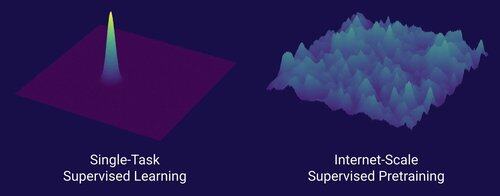

Технология, которая открыла большой сдвиг в масштабировании ИИ, — это интернет, а не трансформеры.

Я думаю, что хорошо известно, что данные — это самая важная вещь в ИИ, и также то, что исследователи все равно выбирают не работать над ними. ... Что значит работать с данными (масштабируемым образом)?

Интернет предоставил богатый источник обильных данных, которые были разнообразными, обеспечивали естественную учебную программу, представляли собой компетенции, которые действительно интересуют людей, и были экономически жизнеспособной технологией для развертывания в масштабе — он стал идеальным дополнением к предсказанию следующего токена и был первобытным бульоном для взлета ИИ.

Без трансформеров любое количество подходов могло бы взлететь, мы, вероятно, могли бы иметь CNN или модели пространственного состояния на уровне GPT-4.5. Но с тех пор, как появился GPT-4, не было драматического улучшения базовых моделей. Модели рассуждений хороши в узких областях, но не представляют собой такой огромный скачок, как GPT-4 в марте 2023 года (более 2 лет назад...)

У нас есть что-то великое с обучением с подкреплением, но мой глубокий страх заключается в том, что мы повторим ошибки прошлого (эпоха RL 2015-2020) и будем заниматься исследованиями RL, которые не имеют значения.

Таким образом, как интернет был двойником контролируемого предварительного обучения, что будет двойником RL, который приведет к массовому прогрессу, подобному GPT-1 -> GPT-4? Я думаю, что это похоже на совместное проектирование исследований и продуктов.

10,69K

Misha Laskin сделал репост

Легко настроить небольшие модели с помощью RL, чтобы они превосходили базовые модели в вертикальных задачах.

Мы открываем исходный код Osmosis-Apply-1.7B: небольшая модель, которая лучше объединяет код (аналогично мгновенному применению Cursor), чем базовые модели.

Ссылки для загрузки и тестирования модели ниже!

111,38K

Топ

Рейтинг

Избранное

В тренде ончейн

В тренде в Х

Самые инвестируемые

Наиболее известные