Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Misha Laskin

Współzałożyciel, CEO w @reflection_ai.

Poprzednia: Pracownik naukowy @DeepMind.

Zespół Gemini RL.

Użytkownik Misha Laskin udostępnił ponownie

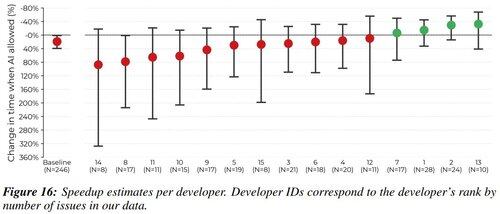

Byłem jednym z 16 deweloperów w tym badaniu. Chciałem podzielić się moimi opiniami na temat przyczyn i strategii łagodzenia spowolnienia deweloperów.

Powiem jako haczyk "dlaczego miałbym cię słuchać?", że doświadczyłem -38% przyspieszenia AI w moich przypisanych zadaniach. Uważam, że przejrzystość pomaga społeczności.

1,96M

Największym pytaniem w badaniach nad RL zawsze było - w jakim środowisku trenujesz?

Kiedyś były to gry wideo (Atari) i planszowe (Go / Szachy).

Ale teraz, gdy RL działa z LLM, istnieje tylko jedno środowisko, które ma znaczenie. I jest to twój produkt.

Kevin Lu10 lip, 00:01

Dlaczego powinieneś przestać pracować nad badaniami RL i zamiast tego skupić się na produkcie //

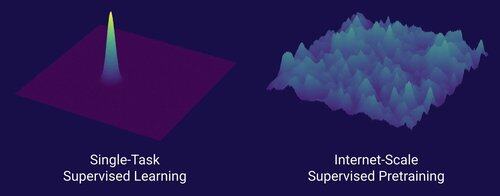

Technologia, która umożliwiła wielką zmianę w skalowaniu AI, to internet, a nie transformatory.

Myślę, że powszechnie wiadomo, że dane są najważniejszą rzeczą w AI, a także że badacze i tak decydują się nie pracować nad nimi. ... Co to znaczy pracować nad danymi (w sposób skalowalny)?

Internet dostarczył bogate źródło obfitych danych, które były różnorodne, oferowały naturalny program nauczania, reprezentowały kompetencje, na których ludziom naprawdę zależy, i były ekonomicznie opłacalną technologią do wdrożenia na dużą skalę -- stał się idealnym uzupełnieniem przewidywania następnego tokena i pierwotną zupą, z której AI mogło się rozwijać.

Bez transformerów, jakiekolwiek podejście mogłoby się rozwinąć, prawdopodobnie moglibyśmy mieć CNN lub modele przestrzeni stanów na poziomie GPT-4.5. Ale nie było dramatycznej poprawy w modelach bazowych od czasu GPT-4. Modele rozumowania są świetne w wąskich dziedzinach, ale nie stanowią tak ogromnego skoku, jakim był GPT-4 w marcu 2023 roku (ponad 2 lata temu...)

Mamy coś wspaniałego z uczeniem przez wzmocnienie, ale moim głębokim lękiem jest to, że powtórzymy błędy przeszłości (era RL 2015-2020) i będziemy prowadzić badania RL, które nie mają znaczenia.

W taki sposób, w jaki internet był dualem nadzorowanego wstępnego uczenia, czym będzie dual RL, który doprowadzi do ogromnego postępu, jak GPT-1 -> GPT-4? Myślę, że wygląda to jak współprojektowanie badań i produktu.

10,67K

Użytkownik Misha Laskin udostępnił ponownie

Łatwo jest dostosować małe modele za pomocą RL, aby przewyższały modele bazowe w zadaniach pionowych.

Udostępniamy na otwartym źródle Osmosis-Apply-1.7B: mały model, który lepiej łączy kod (podobnie jak natychmiastowe zastosowanie Cursor) niż modele bazowe.

Linki do pobrania i wypróbowania modelu poniżej!

111,37K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi