Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ich war einer der 16 Entwickler in dieser Studie. Ich wollte meine Meinungen zu den Ursachen und Strategien zur Minderung der Verlangsamung von Entwicklern äußern.

Ich werde als "Warum sollte man dir zuhören?" Aufhänger sagen, dass ich einen -38% AI-Geschwindigkeitsrückgang bei meinen zugewiesenen Aufgaben erlebt habe. Ich denke, Transparenz hilft der Gemeinschaft.

11. Juli, 01:23

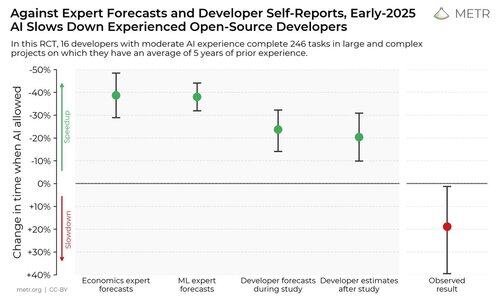

Wir haben eine randomisierte kontrollierte Studie durchgeführt, um zu sehen, wie sehr KI-Coding-Tools erfahrene Open-Source-Entwickler beschleunigen.

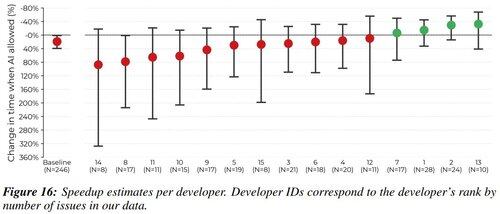

Die Ergebnisse haben uns überrascht: Die Entwickler dachten, sie seien mit KI-Tools 20 % schneller, tatsächlich waren sie jedoch 19 % langsamer, wenn sie Zugang zu KI hatten, als wenn sie keinen hatten.

Zunächst denke ich, dass die Beschleunigung durch KI nur schwach mit den Fähigkeiten eines Entwicklers korreliert. Alle Entwickler in dieser Studie sind sehr gut. Ich denke, es hat mehr mit dem Verfallen in Fehlerzustände zu tun, sowohl mit der Fähigkeit des LLM als auch mit dem Workflow des Menschen. Ich arbeite mit einer Menge großartiger Pretraining-Entwickler, und ich denke, die Leute stehen vor vielen der gleichen Probleme.

Wir sagen gerne, dass LLMs Werkzeuge sind, behandeln sie aber eher wie eine Wunderwaffe.

Jeder Entwickler kann die Zufriedenheit bezeugen, endlich ein kniffliges Problem zu debuggen. LLMs sind ein großer Dopamin-Abkürzungsbutton, der dein Problem möglicherweise auf einen Schlag löst. Drückst du weiter den Knopf, der eine 1% Chance hat, alles zu beheben? Es ist auf jeden Fall viel angenehmer als die mühsame Alternative, zumindest für mich.

Ich denke, Fälle von LLM-Übernutzung können auftreten, weil es einfach ist, für wahrgenommenes Vergnügen zu optimieren, anstatt für die Zeit bis zur Lösung während der Arbeit.

Ich drücke 5 Stunden lang die Tabulatortaste, anstatt 1 Stunde lang zu debuggen:

Drittens, es ist super einfach, sich in der Ausfallzeit ablenken zu lassen, während LLMs generieren. Die Aufmerksamkeitseconomie der sozialen Medien ist brutal, und ich denke, die Leute verbringen 30 Minuten mit Scrollen, während sie auf ihre 30-sekündige Generierung "warten".

Alles, was ich dazu sagen kann, ist, dass wir unsere eigenen Fallstricke kennen und versuchen sollten, diese LLM-Generierungszeit produktiv zu nutzen:

- Wenn die Aufgabe hohe Konzentration erfordert, nutze diese Zeit entweder, um an einer Teilaufgabe zu arbeiten oder über Folgefragen nachzudenken. Selbst wenn das Modell deine Frage sofort beantwortet, was verstehe ich sonst nicht?

- Wenn die Aufgabe geringe Konzentration erfordert, erledige in der Zwischenzeit eine andere kleine Aufgabe (E-Mail/Slack beantworten, einen anderen Absatz lesen oder bearbeiten usw.).

Wie immer helfen kleine digitale Hygieneschritte dabei (Website-Blocker, Handy auf lautlos usw.). Entschuldige, dass ich so griesgrämig bin, aber es funktioniert für mich :)

Einige abschließende Aussagen:

- METR ist eine wunderbare Organisation, mit der man arbeiten kann, und sie sind starke Wissenschaftler. Ich habe es geliebt, sowohl an dieser Studie teilzunehmen als auch ihre Ergebnisse zu lesen.

- Ich bin kein LLM-Guru, der predigen will. Betrachten Sie dies als einen persönlichen Tagebucheintrag von mir, in der Hoffnung, dass andere von meiner Introspektion profitieren können.

1,96M

Top

Ranking

Favoriten