Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

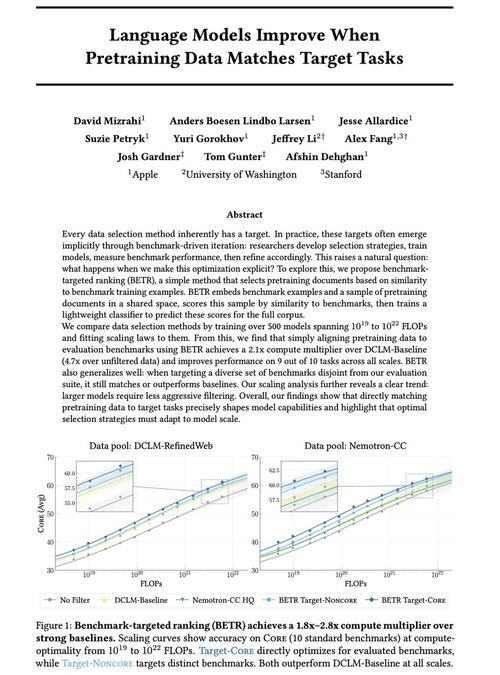

Vi är glada över att dela med oss av vårt nya arbete: "Språkmodeller förbättras när förträningsdata matchar måluppgifter"

Ja, det låter självklart (och det är det!), men vanligtvis sker detta bara implicit och indirekt: välj intuitivt data → benchmarka → förfina → upprepa.

Vi undrade: vad händer om vi uttryckligen matchar förträningsdata med riktmärken? Resultatet är en mycket enkel metod som ger 2x+ beräkningsmultiplikatorer över starka baslinjer och ger oss ett principiellt sätt att studera hur benchmarkval formar (och begränsar!) modellfunktioner.

Bonus: omfattande skalningslagar från träning av 500+ modeller som avslöjar hur optimalt dataval utvecklas när modellerna skalas.

🧵 Betyg (1/14)

52,01K

Topp

Rankning

Favoriter