トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

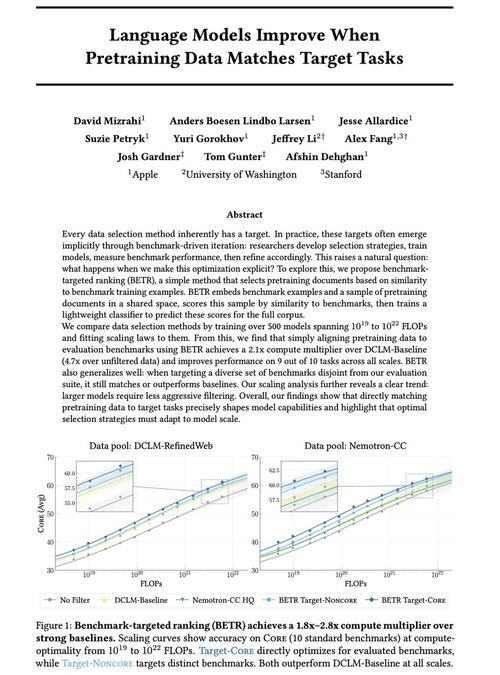

私たちの新しい研究「事前トレーニングデータがターゲットタスクと一致すると言語モデルが改善される」を共有できることを嬉しく思います

はい、当たり前のことのように聞こえますが(実際はそうです!)、通常、これは暗黙的かつ間接的にのみ起こり、ベンチマーク→データを直感的に選択し、改良→繰り返す→です。

私たちは、事前トレーニングデータをベンチマークと明示的に一致させるとどうなるのか疑問に思いました。その結果、強力なベースラインで 2x+ のコンピューティング乗数が得られ、ベンチマークの選択がモデルの機能をどのように形成 (および制約) するかを研究するための原則的な方法を提供する、非常に単純なアプローチが実現しました。

ボーナス: 500+ モデルのトレーニングによる広範なスケーリング法則により、モデルのスケーリングに応じて最適なデータ選択がどのように進化するかが明らかになります。

🧵 (1/14)

51.99K

トップ

ランキング

お気に入り