Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

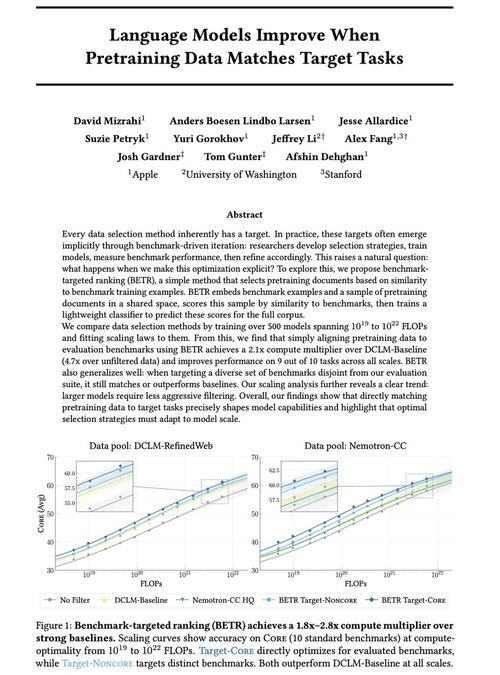

S radostí se s vámi podělíme o naši novou práci: "Jazykové modely se zlepšují, když předtrénovaná data odpovídají cílovým úkolům"

Ano, zní to samozřejmě (a je to tak!), ale obvykle se to děje pouze implicitně a nepřímo: intuitivně vyberte data → benchmarku → zpřesnit → opakovat.

Zajímalo nás: co se stane, když explicitně přiřadíme data z předtrénování k benchmarkům? Výsledkem je naprosto jednoduchý přístup, který poskytuje 2x+ výpočetních násobitelů na silných výchozích liniích a poskytuje nám principiální způsob, jak studovat, jak volby benchmarků utvářejí (a omezují!) možnosti modelu.

Bonus: rozsáhlé zákony škálování z trénování 500+ modelů, které odhalují, jak se optimální výběr dat vyvíjí s tím, jak se modely škálují.

🧵 Fotografie (1/14)

51,99K

Top

Hodnocení

Oblíbené