Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

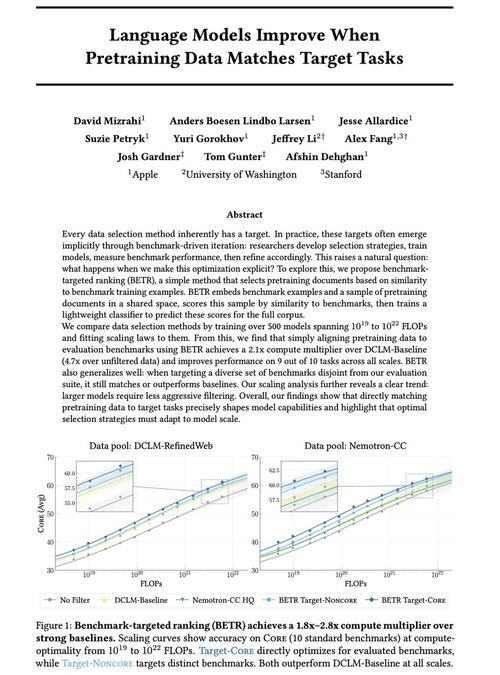

Suntem încântați să împărtășim noua noastră lucrare: "Modelele lingvistice se îmbunătățesc atunci când datele de preantrenament se potrivesc cu sarcinile țintă"

Da, sună evident (și este!), dar de obicei acest lucru se întâmplă doar implicit și indirect: selectați intuitiv datele → benchmark → rafinați → repetați.

Ne-am întrebat: ce se întâmplă dacă potrivim în mod explicit datele de pre-antrenament cu benchmark-urile? Rezultatul este o abordare simplă care produce multiplicatori de calcul de 2x+ pe linii de bază puternice și ne oferă o modalitate principială de a studia modul în care alegerile de referință modelează (și constrâng!) capabilitățile modelului.

Bonus: legi extinse de scalare din antrenarea a 500+ modele care dezvăluie modul în care selecția optimă a datelor evoluează pe măsură ce modelele se scalează.

🧵 (1/14)

52,01K

Limită superioară

Clasament

Favorite