熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

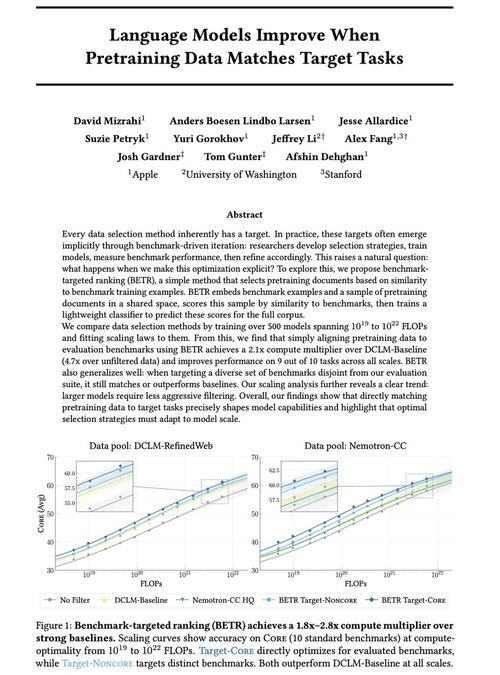

很高興與大家分享我們的新工作:「當預訓練數據與目標任務匹配時,語言模型會改善」

是的,這聽起來很明顯(而且確實如此!),但通常這僅僅是隱性和間接發生的:直觀地選擇數據 → 基準測試 → 精煉 → 重複。

我們想知道:如果我們明確地將預訓練數據與基準測試匹配,會發生什麼?結果是一種非常簡單的方法,能夠在強基準上產生2倍以上的計算增益,並為我們提供了一種原則性的方法來研究基準選擇如何塑造(和限制!)模型能力。

附加:從訓練500多個模型中獲得的廣泛擴展法則,揭示了隨著模型擴展,最佳數據選擇如何演變。

🧵 (1/14)

51.99K

熱門

排行

收藏