Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

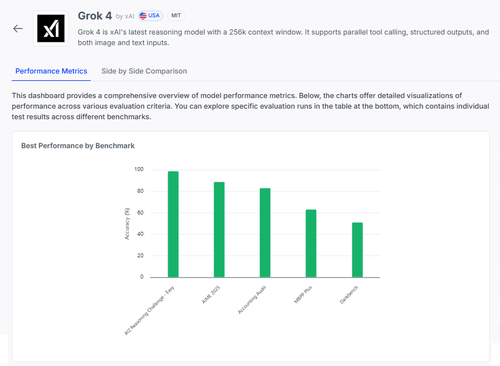

🧠 Grok 4 by @xai gör framsteg när det gäller att resonera benchmarks, men bilden är mer nyanserad än vad poängen antyder.

Här är hur det står sig – och vad vi verkligen kan lära oss av resultaten 🧵

📊 Fullständig utvärdering:

1️⃣ Grok 4 poäng:

• AI2 Reasoning Challenge (lätt): 98 %

• AIME 2025 (matematik): 89 %

• Redovisningsrevision: 84 %

• MMLU-Plus: 64 %

• Data4Health: 55 %

Det här är topresultat – men låt oss zooma in på vad som fungerar och vad som fortfarande misslyckas.

2️⃣ AIME 2025

✅ Behandlar algebra, geometri, talteori

✅ Följer LaTeX-formateringsregler

❌ Kämpar med logik i flera steg

❌ Fel i kombinatorik

❌ Problem med formatprecision (t.ex. saknas °)

3️⃣ Redovisning Revision

✅ Stark på etik och rapportering

✅ Gediget grepp om revisionsprinciper

❌ Feltolkar liknande förfaranden

❌ Misslyckas med att upptäcka subtila svarsskillnader

❌ Svårt att tillämpa teori på verkliga fall

4️⃣ Den verkliga insikten?

Även en modell med 98 % på vissa uppgifter kan misslyckas hårt under tvetydighet eller formateringsstress.

Benchmarks som AIME och Audit visar hur det misslyckas, inte bara hur mycket det får i poäng.

5️⃣ Varför detta är viktigt:

Vi behöver en transparent utvärdering per uppgift – inte bara topplistor.

#Grok4 är kraftfullt, men ändå sprött i verkliga domäner med höga insatser.

🧪 Utforska hela uppdelningen:

#AI #LLMs #Benchmarking

1,1K

Topp

Rankning

Favoriter